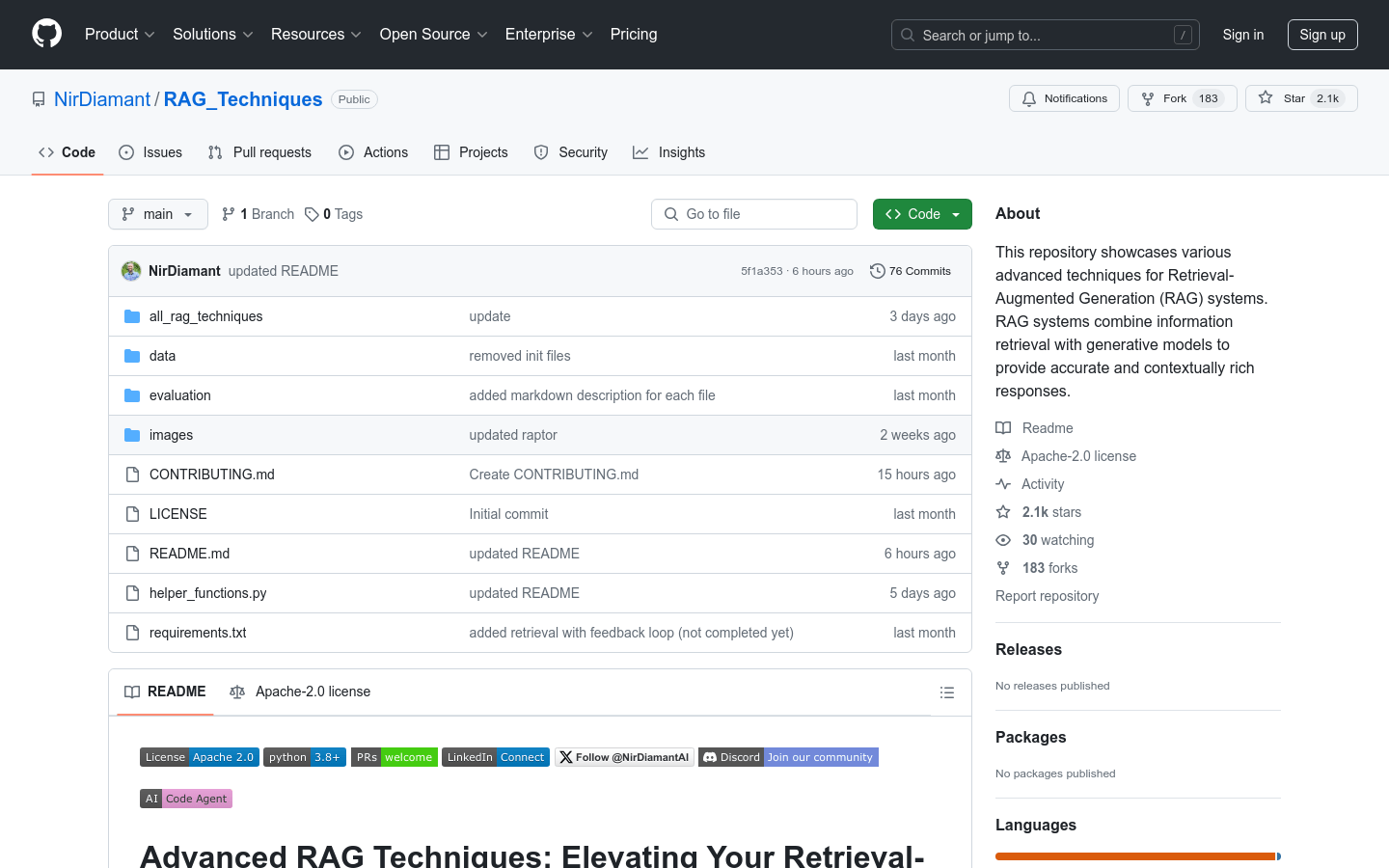

RAG_Techniques 是一个专注于检索增强生成(Retrieval-Augmented Generation, RAG)系统的技术集合,旨在提升系统的准确性、效率和上下文丰富性。它提供了一个前沿技术的中心,通过社区贡献和协作环境,推动RAG技术的发展和创新。

需求人群:

"RAG_Techniques 适合研究人员和实践者,他们希望探索和推动RAG技术的边界,通过这个资源中心,他们可以获取最新的技术进展和实现指南,共同促进AI领域的进步。"

使用场景示例:

使用Simple RAG技术为新入门者提供基础RAG方法

利用Context Enrichment Techniques通过扩展上下文提高检索精度

应用Multi-faceted Filtering技术进行结果的多方面过滤和质量提升

产品特色:

提供RAG系统的高级增强技术

包含详尽的文档和实践指导

定期更新以包含最新进展

支持社区贡献和讨论

使用教程:

克隆RAG_Techniques仓库到本地

导航至感兴趣的技术目录

遵循每个技术目录中的详细实现指南

浏览量:74

最新流量情况

月访问量

4.93m

平均访问时长

00:06:29

每次访问页数

6.10

跳出率

36.08%

流量来源

直接访问

54.82%

自然搜索

31.76%

邮件

0.04%

外链引荐

11.31%

社交媒体

1.86%

展示广告

0

截止目前所有流量趋势图

地理流量分布情况

中国

12.56%

德国

3.93%

印度

9.82%

俄罗斯

5.43%

美国

18.51%

一站式NLP API工具包

Tinq.ai是一个简单的自然语言处理工具,可帮助您轻松实现文本分析。它提供NER、情感分析、文本分类、摘要、问答、文本生成和语言检测等功能。Tinq.ai可以轻松地将强大的人工智能能力添加到您的应用程序中。

开源的RAG应用日志工具

RAG-logger是一个为检索增强生成(Retrieval-Augmented Generation, RAG)应用设计的开源日志工具。它是一个轻量级的、针对RAG特定日志需求的开源替代方案,专注于为RAG应用提供全面的日志记录功能,包括查询跟踪、检索结果记录、LLM交互记录以及逐步性能监控。它采用基于JSON的日志格式,支持每日日志组织、自动文件管理和元数据丰富化。RAG-logger以其开源、轻量级和专注于RAG应用的特性,为开发者提供了一个有效的工具来监控和分析RAG应用的性能。

利用NLP技术的AI高亮工具

Aighlight是一个基于NLP(自然语言处理)AI技术的Chrome插件,可以高亮显示纯文本。它可以提高阅读能力,帮助用户更好地理解长篇文字,并提取重要信息。该插件可以提升阅读速度、提高专注力,让阅读变得更加轻松。定价:免费。

NLP模型优化工具

Fine-Tuner是一款NLP模型优化工具,能够提供更好的结果、更少的数据和更短的时间。无需编码,通过Fine-Tuner可以构建智能AI代理,加快市场推广,并在不受技术复杂性或基础设施限制的情况下扩展智能解决方案。

掌握RAG技术,提升AI生成内容的准确性和相关性。

Retrieval-Augmented Generation (RAG) 是一种前沿技术,通过整合外部知识源来增强生成模型的能力,提高生成内容的质量和可靠性。LangChain是一个强大的框架,专为构建和部署稳健的语言模型应用而设计。本教程系列将提供全面的、分步骤的指南,帮助您使用LangChain实现RAG,从基础RAG流程的介绍开始,逐步深入到查询转换、文档嵌入、路由机制、查询构建、索引策略、检索技术以及生成阶段,最终将所有概念整合到一个实际场景中,展示RAG的强大和灵活性。

一个集成了Django、Llamaindex和Google Drive的RAG应用框架。

Omakase RAG Orchestrator是一个旨在解决构建RAG应用时遇到的挑战的项目,它通过提供一个综合的Web应用程序和API来封装大型语言模型(LLMs)及其包装器。该项目整合了Django、Llamaindex和Google Drive,以提高应用的可用性、可扩展性和数据及用户访问管理。

低代码生成AI应用程序的生成性AI RAG工具包。

create-tsi是一个生成性AI RAG(Retrieval-Augmented Generation)工具包,用于低代码生成AI应用程序。它利用LlamaIndex和T-Systems在Open Telekom Cloud上托管的大型语言模型(LLMs),简化了AI应用程序的创建过程,使其变得快捷、灵活。用户可以使用create-tsi生成聊天机器人、编写代理并针对特定用例进行定制。

一个适合学习、使用、自主扩展的RAG系统。

Easy-RAG是一个检索增强生成(RAG)系统,它不仅适合学习者了解和掌握RAG技术,同时也便于开发者使用和进行自主扩展。该系统通过集成知识图谱提取解析工具、rerank重新排序机制以及faiss向量数据库等技术,提高了检索效率和生成质量。

AI即服务,高性能NLP API

GooseAI是一款全托管的NLP即服务产品,通过API提供,价格是传统基础设施的30%,拥有GPT-Neo 1.3B、Fairseq 1.3B等多个模型,支持文本生成、问答、分类等多种功能。使用场景广泛,适用于生产力工具、图像、视频、设计、写作等领域。

一个为RAG(检索增强生成)AI助手设计的React组件,可快速集成到Next.js应用中。

该产品是一个React组件,专为RAG(检索增强生成)AI助手设计。它结合了Upstash Vector进行相似性搜索、Together AI作为LLM(大型语言模型)以及Vercel AI SDK用于流式响应。这种组件化设计使得开发者可以快速将RAG能力集成到Next.js应用中,极大地简化了开发流程,同时提供了高度的可定制性。其主要优点包括响应式设计、支持流式响应、持久化聊天历史以及支持暗黑/浅色模式等。该组件主要面向需要在Web应用中集成智能聊天功能的开发者,尤其是那些使用Next.js框架的团队。它通过简化集成过程,降低了开发成本,同时提供了强大的功能。

基于RAG(Retrieval-Augmented Generation)技术的智能对话系统

RAG Web UI 是一个基于 RAG 技术的智能对话系统,它结合了文档检索和大型语言模型,能够为企业和个人提供基于知识库的智能问答服务。该系统采用前后端分离架构,支持多种文档格式(如 PDF、DOCX、Markdown、Text)的智能管理,包括自动分块和向量化处理。其对话引擎支持多轮对话和引用标注,能够提供精准的知识检索和生成服务。该系统还支持高性能向量数据库(如 ChromaDB、Qdrant)的灵活切换,具有良好的扩展性和性能优化。作为一种开源项目,它为开发者提供了丰富的技术实现和应用场景,适合用于构建企业级知识管理系统或智能客服平台。

革命性的检索增强生成系统技术集合。

RAG_Techniques 是一个专注于检索增强生成(Retrieval-Augmented Generation, RAG)系统的技术集合,旨在提升系统的准确性、效率和上下文丰富性。它提供了一个前沿技术的中心,通过社区贡献和协作环境,推动RAG技术的发展和创新。

全面管理的AI搜索基础设施,支持RAG。

Ducky是一种全面管理的AI检索服务,专为那些需要快速准确结果的开发人员而设计。它支持语义搜索,包括检索增强生成(RAG),并且提供了简单明了的Python SDK,可以快速构建出色的搜索功能。

依托AI与NLP的文本自动查错与智能纠错系统。

无忧智能审核系统是一款基于大数据、人工智能(AI)和自然语言处理技术(NLP)的文本自动查错与智能纠错系统。它通过深度学习能够全面校对多种文本错误类型,有效提升人工检校效率,消除审校盲区,提升内容安全和文本质量。系统支持多种部署方式,包括嵌入版、整站审核和接口版,能够满足不同行业和场景的需求。

转录、研究、数据分析和NLP软件

Speak Ai是一款AI驱动的转录、研究、数据分析和NLP软件,帮助营销和研究团队将非结构化的音频、视频和文本转化为竞争优势。它提供自动转录、会议助手、数据可视化等功能,帮助用户节省时间、提高效率。

构建RAG驱动的内部工具

RagHost是一个提供简单API的服务,可以上传文档并进行查询。您可以在几分钟内构建一个内部工具,用于搜索文档或回答问题。RagHost使用检索增强生成技术,通过将上下文数据与问题一起提供给模型,从而为您的模型提供所需的上下文。您无需处理文档解析、分块和向量嵌入等复杂工作,我们为您完成。RagHost支持自定义的分块策略,并提供流式响应以确保用户获得及时的回答。我们正在开发公平定价策略,使您能够轻松使用RagHost而无需担心高额费用。

NLP+AI+ML打造的自愈式、可扩展的QA自动化测试工具

Virtuoso QA是一款集自然语言编程(NLP)和机器人流程自动化(RPA)于一体的QA自动化测试工具,具有自愈式和可扩展性,可实现快速部署。

消除幻觉,多模态RAG不忘信息,智能编排前沿模型,任务表现卓越

Sup AI是一款AI平台,具备实时对数概率置信度评分消除幻觉、多模态检索增强生成(RAG)避免遗忘、智能编排前沿模型等功能。其主要优点在于能在各种任务中展现绝对优势,适用于全球用户。产品于2025年创立,总部位于美国加利福尼亚州山景城。提供多种价格方案,包括免费计划供学生和普通用户使用,Plus计划面向开发者,Pro计划针对高级用户,Super计划适用于研究人员和团队。

开发者友好的RAG即服务。

Ragie是一款面向开发者的RAG(Retrieval-Augmented Generation)即服务产品,它通过易于使用的API和SDK,帮助开发者快速启动并实现生成式AI应用。Ragie具备高级功能,如LLM重排、摘要索引、实体提取等,确保提供精确可靠的信息。它还支持与Google Drive、Notion等流行数据源的直接连接,并支持自动同步,保持数据最新。Ragie由Craft Ventures领导,提供简单明了的定价策略,无需设置费用或隐藏成本。

一键式无服务器RAG平台

SciPhi是一个开源的端到端RAG平台,使构建、部署和优化系统变得简单。它提供直观的框架和抽象,可与LangChain等解决方案相比较。通过SciPhi,您可以轻松启动和扩展最好的RAG系统,并选择各种托管和远程提供商以满足您的需求。无论是自托管还是云部署选项都可用。

一个用于在网站上提问的Chrome扩展程序,支持本地运行和向量存储。

Site RAG 是一款 Chrome 扩展程序,旨在通过自然语言处理技术帮助用户在浏览网页时快速获取问题答案。它支持将当前页面内容作为上下文进行查询,还能将整个网站内容索引到向量数据库中,以便后续进行检索增强生成(RAG)。该产品完全在本地浏览器运行,确保用户数据安全,同时支持连接本地运行的 Ollama 实例进行推理。它主要面向需要快速从网页内容中提取信息的用户,如开发者、研究人员和学生。目前该产品免费提供,适合希望在浏览网页时获得即时帮助的用户。

企业级RAG优化模型,支持多语言

Command R+是一款先进的RAG优化模型,专为处理企业级工作负载而设计,首次在Microsoft Azure上推出。该模型具有128k令牌上下文窗口,提供最佳性能的先进检索增强生成(RAG)功能,支持10种关键语言的多语言覆盖,以及工具使用功能以自动化复杂的业务流程。定价为Command R+:$3.00/M输入令牌,$15.00/M输出令牌。该产品适用于各种企业场景,如金融、人力资源、销售、营销和客户支持等。

快速、准确的生产级RAG管道

Vectorize是一个专注于将非结构化数据转化为优化的向量搜索索引的平台,专为检索增强生成(RAG)而设计。它通过连接内容管理系统、文件系统、CRM、协作工具等多种数据源,帮助用户创建提高生产力的辅助系统和创新的客户体验。Vectorize的主要优点包括易于使用、快速部署和高精度的搜索结果,适合需要处理大量数据并希望快速实现AI应用的企业。

RAG-based LLM agents的Elo排名工具

RAGElo是一个工具集,使用Elo评分系统帮助选择最佳的基于检索增强生成(RAG)的大型语言模型(LLM)代理。随着生成性LLM在生产中的原型设计和整合变得更加容易,评估仍然是解决方案中最具有挑战性的部分。RAGElo通过比较不同RAG管道和提示对多个问题的答案,计算不同设置的排名,提供了一个良好的概览,了解哪些设置有效,哪些无效。

开源本地RAG,集成ChatGPT和MCP能力

Minima是一个开源的、完全本地化的RAG(Retrieval-Augmented Generation)模型,具备与ChatGPT和MCP(Model Context Protocol)集成的能力。它支持三种模式:完全本地安装、通过ChatGPT查询本地文档以及使用Anthropic Claude查询本地文件。Minima的主要优点包括本地化处理数据,保护隐私,以及能够利用强大的语言模型来增强检索和生成任务。产品背景信息显示,Minima支持多种文件格式,并允许用户自定义配置以适应不同的使用场景。Minima是免费开源的,定位于需要本地化AI解决方案的开发者和企业。

一站式RAG搜索SDK

Korvus是一个基于Postgres构建的搜索SDK,它将整个RAG(检索增强生成)流程统一到单一的数据库查询中。它提供了高性能、可定制的搜索能力,同时最小化了基础设施的考虑。Korvus利用PostgresML的pgml扩展和pgvector扩展,将RAG流程压缩在Postgres内部。它支持多语言SDK,包括Python、JavaScript、Rust和C,允许开发者无缝集成到现有的技术栈中。

智能搜索API,提供高效信息检索。

RAG Search API是一个由thinkany.ai开发的智能搜索API,它利用RAG(Retrieval-Augmented Generation)技术,结合了检索和生成的特点,为用户提供高效、准确的信息检索服务。该API支持自定义配置,包括搜索数量、是否进行重排、过滤等,能够满足不同用户的需求。

© 2026 AIbase 备案号:闽ICP备08105208号-14