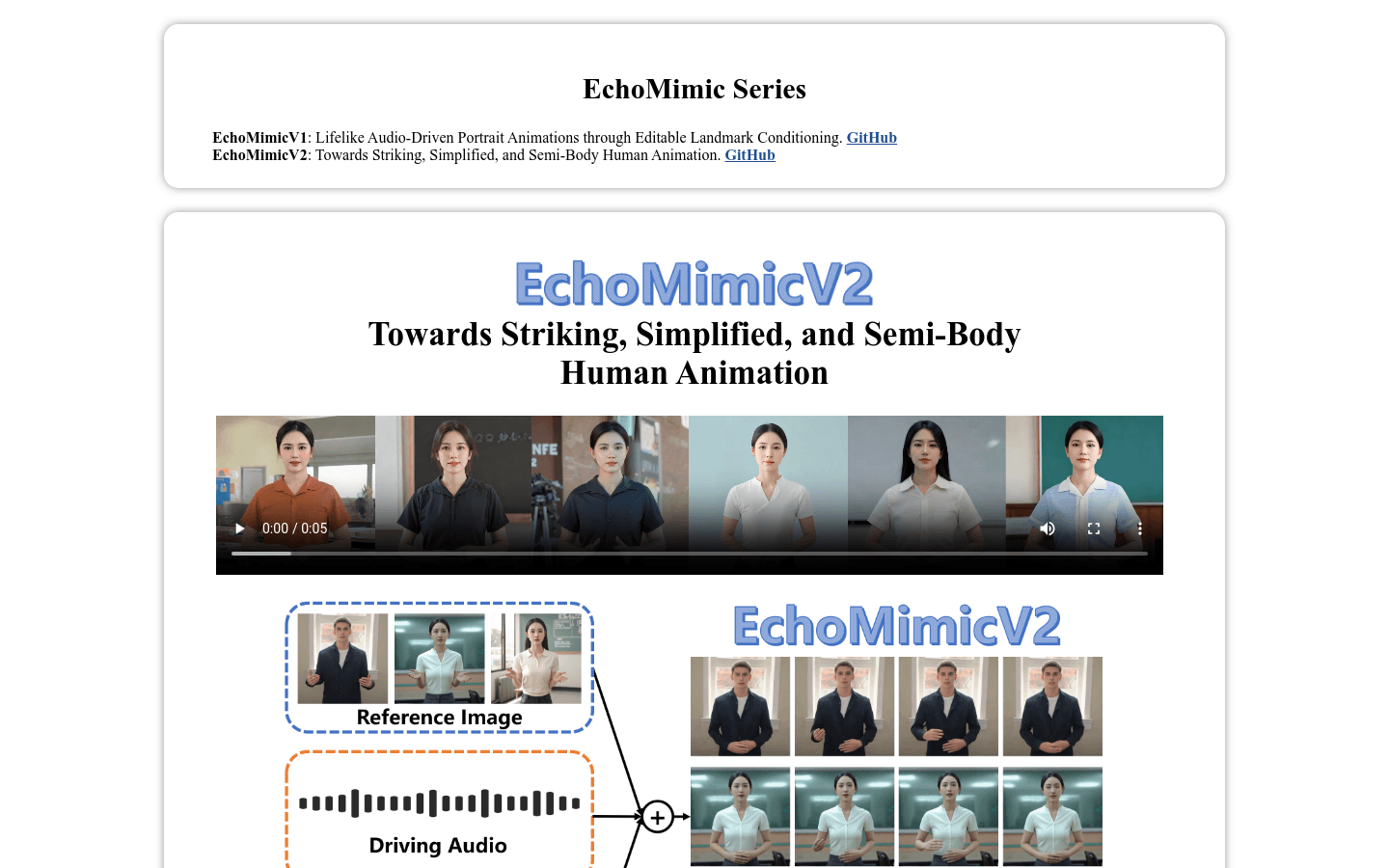

EchoMimicV2是由支付宝蚂蚁集团终端技术部研发的半身人体动画技术,它通过参考图像、音频剪辑和一系列手势来生成高质量的动画视频,确保音频内容与半身动作的连贯性。这项技术简化了以往复杂的动画制作流程,通过Audio-Pose动态协调策略,包括姿态采样和音频扩散,增强了半身细节、面部和手势的表现力,同时减少了条件冗余。此外,它还利用头部部分注意力机制将头像数据无缝整合到训练框架中,这一机制在推理过程中可以省略,为动画制作提供了便利。EchoMimicV2还设计了特定阶段的去噪损失,以指导动画在特定阶段的运动、细节和低级质量。该技术在定量和定性评估中均超越了现有方法,展现了其在半身人体动画领域的领先地位。

需求人群:

"EchoMimicV2的目标受众包括动画制作者、游戏开发者、视频内容创作者等需要生成逼真人体动画的专业人士。该技术简化了动画制作流程,提高了效率,同时保持了动画的高质量,非常适合需要快速生成动画内容的商业项目和创意项目。"

使用场景示例:

动画制作者使用EchoMimicV2为电影制作逼真的半身角色动画。

游戏开发者利用EchoMimicV2生成游戏中角色的动态表现。

视频内容创作者使用EchoMimicV2为在线课程制作教学动画。

产品特色:

利用参考图像、音频剪辑和手势序列生成高质量动画视频。

通过Audio-Pose动态协调策略增强半身细节和面部及手势表现力。

减少条件冗余,简化动画制作流程。

使用头部部分注意力机制整合头像数据,提高训练效率。

设计特定阶段的去噪损失,优化动画质量。

提供半身人体动画效果评估的新基准。

使用教程:

1. 准备参考图像、音频剪辑和手势序列。

2. 访问EchoMimicV2的GitHub页面,下载相关代码和模型。

3. 根据EchoMimicV2提供的文档,设置开发环境和依赖。

4. 将准备好的参考图像、音频剪辑和手势序列输入到EchoMimicV2模型中。

5. 运行EchoMimicV2模型,生成动画视频。

6. 检查生成的动画视频,确保音频内容与半身动作的连贯性。

7. 如有需要,调整输入条件或模型参数,优化动画效果。

8. 将生成的动画视频用于商业项目或个人创作。

浏览量:135

最新流量情况

月访问量

2040

平均访问时长

00:00:00

每次访问页数

1.04

跳出率

43.04%

流量来源

直接访问

34.31%

自然搜索

26.78%

邮件

0.06%

外链引荐

18.40%

社交媒体

18.86%

展示广告

0

截止目前所有流量趋势图

地理流量分布情况

印度

51.51%

美国

48.49%

EchoMimicV2:实现逼真、简化、半身人体动画的技术。

EchoMimicV2是由支付宝蚂蚁集团终端技术部研发的半身人体动画技术,它通过参考图像、音频剪辑和一系列手势来生成高质量的动画视频,确保音频内容与半身动作的连贯性。这项技术简化了以往复杂的动画制作流程,通过Audio-Pose动态协调策略,包括姿态采样和音频扩散,增强了半身细节、面部和手势的表现力,同时减少了条件冗余。此外,它还利用头部部分注意力机制将头像数据无缝整合到训练框架中,这一机制在推理过程中可以省略,为动画制作提供了便利。EchoMimicV2还设计了特定阶段的去噪损失,以指导动画在特定阶段的运动、细节和低级质量。该技术在定量和定性评估中均超越了现有方法,展现了其在半身人体动画领域的领先地位。

端到端音频驱动的人体动画框架

CyberHost是一个端到端音频驱动的人体动画框架,通过区域码本注意力机制,实现了手部完整性、身份一致性和自然运动的生成。该模型利用双U-Net架构作为基础结构,并通过运动帧策略进行时间延续,为音频驱动的人体动画建立了基线。CyberHost通过一系列以人为先导的训练策略,包括身体运动图、手部清晰度评分、姿势对齐的参考特征和局部增强监督,提高了合成结果的质量。CyberHost是首个能够在人体范围内实现零样本视频生成的音频驱动人体扩散模型。

AI动作捕捉工具

Movmi 是一款 AI 驱动的动作捕捉工具,通过 2D 媒体数据(图像、视频)捕捉人类身体动作,为开发人员提供高质量的人体动作捕捉解决方案。整个捕捉过程在云端完成,用户无需使用高端设备。Movmi 支持从各种摄像设备捕捉镜头,包括智能手机和专业摄像机,适用于各种生活场景,甚至支持多个人物的场景。Movmi 还提供一个全文本贴图角色库,用于各种动画项目。Movmi 的会员计划分为 Bronze、Silver 和 Gold,提供不同级别的功能和体验。用户可以在任何 3D 环境中使用输出的 FBX 文件。

AI动作捕捉和实时人体追踪

DeepMotion是一款基于人工智能的动作捕捉和人体追踪解决方案。通过任意网络浏览器,在几秒钟内从视频中生成3D动画。无需特殊装备,易于使用。它提供多种功能,包括手部追踪、多人追踪和面部追踪等。DeepMotion适用于各种场景,如游戏开发、动画制作、虚拟现实等。定价方案请访问官方网站了解更多信息。

高质量人体动作视频生成

MimicMotion是由腾讯公司和上海交通大学联合研发的高质量人体动作视频生成模型。该模型通过信心感知的姿态引导,实现了对视频生成过程的可控性,提高了视频的时序平滑性,并减少了图像失真。它采用了先进的图像到视频的扩散模型,结合了时空U-Net和PoseNet,能够根据姿势序列条件生成任意长度的高质量视频。MimicMotion在多个方面显著优于先前的方法,包括手部生成质量、对参考姿势的准确遵循等。

SyncAnimation 是一种基于 NeRF 的音频驱动实时生成说话头像和上半身动作的技术框架。

SyncAnimation 是一种创新的音频驱动技术,能够实时生成高度逼真的说话头像和上半身动作。它通过结合音频与姿态、表情的同步技术,解决了传统方法在实时性和细节表现上的不足。该技术主要面向需要高质量实时动画生成的应用场景,如虚拟主播、在线教育、远程会议等,具有重要的应用价值。目前尚未明确其价格和具体市场定位。

一个用于人体动画生成的ComfyUI节点实现

ComfyUI-Moore-AnimateAnyone是一个基于Moore-AnimateAnyone模型实现的ComfyUI自定义节点,可以通过简单的文本描述生成相应的人体动画。该节点易于安装和使用,支持多种人体姿态和动作的生成,可用于提升设计作品的质量。其输出动画细腻自然,为创作者提供了强大的工具。

3D人体动作的言语和非言语语言统一模型

这是一个由斯坦福大学研究团队开发的多模态语言模型框架,旨在统一3D人体动作中的言语和非言语语言。该模型能够理解并生成包含文本、语音和动作的多模态数据,对于创建能够自然交流的虚拟角色至关重要,广泛应用于游戏、电影和虚拟现实等领域。该模型的主要优点包括灵活性高、训练数据需求少,并且能够解锁如可编辑手势生成和从动作中预测情感等新任务。

基于扩散模型的音频驱动人像和动物图像动画技术

JoyVASA是一种基于扩散模型的音频驱动人像动画技术,它通过分离动态面部表情和静态3D面部表示来生成面部动态和头部运动。这项技术不仅能够提高视频质量和唇形同步的准确性,还能扩展到动物面部动画,支持多语言,并在训练和推理效率上有所提升。JoyVASA的主要优点包括更长视频生成能力、独立于角色身份的运动序列生成以及高质量的动画渲染。

高分辨率、长时音频驱动的人像图像动画技术

Hallo2是一种基于潜在扩散生成模型的人像图像动画技术,通过音频驱动生成高分辨率、长时的视频。它通过引入多项设计改进,扩展了Hallo的功能,包括生成长时视频、4K分辨率视频,并增加了通过文本提示增强表情控制的能力。Hallo2的主要优点包括高分辨率输出、长时间的稳定性以及通过文本提示增强的控制性,这使得它在生成丰富多样的肖像动画内容方面具有显著优势。

免费AI动作捕捉工具

Rokoko Vision是一个免费的AI动作捕捉工具,用户可以通过上传视频或使用网络摄像头进行动作捕捉,并使用动画编辑器进行编辑和调整。该工具提供高精度的动作捕捉技术,使用户能够快速创建逼真的人物动画。Rokoko Vision的定价根据用户所在地不同而有所不同。

为角色动画提供直观且价格合理的动作捕捉工具。

Rokoko是一款基于传感器的动作捕捉系统,为3D数字创作者提供高质量的身体、手指和面部动画解决方案。它具有直观易用的界面和负担得起的价格,可帮助用户轻松实现逼真的角色动画。

MoMask: 3D 人体运动生成

MoMask 是一个用于基于文本驱动的 3D 人体运动生成的模型。它采用了分层量化方案,以高保真度的细节将人体运动表示为多层离散运动令牌。MoMask 通过两个不同的双向 Transformer 网络进行生成,以从文本输入预测运动令牌。该模型在文本到运动生成任务上优于现有方法,并可以无缝应用于相关任务,如文本引导的时间修复。

高效的音频驱动 Avatar 视频生成与自适应身体动画。

OmniAvatar 是一种先进的音频驱动视频生成模型,能够生成高质量的虚拟形象动画。其重要性在于结合了音频和视觉内容,实现高效的身体动画,适用于各种应用场景。该技术利用深度学习算法,实现高保真的动画生成,支持多种输入形式,定位于影视、游戏和社交领域。该模型是开源的,促进了技术的共享与应用。

基于流匹配的音频驱动说话人像视频生成方法

FLOAT是一种音频驱动的人像视频生成方法,它基于流匹配生成模型,将生成建模从基于像素的潜在空间转移到学习到的运动潜在空间,实现了时间上一致的运动设计。该技术引入了基于变换器的向量场预测器,并具有简单而有效的逐帧条件机制。此外,FLOAT支持语音驱动的情感增强,能够自然地融入富有表现力的运动。广泛的实验表明,FLOAT在视觉质量、运动保真度和效率方面均优于现有的音频驱动说话人像方法。

基于高斯点云的可驱动3D人体模型

D3GA是一个基于高斯点云的可驱动3D人体模型。它可以从多视角的视频中学习生成逼真的3D人体模型。模型使用3D高斯点云技术实时渲染,通过关节角度和关键点来驱动模型形变。与其他方法相比,在相同的训练和测试数据下,D3GA可以生成更高质量的结果。它适用于需要实时渲染和控制3D人体的应用。

AI让动作捕捉更简单

千面视频动捕是一款利用AI技术简化动作捕捉过程的产品。它通过自动化AI算法自动识别动画关键帧,生成流畅的动画效果,无需专业设备和场地,大幅提升制作效率,降低动画制作的门槛,让每个人都能成为动画师。产品支持多种主流动画软件格式,提供7天24小时在线服务,并通过V币系统进行计费,满足不同用户的需求。

先进的人工智能视觉模型,专门分析和理解人类动作。

Sapiens视觉模型由Meta Reality Labs开发,专注于处理人类视觉任务,包括2D姿态估计、身体部位分割、深度估计和表面法线预测等。模型在超过3亿张人类图像上训练,具备高分辨率图像处理能力,并能在数据稀缺情况下表现出色。其设计简单、易于扩展,性能在增加参数后显著提升,已在多个测试中超越现有基线模型。

基于重力视角坐标恢复世界定位的人体运动

GVHMR是一种创新的人体运动恢复技术,它通过重力视角坐标系统来解决从单目视频中恢复世界定位的人体运动的问题。该技术能够减少学习图像-姿态映射的歧义,并且避免了自回归方法中连续图像的累积误差。GVHMR在野外基准测试中表现出色,不仅在准确性和速度上超越了现有的最先进技术,而且其训练过程和模型权重对公众开放,具有很高的科研和实用价值。

文本和语音驱动的人体视频生成,从单张人物输入图像生成视频。

VLOGGER是一种从单张人物输入图像生成文本和音频驱动的讲话人类视频的方法,它建立在最近生成扩散模型的成功基础上。我们的方法包括1)一个随机的人类到3D运动扩散模型,以及2)一个新颖的基于扩散的架构,通过时间和空间控制增强文本到图像模型。这种方法能够生成长度可变的高质量视频,并且通过对人类面部和身体的高级表达方式轻松可控。与以前的工作不同,我们的方法不需要为每个人训练,也不依赖于人脸检测和裁剪,生成完整的图像(而不仅仅是面部或嘴唇),并考虑到正确合成交流人类所需的广泛场景(例如可见的躯干或多样性主体身份)。

AI动画生成平台

Vmotionize是一个领先的AI动画和3D动画软件,它能够将视频、音乐、文本、图片等内容转换成令人惊叹的3D动画。该平台通过先进的AI动画和动作捕捉工具,使得高质量的3D内容和动态图形更加易于获取。Vmotionize通过创新的方式为独立创作者和全球品牌提供了一个全新的平台,让他们可以共同通过人工智能和人类想象力来实现创意、分享故事和构建虚拟世界。

快速、准确、免费的音频转文字服务

AIbase音频提取文字工具利用人工智能技术,通过机器学习模型快速生成高质量的音频文本描述,优化文本排版,提升可读性,同时完全免费使用,无需安装、下载或付款,为创意人员提供便捷的基础服务。

文本转3D动画工具,轻松生成角色动作

Cartwheel是一个创新的文本转3D动画工具,用户通过输入文字提示即可生成适用于视频、游戏、电影、广告、社交或VR项目的3D动画角色。其灵活性和易用性让用户能够轻松生成各种动作,并支持导出到任何3D程序中进行编辑。目前处于测试阶段,用户需要排队等待使用。

从长文本中合成无限可控角色动画

Story-to-Motion是一个全新的任务,它接受一个故事(顶部绿色区域)并生成与文本描述相符的动作和轨迹。该系统利用现代大型语言模型作为文本驱动的运动调度器,从长文本中提取一系列(文本、位置)对。它还开发了一个文本驱动的运动检索方案,结合了经典运动匹配和运动语义以及轨迹约束。此外,它设计了一个渐进式掩蔽变换器,以解决过渡动作中常见的问题,如不自然的姿势和滑步。该系统在轨迹跟随、时间动作组合和动作混合等三个不同子任务的评估中表现优异,胜过以往的动作合成方法。

Loopy,仅凭音频驱动肖像头像,实现逼真动态。

Loopy是一个端到端的音频驱动视频扩散模型,专门设计了跨剪辑和内部剪辑的时间模块以及音频到潜在表示模块,使模型能够利用数据中的长期运动信息来学习自然运动模式,并提高音频与肖像运动的相关性。这种方法消除了现有方法中手动指定的空间运动模板的需求,实现了在各种场景下更逼真、高质量的结果。

无标记实时动作捕捉技术

Cyanpuppets是一个专注于2D视频生成3D动作模型的AI算法团队。他们的无标记动作捕捉系统通过2个RGB摄像头完成超过208个关键点的捕捉,支持UE5和UNITY 2021版本,延迟仅为0.1秒。Cyanpuppets支持大多数骨骼标准,其技术广泛应用于游戏、电影和其他娱乐领域。

单摄像头3D动画资产转换

Move API能够将包含人体动作的视频转换为3D动画资产,支持将视频文件转换为usdz、usdc和fbx文件格式,并提供预览视频。适用于集成到生产工作流程软件、增强应用动作捕捉能力或创造全新体验。

使用扩散模型实现时域一致的人体图像动画

MagicAnimate是一款基于扩散模型的先进框架,用于人体图像动画。它能够从单张图像和动态视频生成动画视频,具有时域一致性,能够保持参考图像的特征,并显著提升动画的保真度。MagicAnimate支持使用来自各种来源的动作序列进行图像动画,包括跨身份的动画和未见过的领域,如油画和电影角色。它还与DALLE3等T2I扩散模型无缝集成,可以根据文本生成的图像赋予动态动作。MagicAnimate由新加坡国立大学Show Lab和Bytedance字节跳动共同开发。

© 2026 AIbase 备案号:闽ICP备08105208号-14