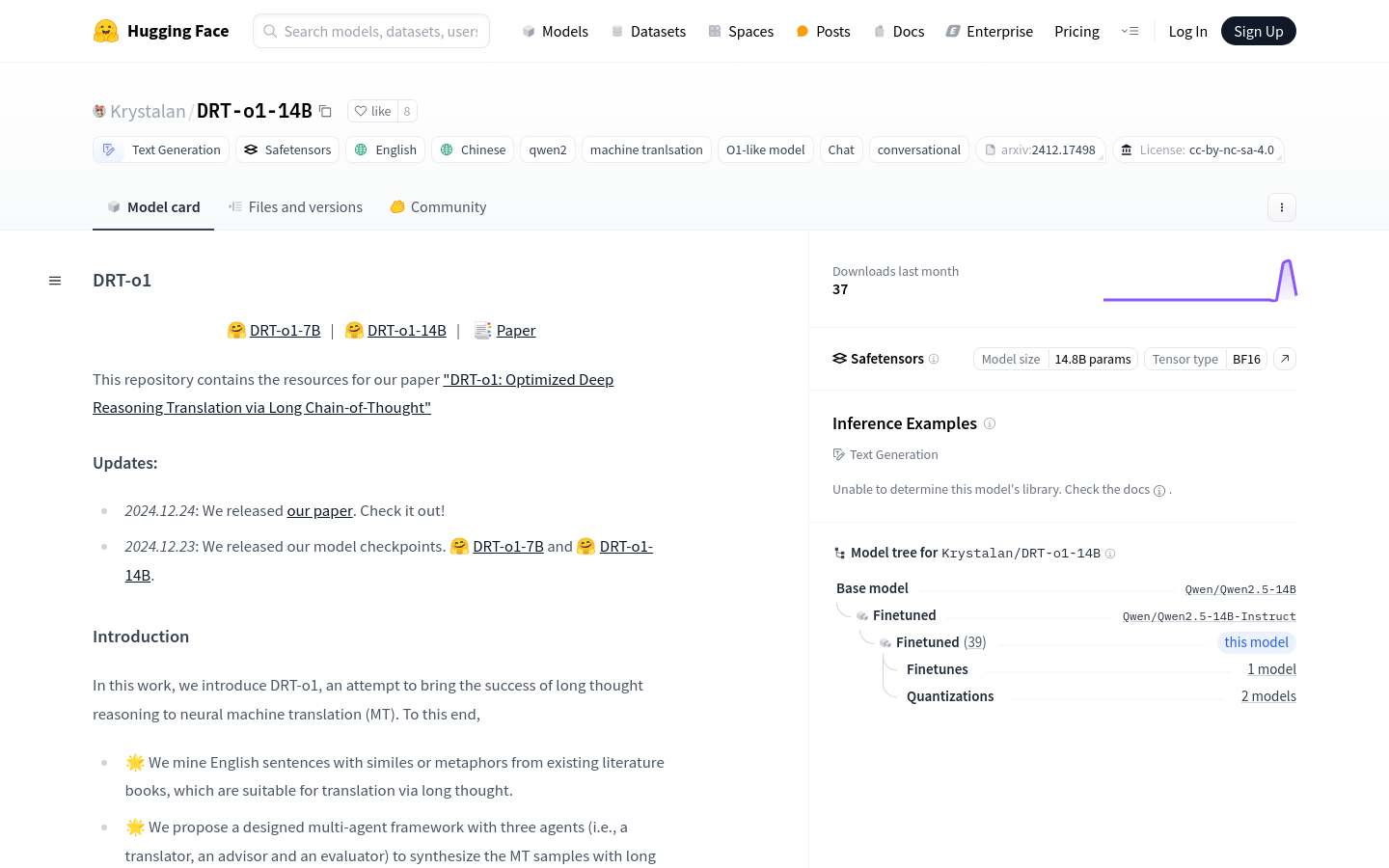

DRT-o1-14B是一个神经机器翻译模型,旨在通过长链推理来提升翻译的深度和准确性。该模型通过挖掘含有比喻或隐喻的英文句子,并采用多代理框架(包括翻译者、顾问和评估者)来合成长思考的机器翻译样本。DRT-o1-14B基于Qwen2.5-14B-Instruct作为主干进行训练,具有14.8B的参数量,支持BF16张量类型。该模型的重要性在于其能够处理复杂的翻译任务,尤其是在需要深入理解和推理的情况下,提供了一种新的解决方案。

需求人群:

"目标受众为需要进行复杂语言翻译的研究人员、开发者和企业,特别是那些需要深入理解和推理的翻译任务。DRT-o1-14B能够提供更深层次的翻译结果,帮助用户更好地理解和传达原文的深层含义。"

使用场景示例:

将含有隐喻的英文句子翻译成中文,以探索其深层含义。

在跨文化交流中,使用DRT-o1-14B来理解和翻译复杂的比喻表达。

在学术研究中,利用DRT-o1-14B来翻译专业文献,以获得更准确的学术信息。

产品特色:

支持长链推理的神经机器翻译

挖掘含有比喻或隐喻的英文句子进行翻译

多代理框架设计,包括翻译者、顾问和评估者

基于Qwen2.5-14B-Instruct主干进行训练

支持14.8B参数量的大规模模型

支持BF16张量类型,优化计算效率

适用于需要深度理解和推理的复杂翻译任务

使用教程:

1. 访问Hugging Face网站并找到DRT-o1-14B模型页面。

2. 根据页面提供的代码示例,导入必要的库和模块。

3. 设置模型名称,并从Hugging Face库中加载模型和分词器。

4. 准备翻译的英文文本,并构造系统和用户的角色消息。

5. 使用分词器将消息转换为模型输入格式。

6. 将输入传递给模型,并设置生成参数,如最大新令牌数。

7. 模型生成翻译结果后,使用分词器解码生成的令牌。

8. 输出并查看翻译结果,评估翻译的准确性和深度。

浏览量:29

最新流量情况

月访问量

25633.38k

平均访问时长

00:04:53

每次访问页数

5.77

跳出率

44.05%

流量来源

直接访问

49.07%

自然搜索

35.64%

邮件

0.03%

外链引荐

12.38%

社交媒体

2.75%

展示广告

0

截止目前所有流量趋势图

地理流量分布情况

中国

14.36%

印度

8.76%

韩国

3.61%

俄罗斯

5.25%

美国

16.65%

深度推理翻译模型,通过长思考链优化神经机器翻译。

DRT-o1是一个神经机器翻译模型,它通过长思考链的方式优化翻译过程。该模型通过挖掘含有比喻或隐喻的英文句子,并采用多代理框架(包括翻译者、顾问和评估者)来合成长思考的机器翻译样本。DRT-o1-7B和DRT-o1-14B是基于Qwen2.5-7B-Instruct和Qwen2.5-14B-Instruct训练的大型语言模型。DRT-o1的主要优点在于其能够处理复杂的语言结构和深层次的语义理解,这对于提高机器翻译的准确性和自然性至关重要。

基于深度推理的神经机器翻译模型

DRT-o1-7B是一个致力于将长思考推理成功应用于神经机器翻译(MT)的模型。该模型通过挖掘适合长思考翻译的英文句子,并提出了一个包含翻译者、顾问和评估者三个角色的多代理框架来合成MT样本。DRT-o1-7B和DRT-o1-14B使用Qwen2.5-7B-Instruct和Qwen2.5-14B-Instruct作为骨干网络进行训练。该模型的主要优点在于其能够处理复杂的语言结构和深层次的语义理解,这对于提高机器翻译的准确性和自然性至关重要。

基于深度推理的神经机器翻译模型

DRT-o1-14B是一个神经机器翻译模型,旨在通过长链推理来提升翻译的深度和准确性。该模型通过挖掘含有比喻或隐喻的英文句子,并采用多代理框架(包括翻译者、顾问和评估者)来合成长思考的机器翻译样本。DRT-o1-14B基于Qwen2.5-14B-Instruct作为主干进行训练,具有14.8B的参数量,支持BF16张量类型。该模型的重要性在于其能够处理复杂的翻译任务,尤其是在需要深入理解和推理的情况下,提供了一种新的解决方案。

为Firefox浏览器翻译功能优化的CPU加速神经机器翻译模型。

Firefox Translations Models 是由Mozilla开发的一组CPU优化的神经机器翻译模型,专为Firefox浏览器的翻译功能设计。该模型通过高效的CPU加速技术,提供快速且准确的翻译服务,支持多种语言对。其主要优点包括高性能、低延迟和对多种语言的支持。该模型是Firefox浏览器翻译功能的核心技术,为用户提供无缝的网页翻译体验。

无需编码,快速构建神经机器翻译器

Gaia是一个无需编码即可构建神经机器翻译器(NMT)的工具。它允许用户通过简单的点击操作来训练、部署和商业化自己的神经机器翻译器。该工具支持多语言,包括资源较少的语言对,并提供实时监控功能,帮助用户跟踪训练进度和性能指标。此外,Gaia还提供了易于集成的API,方便开发者将训练好的模型与自己的系统相结合。

提升机器翻译性能的对比偏好优化

Contrastive Preference Optimization是一种用于机器翻译的创新方法,通过训练模型避免生成仅仅足够而不完美的翻译,从而显著提高了ALMA模型的性能。该方法在WMT'21、WMT'22和WMT'23测试数据集上可以达到或超过WMT竞赛获胜者和GPT-4的性能。

Cradle框架:用于控制计算机的多模态代理

Cradle框架旨在使基础模型能够通过与人类相同的通用接口(屏幕作为输入,键盘和鼠标操作作为输出)执行复杂的计算机任务。该框架在Red Dead Redemption II游戏中进行了案例研究,展示了其在复杂环境中的泛化和适应能力。

基于OpenAI和Azure Cognitive Services构建的机器翻译服务

Robo Translator是一款基于人工智能的机器翻译服务,可以帮助您将内容本地化,更好地吸引全球观众。它使用最新的OpenAI模型,提供高度准确的翻译工具。无论是音频、视频还是文本文档,都可以轻松地翻译成一个或多个语言。同时,Robo Translator还支持自动翻译YouTube视频的字幕和生成多语言音频轨道,以及快速准确的音频转录和字幕生成。Robo Translator还支持软件本地化,可以处理常见的本地化格式。我们提供按使用量计费的定价模式,保证您只支付实际使用的部分。

虚拟多代理翻译公司,模拟人类翻译出版流程。

TransAgents是一个虚拟的多代理翻译公司,它模拟了人类社会中传统的翻译出版流程。该平台使用人工智能技术,通过多个代理协同工作,提供高质量的翻译服务。它尊重用户隐私,不收集任何类型的用户数据,并提醒用户该演示仅为说明目的,可能包含错误或功能问题。

Light-R1 是一个专注于长链推理(Long COT)的开源项目,通过课程式 SFT、DPO 和 RL 提供从零开始的训练方法。

Light-R1 是一个由 Qihoo360 开发的开源项目,旨在通过课程式监督微调(SFT)、直接偏好优化(DPO)和强化学习(RL)训练长链推理模型。该项目通过去污染数据集和高效的训练方法,实现了从零开始的长链推理能力。其主要优点包括开源的训练数据、低成本的训练方式以及在数学推理领域的卓越性能。项目背景基于当前长链推理模型的训练需求,旨在提供一种透明且可复现的训练方法。项目目前免费开源,适合研究机构和开发者使用。

一键生成带字幕和配音的视频翻译工具

VideoTrans是一款免费开源的视频翻译配音工具。它可以一键识别视频字幕、翻译成其他语言、进行多种语音合成,最终输出带字幕和配音的目标语言视频。该软件使用简单,支持多种翻译和配音引擎,能大幅提高视频翻译的效率。

多模态智能代理框架,解决复杂任务

OmAgent是一个复杂的多模态智能代理系统,致力于利用多模态大型语言模型和其他多模态算法来完成引人入胜的任务。该项目包括一个轻量级的智能代理框架omagent_core,精心设计以应对多模态挑战。OmAgent由三个核心组件构成:Video2RAG、DnCLoop和Rewinder Tool,分别负责长视频理解、复杂问题分解和信息回溯。

点燃语言智能,从思维链到语言代理

CoT-Igniting-Agent 是一种基于思维链推理的语言智能代理系统。它使用链式推理方法来处理自然语言理解和生成任务,并具有广泛的应用领域。该系统采用先进的算法和技术,具有高效、可靠和安全的特性。CoT-Igniting-Agent 可用于生成指令、推理、应用开发和科学研究等领域。

使用反思工作流的代理翻译模型

Translation Agent 是一个使用反思工作流的机器翻译演示项目。它由 Andrew Ng 以及合作者开发,主要利用大型语言模型(LLM)进行文本翻译,并反思翻译结果以提出改进建议。该模型的可定制性高,可以调整翻译风格、处理习语和专有名词,以及针对特定地区或方言进行优化。尽管目前该软件还不够成熟,但已经显示出与传统机器翻译系统相比有时更具竞争力的潜力。

高效长序列大型语言模型推理技术

Star-Attention是NVIDIA提出的一种新型块稀疏注意力机制,旨在提高基于Transformer的大型语言模型(LLM)在长序列上的推理效率。该技术通过两个阶段的操作显著提高了推理速度,同时保持了95-100%的准确率。它与大多数基于Transformer的LLM兼容,无需额外训练或微调即可直接使用,并且可以与其他优化方法如Flash Attention和KV缓存压缩技术结合使用,进一步提升性能。

低代码多代理系统框架

Praison AI 是一个低代码的集中式框架,旨在简化各种大型语言模型(LLM)应用的多代理系统的创建和编排。它强调易用性、可定制性和人机交互。Praison AI 利用 AutoGen 和 CrewAI 或其他代理框架,通过预定义的角色和任务来实现复杂的自动化任务。用户可以通过命令行界面或用户界面与代理进行交互,创建自定义工具,并通过多种方式扩展其功能。

使用Groq或OpenAI或Ollama创建o1类推理链

o1是一个实验性的项目,旨在通过使用大型语言模型(LLM)来创建推理链,帮助模型解决通常难以处理的逻辑问题。它支持Groq、OpenAI和Ollama后端,通过动态推理链让模型能够“思考”并解决问题。o1展示了仅通过提示就能显著提高现有模型的逻辑推理能力,而无需额外训练。

创新的多模态链式思维框架,提升视觉推理能力

Cantor是一个多模态链式思维(CoT)框架,它通过感知决策架构,将视觉上下文获取与逻辑推理相结合,解决复杂的视觉推理任务。Cantor首先作为一个决策生成器,整合视觉输入来分析图像和问题,确保与实际情境更紧密的对齐。此外,Cantor利用大型语言模型(MLLMs)的高级认知功能,作为多面专家,推导出更高层次的信息,增强CoT生成过程。Cantor在两个复杂的视觉推理数据集上进行了广泛的实验,证明了所提出框架的有效性,无需微调或真实理由,就显著提高了多模态CoT性能。

AI驱动的任务管道和多代理团队框架

Orchestra是一个用于创建AI驱动的任务管道和多代理团队的框架。它允许开发者和企业构建复杂的工作流程,通过集成不同的AI模型和工具来自动化任务处理。Orchestra的背景信息显示,它由Mainframe开发,旨在提供一个强大的平台,以支持AI技术的集成和应用。产品的主要优点包括其灵活性和可扩展性,能够适应不同的业务需求和场景。目前,Orchestra提供免费试用,具体的价格和定位信息需要进一步查询。

人形机器人多功能神经全身控制器

HOVER是一个针对人形机器人的多功能神经全身控制器,它通过模仿全身运动来提供通用的运动技能,学习多种全身控制模式。HOVER通过多模式策略蒸馏框架将不同的控制模式整合到一个统一的策略中,实现了在不同控制模式之间的无缝切换,同时保留了每种模式的独特优势。这种控制器提高了人形机器人在多种模式下的控制效率和灵活性,为未来的机器人应用提供了一个健壮且可扩展的解决方案。

AI翻译助手

slAItor是一款AI翻译助手,通过人工智能的技术进步,提供了超越传统翻译系统的功能。slAItor支持逐步翻译、改变翻译风格、提供翻译替代方案、解释翻译并纠正翻译错误。它还有一个样式校准器,可以让你根据不同的上下文适应翻译。slAItor支持28种语言对。

AI视频翻译工具

Translate.video是一款AI视频翻译工具,它可以帮助用户自动将视频的语音和字幕翻译成多种语言。该工具使用先进的语音识别和机器翻译技术,能够高效准确地翻译视频内容。用户只需上传视频或输入视频链接,选择目标语言,即可快速获得翻译后的视频。Translate.video还支持字幕的自动生成和编辑,方便用户进行细节调整和校对。该工具定价灵活,提供不同的套餐和付费模式,满足用户的不同需求。

智能手机应用的多模态代理框架

AppAgent是一个基于LLM(大型语言模型)的多模态代理框架,设计用于操作智能手机应用。通过简化的动作空间(如点击和滑动),模仿人类般的互动方式,实现应用操作,无需系统后端访问。代理通过自主探索或观察人类演示学习新应用的使用方法,创建知识库用于执行不同应用中的复杂任务。

构建多智能体系统的JavaScript框架

KaibanJS是一个专为JavaScript开发者设计的框架,用于构建和协调AI智能体。它允许开发者以类似微服务的方式处理AI任务,每个智能体负责不同的任务,如数据处理、处理和输出生成,全部自动协同工作。KaibanJS强调易用性和原生JavaScript支持,使得JavaScript开发者也能享受到构建复杂AI系统的能力。

一个轻量级、灵活的代理框架,能够处理各种负载任务。

Bambo是一个新型的代理框架,与主流框架相比,它更加轻量级和灵活,能够处理各种负载任务。这个框架的主要优点是它的灵活性和轻量级特性,使得它可以在多种不同的场景下使用,特别是在需要处理大量数据和请求时。Bambo框架的背景信息显示,它是为了满足现代软件开发中对于高效率和高性能的需求而设计的。目前,该框架是开源的,可以免费使用。

AI代理和多代理系统的无限画布

Canvas by MindPal是一个为现代专业人士提供AI解决方案的平台,旨在提高工作效率。它突破了线性聊天的限制,提供了一个无限的画布,让用户可以同时运行多个AI代理和多代理系统。这个平台允许用户以更符合人类思维的方式与AI互动,通过并行或顺序运行AI代理来实现复杂的工作流程。产品背景信息显示,MindPal致力于通过AI技术帮助用户打破线性限制,重新想象AI的可能性。价格方面,目前有黑五促销活动,所有年度计划享受60%的折扣。

HuggingFace的全新AI代理框架,助力开发者轻松创建强大AI代理。

Smolagents是Hugging Face团队开发的极简AI代理框架,旨在让开发者仅用少量代码就能部署强大的代理。它专注于代码代理,即代理通过编写和执行Python代码片段来执行任务,而非生成JSON或文本块。这种模式利用了大型语言模型(LLMs)生成和理解代码的能力,提供了更好的组合性、灵活性以及丰富的训练数据利用,能高效处理复杂逻辑和对象管理。Smolagents与Hugging Face Hub深度集成,便于工具的分享和加载,促进社区协作。此外,它还支持传统工具调用代理,兼容多种LLMs,包括Hugging Face Hub上的模型以及OpenAI、Anthropic等通过LiteLLM集成的模型。Smolagents的出现,降低了AI代理开发的门槛,使开发者能够更便捷地构建和部署AI驱动的应用程序。

© 2026 AIbase 备案号:闽ICP备08105208号-14