浏览量:62

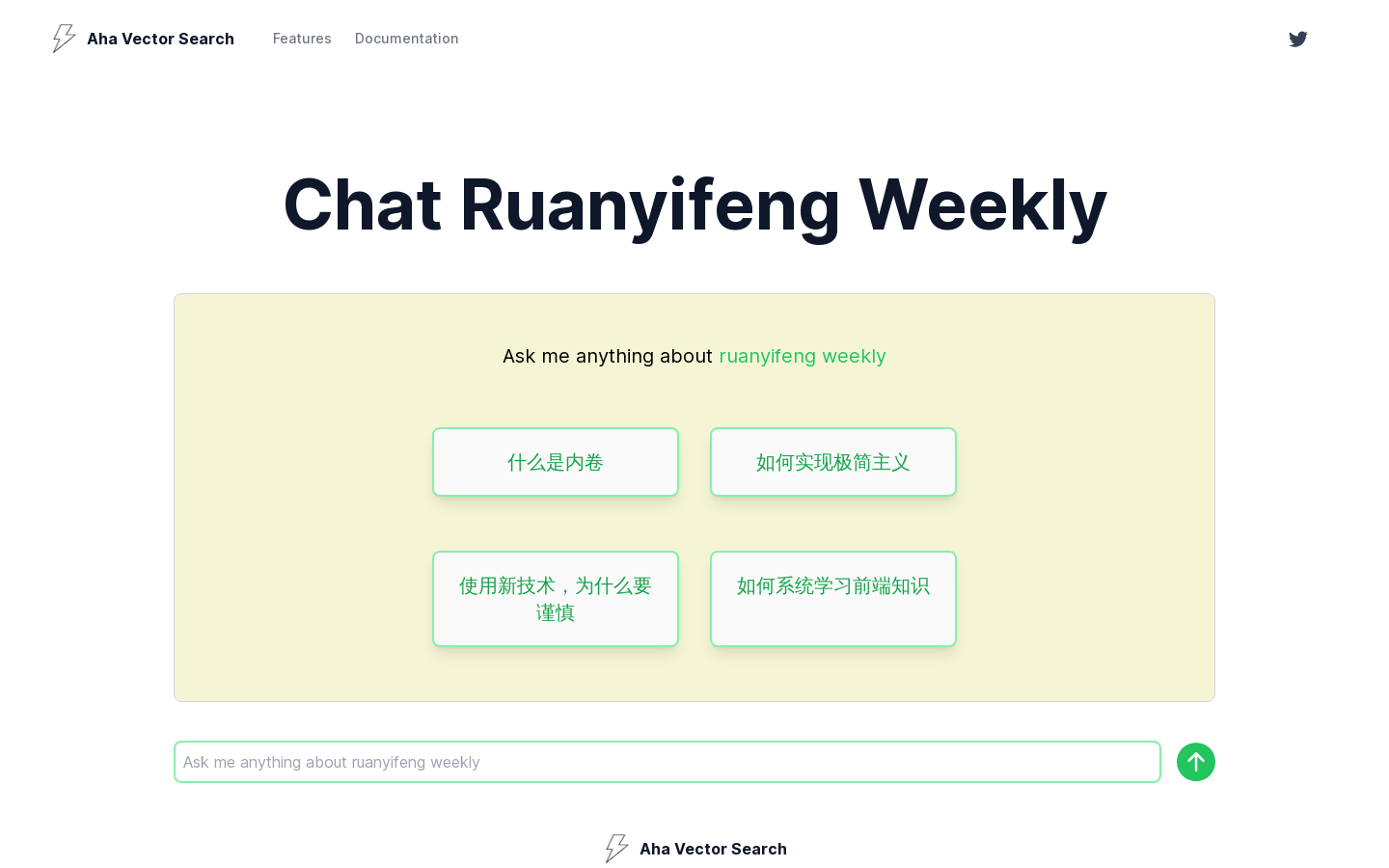

高性能、低成本的端到端chat-ruanyifeng向量搜索服务

Aha Vector Search是一个高性能、低成本的端到端向量搜索服务。它提供了一种快速构建端到端向量搜索的方法,帮助用户以更低的成本实现高效的搜索体验。

智能算力即开即用,全面提升效率与竞争力。

GPU 容器服务平台提供低成本、高效能的 GPU 算力服务,专为 AI 大模型设计。该平台帮助用户快速接入强大的计算资源,提升 AI 模型训练和推理的效率。针对教育用户,平台提供超低价格和免费试用机会,使得高性能计算变得更加可及。

专注于 GPU 算力云服务,提供高效算力解决方案。

蓝耘元生代 AIDC OS 是一款专注于 GPU 算力云服务的产品,旨在为企业和开发者提供强大的计算能力和灵活的资源配置。该产品支持多种 GPU 型号,按需计费,适用于深度学习、图形渲染等领域。其主要优点在于高性能的计算资源、可扩展的存储解决方案以及合规的云服务环境,满足不同规模企业的需求。价格为每小时 1.50 元到 1.60 元不等,依据所选 GPU 型号而定。

高性能AI应用的向量数据库

Pinecone是一个全面管理、开发人员友好且可轻松扩展的向量数据库,可通过API调用以毫秒级时间搜索数十亿个项目的相似匹配。它是下一代搜索技术,只需一个API调用即可使用。

秒级计费的弹性GPU租用服务

AutoDL为您提供专业的GPU租用服务,秒级计费、稳定好用,高规格机房,7×24小时服务。您可以弹性部署AI模型,实现震撼上线,同时提供算法复现社区,一键复现经典算法。

AI云端一体化解决方案,提供模型API、Serverless和GPU租赁服务。

派欧算力云是一个一站式AIGC云服务平台,提供高性价比的GPU基础设施和无缝集成的最前沿AI推理技术。它全面覆盖不同业务阶段的AI需求,加速业务发展。派欧算力云的主要优点包括:高性能的云服务产品、无需管理和运维GPU基础设施、自动弹性扩缩容、全球覆盖的GPU容器实例、7X24小时客户服务。产品背景信息显示,派欧算力云旨在为AI应用开发者提供强大的算力支持,降低开发成本,提高开发效率。

利用向量搜索技术,实现基于描述搜索相关股票的工具。

概念股搜索器是一款基于自然语言处理和向量搜索技术的在线工具,它能够对用户输入的任意描述进行语义匹配,快速找到与之相关的中国A股上市公司股票。该产品的主要优点在于其创新的搜索方式,能够处理意象、概念、关键词等多种形式的输入,为用户提供一种全新的股票搜索体验。产品背景信息显示,它旨在帮助用户在投资决策时,能够快速获取相关信息,但请注意,搜索结果仅供参考,不构成投资建议。

高性能、成本效益高、气候对齐的云平台

Crusoe提供可扩展的、气候对齐的数字基础设施,专为高性能计算和人工智能优化。我们的创新方法通过使用浪费的、孤立的或清洁能源来减少温室气体排放,支持能源转型,并最大化资源效率。

共享闲置显卡算力赚钱

算了么是一个利用用户闲置GPU算力进行科学研究和获得收益的平台。用户可以通过共享他们的闲置显卡资源,支持科研计算任务,如疾病研究和环境保护,同时获得相应的经济回报。该平台不仅促进了科技进步,还实现了资源的高效利用,为个人和科研机构提供了双赢的解决方案。

SemaDB是一款基于Firebase的向量搜索工具

SemaDB是一款基于Firebase的向量搜索工具,可以帮助用户快速进行向量搜索。它具有高效、准确的搜索能力,可以广泛应用于各个领域。SemaDB的定价根据使用情况而定,详情请访问官方网站。

开源向量搜索引擎,提供快速可扩展的向量相似性搜索服务。

Qdrant是一个开源的向量搜索数据库和向量搜索引擎,使用Rust语言编写。它提供了快速可扩展的向量相似性搜索服务,并具有方便的API。Qdrant可以与任何东西集成,是下一代AI应用中先进和高性能向量相似性搜索技术的基础。它是一个云原生的向量数据库,可以水平扩展,利用资源高效,完全使用Rust语言开发。Qdrant可以解决推荐系统、语义搜索、相似产品发现、反欺诈系统、人才匹配等业务场景。

为开发者提供资源工具、应用实践、商业变现、学习交流、大赛活动等一站式服务

华为云开发者官网旨在为开发者提供开发资源、开发工具、开发者计划、开发者社区、技术交流、商业支持等一站式服务,助力开发者快速掌握云原生技术,实现创新应用落地。平台集成了软件开发工具、AI开发工具、API文档、SDK等,帮助开发者高效开发;还提供沃土计划、开发者认证等项目帮助开发者成长。开发者可以在社区交流技术,参加云上技术分享活动;开发者计划助力开发者商业化,平台提供应用商店帮助开发者实现应用变现。

提供稳定高效的 AI 算力及 GPU 租赁服务。

晨涧云是晨涧科技旗下的 AI 算力平台,专注于提供高效、稳定的 AI 算力资源和 GPU 租赁服务,适用于深度学习、大数据分析及科学计算等多种场景。其优势在于高性价比的显卡资源,支持多种 AI 模型,助力企业高效开发 AI 应用。产品价格极具竞争力,仅为传统公有云的 1-3 折,且可通过算力变现计划实现成本效益最大化。

以低成本实现高性能的大型语言模型

JetMoE-8B是一个开源的大型语言模型,通过使用公共数据集和优化的训练方法,以低于10万美元的成本实现了超越Meta AI LLaMA2-7B的性能。该模型在推理时仅激活22亿参数,大幅降低了计算成本,同时保持了优异的性能。

首个AI互动式搜索引擎,改变搜索方式

简单搜索是一个基于人工智能的互动式搜索引擎,通过理解用户意图,提供个性化的搜索结果和推荐。简单搜索可以像聊天一样进行交互式搜索,同时拥有强大的语义理解能力,能够准确捕捉用户需求,大大提高搜索效率。

高性能混合专家语言模型

DeepSeek-V2.5-1210是DeepSeek-V2.5的升级版本,它在多个能力方面进行了改进,包括数学、编码和写作推理。模型在MATH-500基准测试中的性能从74.8%提高到82.8%,在LiveCodebench (08.01 - 12.01)基准测试中的准确率从29.2%提高到34.38%。此外,新版本优化了文件上传和网页摘要功能的用户体验。DeepSeek-V2系列(包括基础和聊天)支持商业用途。

Gemini Pro 是 Google DeepMind 推出的高性能 AI 模型,专注于复杂任务处理和编程性能。

Gemini Pro 是 Google DeepMind 推出的最先进 AI 模型之一,专为复杂任务和编程场景设计。它在代码生成、复杂指令理解和多模态交互方面表现出色,支持文本、图像、视频和音频输入。Gemini Pro 提供强大的工具调用能力,如 Google 搜索和代码执行,能够处理长达 200 万字的上下文信息,适合需要高性能 AI 支持的专业用户和开发者。

高性能AI加速器,专为AI工作负载设计。

Intel® Gaudi® 3 AI Accelerator是英特尔推出的一款高性能人工智能加速器,它基于高效的英特尔® Gaudi® 平台构建,具备出色的MLPerf基准性能,旨在处理要求苛刻的训练和推理任务。该加速器支持数据中心或云中的大型语言模型、多模态模型和企业RAG等人工智能应用程序,能够在您可能已经拥有的以太网基础设施上运行。无论您需要单个加速器还是数千个加速器,英特尔Gaudi 3都可以在您的AI成功中发挥关键作用。

高性能AI模型加载器,大幅减少冷启动时间。

Mystic Turbo Registry是一款由Mystic.ai开发的高性能AI模型加载器,采用Rust语言编写,专门针对减少AI模型的冷启动时间进行了优化。它通过提高容器加载效率,显著减少了模型从启动到运行所需的时间,为用户提供了更快的模型响应速度和更高的运行效率。

高性能云服务器,轻松构建网站

云服务器提供高性能的网站托管服务,具备灵活的配置选项和可靠的稳定性。优势包括强大的计算能力、高速的网络连接、可扩展的存储空间和灵活的安全性配置。价格根据配置选项和使用时长而定,适合个人用户和中小型企业使用。定位为提供可靠稳定的网站托管解决方案。

嵌入编辑器,优化向量搜索

Embedditor是一款开源的嵌入编辑器,类似于MS Word,能够帮助您充分利用向量搜索。通过用户友好的界面,改进您的嵌入元数据和嵌入标记。无缝应用高级NLP清洗技术,如TF-IDF,规范化和丰富您的嵌入标记,提高LLM相关应用的效率和准确性。优化您从向量数据库获取的内容的相关性,智能拆分或合并内容,基于其结构添加空白或隐藏标记,使块更具语义一致性。您可以完全控制您的数据,轻松在个人计算机上或专用企业云或本地环境中部署Embedditor,提高数据安全性。通过应用Embedditor的高级清洗技术,过滤掉嵌入中的无关标记,如停用词、标点符号和低相关性的常用词,您可以节省多达40%的嵌入和向量存储成本,同时获得更好的搜索结果。

FlashInfer是一个用于大型语言模型服务的高性能GPU内核库。

FlashInfer是一个专为大型语言模型(LLM)服务而设计的高性能GPU内核库。它通过提供高效的稀疏/密集注意力机制、负载平衡调度、内存效率优化等功能,显著提升了LLM在推理和部署时的性能。FlashInfer支持PyTorch、TVM和C++ API,易于集成到现有项目中。其主要优点包括高效的内核实现、灵活的自定义能力和广泛的兼容性。FlashInfer的开发背景是为了满足日益增长的LLM应用需求,提供更高效、更可靠的推理支持。

高性能、成本效益的向量数据库,为GenAI应用打造。

Zilliz Cloud Serverless是一个为GenAI应用设计的高性能向量数据库服务,它提供了自动扩展的数据库能力,成本随着业务增长而增加。该产品使用分层存储系统,结合DRAM、SSD和对象存储自动优化数据放置,确保活跃数据快速访问的同时降低不常用信息的成本,无需手动管理。Zilliz Cloud Serverless以其成本效益、数据可移植性和自动扩展能力,为需要处理大规模向量数据的企业提供了一个强大的解决方案。

昆仑万维开源的高性能数学代码推理模型,性能卓越

Skywork-OR1是由昆仑万维天工团队开发的高性能数学代码推理模型。该模型系列在同等参数规模下实现了业界领先的推理性能,突破了大模型在逻辑理解与复杂任务求解方面的能力瓶颈。Skywork-OR1系列包括Skywork-OR1-Math-7B、Skywork-OR1-7B-Preview和Skywork-OR1-32B-Preview三款模型,分别聚焦数学推理、通用推理和高性能推理任务。此次开源不仅涵盖模型权重,还全面开放了训练数据集和完整训练代码,所有资源均已上传至GitHub和Huggingface平台,为AI社区提供了完全可复现的实践参考。这种全方位的开源策略有助于推动整个AI社区在推理能力研究上的共同进步。

146亿参数的高性能MoE模型

Skywork-MoE是一个具有146亿参数的高性能混合专家(MoE)模型,拥有16个专家和22亿激活参数。该模型从Skywork-13B模型的密集型检查点初始化而来。引入了两种创新技术:门控逻辑归一化,增强专家多样化;自适应辅助损失系数,允许层特定的辅助损失系数调整。Skywork-MoE在各种流行基准测试中,如C-Eval、MMLU、CMMLU、GSM8K、MATH和HumanEval,展现出与参数更多或激活参数更多的模型相当的或更优越的性能。

引领RISC-V革命,提供高性能计算密度

SiFive是RISC-V架构的领导者,提供高性能、高效率的计算解决方案,适用于汽车、AI、数据中心等应用。其产品以优越的性能和效率,以及全球社区的支持,推动了RISC-V技术的发展和应用。

开源的高性能语言模型,支持多端应用。

Qwen2.5系列语言模型是一系列开源的decoder-only稠密模型,参数规模从0.5B到72B不等,旨在满足不同产品对模型规模的需求。这些模型在自然语言理解、代码生成、数学推理等多个领域表现出色,特别适合需要高性能语言处理能力的应用场景。Qwen2.5系列模型的发布,标志着在大型语言模型领域的一次重要进步,为开发者和研究者提供了强大的工具。

跨平台AI性能基准测试工具

Geekbench AI 是一款使用真实世界机器学习任务来评估AI工作负载性能的跨平台AI基准测试工具。它通过测量CPU、GPU和NPU的性能,帮助用户确定他们的设备是否准备好应对当今和未来的尖端机器学习应用。

© 2026 AIbase 备案号:闽ICP备08105208号-14