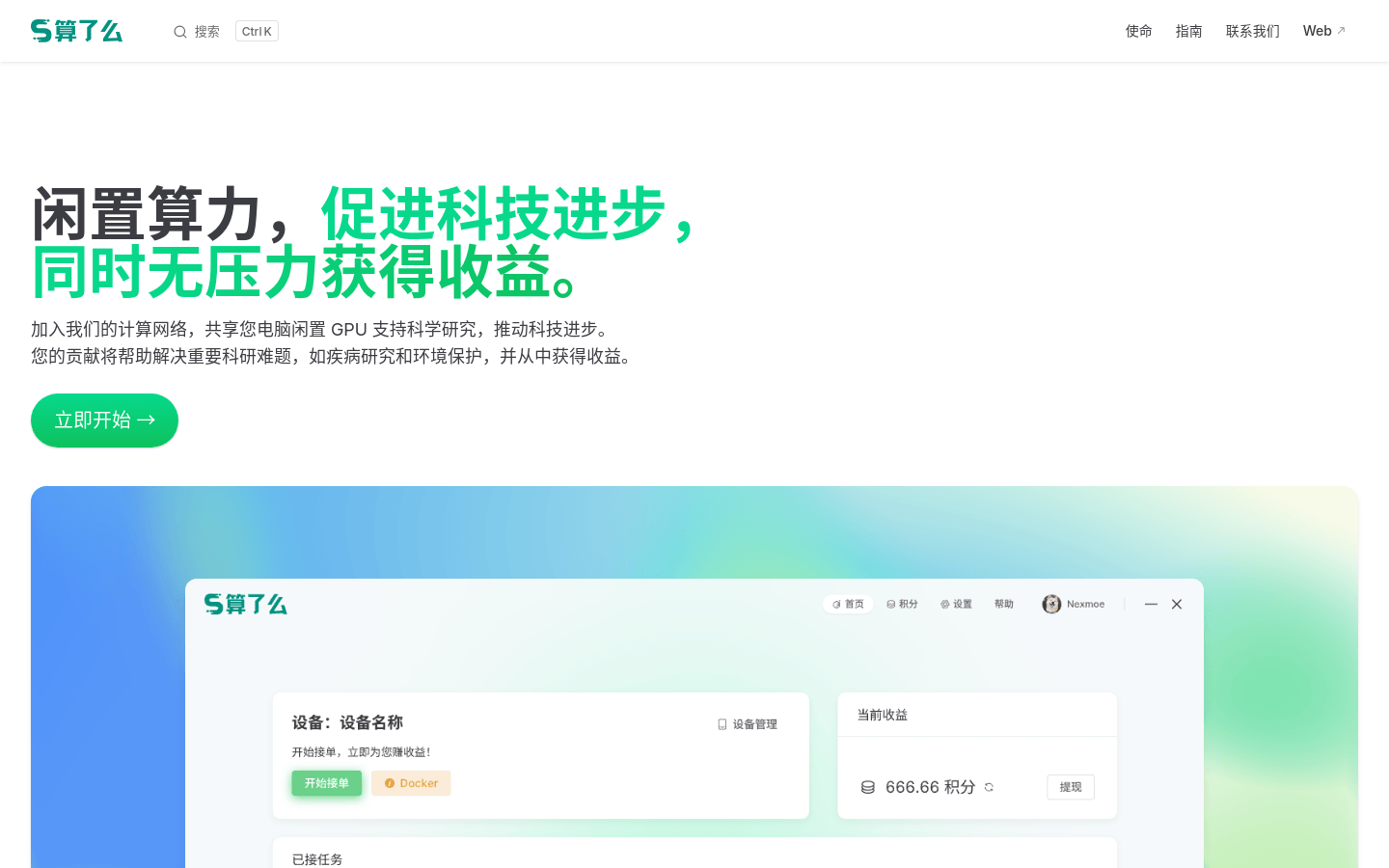

算了么是一个利用用户闲置GPU算力进行科学研究和获得收益的平台。用户可以通过共享他们的闲置显卡资源,支持科研计算任务,如疾病研究和环境保护,同时获得相应的经济回报。该平台不仅促进了科技进步,还实现了资源的高效利用,为个人和科研机构提供了双赢的解决方案。

需求人群:

"目标受众为拥有闲置GPU资源的用户,特别是那些希望在不增加额外成本的情况下获得额外收入的人。此外,科研机构和需要大量计算资源的项目也能从中受益,因为它们可以通过平台获得所需的算力支持。"

使用场景示例:

清华校友使用平台资源完成紧急科研任务。

课题组利用平台算力推进疾病研究。

环保项目通过平台算力进行电离过程计算。

产品特色:

显卡闲时计算:在用户不使用电脑时自动启动计算任务。

自动赚钱:用户的贡献将转化为及时的经济收益。

多设备接入:支持多台闲置电脑接入,实现自动赚钱。

纯软件客户端:无需额外购买硬件,直接利用现有设备。

合理占用:确保显卡资源的合理利用,不影响用户正常使用。

可持续发展:通过利用闲置资源,促进了资源的可持续使用。

使用教程:

1. 访问算了么官方网站并注册账户。

2. 下载并安装平台提供的纯软件客户端。

3. 登录客户端,按照指引配置显卡资源。

4. 选择参与的计算任务,并设置计算时间。

5. 开启客户端,系统将自动在设定时间内启动计算任务。

6. 定期查看收益情况,并根据需要调整设置。

浏览量:755

最新流量情况

月访问量

8603

平均访问时长

00:05:05

每次访问页数

3.17

跳出率

55.17%

流量来源

直接访问

58.35%

自然搜索

32.26%

邮件

0.12%

外链引荐

8.03%

社交媒体

0.84%

展示广告

0

截止目前所有流量趋势图

地理流量分布情况

中国

99.95%

日本

0.05%

共享闲置显卡算力赚钱

算了么是一个利用用户闲置GPU算力进行科学研究和获得收益的平台。用户可以通过共享他们的闲置显卡资源,支持科研计算任务,如疾病研究和环境保护,同时获得相应的经济回报。该平台不仅促进了科技进步,还实现了资源的高效利用,为个人和科研机构提供了双赢的解决方案。

智能算力即开即用,全面提升效率与竞争力。

GPU 容器服务平台提供低成本、高效能的 GPU 算力服务,专为 AI 大模型设计。该平台帮助用户快速接入强大的计算资源,提升 AI 模型训练和推理的效率。针对教育用户,平台提供超低价格和免费试用机会,使得高性能计算变得更加可及。

专注于 GPU 算力云服务,提供高效算力解决方案。

蓝耘元生代 AIDC OS 是一款专注于 GPU 算力云服务的产品,旨在为企业和开发者提供强大的计算能力和灵活的资源配置。该产品支持多种 GPU 型号,按需计费,适用于深度学习、图形渲染等领域。其主要优点在于高性能的计算资源、可扩展的存储解决方案以及合规的云服务环境,满足不同规模企业的需求。价格为每小时 1.50 元到 1.60 元不等,依据所选 GPU 型号而定。

秒级计费的弹性GPU租用服务

AutoDL为您提供专业的GPU租用服务,秒级计费、稳定好用,高规格机房,7×24小时服务。您可以弹性部署AI模型,实现震撼上线,同时提供算法复现社区,一键复现经典算法。

提供稳定高效的 AI 算力及 GPU 租赁服务。

晨涧云是晨涧科技旗下的 AI 算力平台,专注于提供高效、稳定的 AI 算力资源和 GPU 租赁服务,适用于深度学习、大数据分析及科学计算等多种场景。其优势在于高性价比的显卡资源,支持多种 AI 模型,助力企业高效开发 AI 应用。产品价格极具竞争力,仅为传统公有云的 1-3 折,且可通过算力变现计划实现成本效益最大化。

AI云端一体化解决方案,提供模型API、Serverless和GPU租赁服务。

派欧算力云是一个一站式AIGC云服务平台,提供高性价比的GPU基础设施和无缝集成的最前沿AI推理技术。它全面覆盖不同业务阶段的AI需求,加速业务发展。派欧算力云的主要优点包括:高性能的云服务产品、无需管理和运维GPU基础设施、自动弹性扩缩容、全球覆盖的GPU容器实例、7X24小时客户服务。产品背景信息显示,派欧算力云旨在为AI应用开发者提供强大的算力支持,降低开发成本,提高开发效率。

专为 AI 设计的 GPU 云平台,提供高性能基础设施和全天候支持。

CoreWeave GPU 云计算是一个专为人工智能工作负载打造的云平台,提供灵活且高效的 GPU 集群,能够满足企业在大规模计算和存储方面的需求。它的主要优势包括极高的性能、可靠性和可扩展性,适合各种 AI 应用场景。通过 CoreWeave,用户能够显著降低云成本,同时提升服务响应速度,是 AI 创新的理想选择。

帮助客户发现全球公有云厂商可用的GPU实例

GPU Finder是一个帮助客户发现全球公有云厂商可用的GPU实例的平台。通过GPU Finder,用户可以快速查找各大公有云厂商提供的GPU实例,并比较它们的价格、配置和性能等信息,从而选择最适合自己需求的GPU实例。无论是进行机器学习、深度学习、图像处理还是科学计算,GPU Finder都能帮助用户快速找到合适的GPU实例。平台上提供了丰富的过滤和排序功能,让用户可以根据自己的需求进行精准的筛选,从而节省时间和成本。无论是初学者还是有经验的开发者,都可以轻松使用GPU Finder来发现和租用合适的GPU实例。

面向AI开发者的GPU云平台,高性价比,极致体验,计费灵活

GpuMall智算云是一个面向AI开发者的GPU云平台,提供高性价比的计算资源,灵活的计费方式,以及弹性的调度能力,可以满足AI开发者的各种需求。用户可以在这里快速租用GPU资源进行AI模型训练和推理,并且可以根据实际使用情况灵活调整资源配置,达到最佳性价比。平台还提供了丰富的使用文档和在线客服支持,让用户使用起来更加便捷。

图形与计算力的电流,我们的软件让虚拟远程GPU成为负担得起且易于访问的实用工具。

Juice Labs是一款开启图形与计算力的电流的软件。它将虚拟远程GPU变成了一种负担得起且易于访问的实用工具。通过Juice Labs,用户可以轻松地利用虚拟GPU进行图形计算,无论是在设计、视频编辑还是其他需要强大计算力的场景下。Juice Labs的主要功能包括提供远程GPU服务、优化图形计算效率、降低成本、提高用户的工作效率等。该产品的定价信息可在官方网站上获取。Juice Labs定位于为用户提供高效、便捷的图形与计算力解决方案。

专注人工智能领域的GPU云服务商

矩池云是一家专注于人工智能领域的GPU云服务商,提供稳定的人工智能云服务器、高速网盘等服务,支持公有云、私有云等专业级人工智能解决方案。帮助降低使用云服务门槛,提高科研教育效率。

AI创新的优化计算赋能者

LLM GPU Helper 是一个专注于人工智能领域的在线平台,提供GPU内存计算、模型推荐和大模型知识库访问等服务。它通过量身定制的建议和专家知识,帮助企业加速AI应用,深受超过3500名用户的信赖,并获得了5.0的高评分。平台的主要优点包括高准确度的GPU内存计算器、个性化的模型推荐、全面的知识库访问以及对小型企业和初创公司的特别支持。

智能生成各类学术论文的在线科研助手

橙语AI科研助手是一款基于先进语言模型的在线工具,旨在帮助用户快速生成各类学术论文。该工具采用Multimodal+Global Thought Chain语言模型,能够生成连贯、一致且逻辑性强的长文本。其主要优点包括高效生成、低重复率和广泛的学术领域覆盖。产品定位为科研人员和学生的辅助工具,帮助他们节省时间,提高论文写作效率。

为您的工作流程选择合适的云GPU供应商。

Cloud GPUs是一个网站,帮助您比较和选择适合您工作流程的云GPU供应商。该网站列出了多家云GPU提供商及其GPU型号和价格,方便您快速找到合适的GPU资源。无论您是进行机器学习训练、科学计算还是图形渲染,Cloud GPUs都能为您推荐高性能且经济实惠的云GPU解决方案。

加速科学发现,引领量子计算的未来。

Azure Quantum 是微软推出的量子计算平台,旨在通过先进的量子计算技术加速科学研究和材料科学领域的发现。它通过结合人工智能、高性能计算和量子计算,提供了一套完整的工具和资源,以帮助研究人员和开发者在量子领域取得突破。Azure Quantum 的愿景是将250年的科学进步加速到未来25年,通过量子超级计算机解决人类面临的最困难问题。

FlashInfer是一个用于大型语言模型服务的高性能GPU内核库。

FlashInfer是一个专为大型语言模型(LLM)服务而设计的高性能GPU内核库。它通过提供高效的稀疏/密集注意力机制、负载平衡调度、内存效率优化等功能,显著提升了LLM在推理和部署时的性能。FlashInfer支持PyTorch、TVM和C++ API,易于集成到现有项目中。其主要优点包括高效的内核实现、灵活的自定义能力和广泛的兼容性。FlashInfer的开发背景是为了满足日益增长的LLM应用需求,提供更高效、更可靠的推理支持。

集体知识共享的未来

Stack Overflow Labs 是 Stack Overflow 及其社区和客户共同探索知识共享的未来的新空间。Labs 提供了一个平台,让技术人员可以分享想法、意见、设计、研究和产品创意,将新兴技术与 Stack Overflow 的平台和服务相结合。通过 Labs,用户可以发现新的方法来提高技术人员的创造力和生产力。Labs 致力于给技术人员更多时间去创造出令人惊叹的事物,并提供准确的知识和透明的来源。

AI科研文献综述助手

Seaml.es是一款AI辅助工具,能够帮助科研人员快速撰写文献综述。它能够从相关文献中提取信息,创建草稿,并提供高效的编辑和校对功能。用户可以通过免费试用3个积分来体验其功能,而Pro版本则提供更多的积分和更高质量的模型。Seaml.es的优势在于提高文献综述的撰写效率,节省研究人员的时间。定价灵活,定位于科研人员和学术机构。

低成本按需GPU,为机器学习和AI任务即时启动

GPUDeploy是一个提供低成本按需GPU资源的网站,专为机器学习和人工智能任务设计,用户可以立即启动预配置的GPU实例,以支持复杂的计算任务。该产品主要优点包括低成本、即时可用性以及预配置的便利性,适合需要快速部署机器学习模型和算法的企业和个人。

Flux 是一个用于 GPU 上张量/专家并行的快速通信重叠库。

Flux 是由字节跳动开发的一个高性能通信重叠库,专为 GPU 上的张量和专家并行设计。它通过高效的内核和对 PyTorch 的兼容性,支持多种并行化策略,适用于大规模模型训练和推理。Flux 的主要优点包括高性能、易于集成和对多种 NVIDIA GPU 架构的支持。它在大规模分布式训练中表现出色,尤其是在 Mixture-of-Experts (MoE) 模型中,能够显著提高计算效率。

AI科研助手

Iris.ai是一款基于人工智能的科研助手,能够帮助研究人员进行文献综述、研究数据提取、市场监测等繁琐任务。它能够理解科学文本,提供高效的文献搜索和分析工具,并能够自动抽取关键信息。Iris.ai的智能功能使得科研工作更加高效和准确。

全球首款基于拓扑核心架构的量子芯片,为量子计算开辟新路径。

Majorana 1 是微软推出的一款革命性量子芯片,采用拓扑核心架构,利用拓扑超导体材料实现更稳定、可扩展的量子比特。该技术旨在推动量子计算从实验室走向商业化应用,解决工业级复杂问题。其主要优点包括高稳定性、低错误率和可扩展性,为未来百万量子比特的量子计算机奠定基础。

开创计算新时代的NVIDIA Blackwell平台现已发布

NVIDIA Blackwell平台使用六项变革技术推动加速计算,能够在减少成本和能耗的同时,实现实时生成AI和处理高达数万亿参数的大型语言模型。

一款免费工具,用于计算OpenAI API模型的成本。

OpenAI API 成本计算器是一个免费工具,可以用来计算不同OpenAI API模型的使用成本,包括GPT-4、GPT-3.5 Turbo、不同fine-tuning模型以及图像和音频处理模型。

科研论文探索、创作和发布的平台

SciSpace是一个帮助您更好地理解科研论文的工具。它可以用简单的语言解释和阐述大多数学术文本。通过高亮文本、数学和表格,您可以获得论文的摘要和解释。如果仍然困惑,您可以提出跟进问题来深入了解该主题。除此之外,您还可以找到与科学文章相关的摘要、未来工作和相关论文,从而更快地进行文献综述。您可以保存PDF的部分或有趣的SciSpace回答作为笔记,将所有重要信息随时掌握。

AI 助力的科研工具

Semantic Scholar 是一个免费的 AI 助力科研工具,基于 AI2 研究所开发,利用先进的人工智能和工程技术,理解科学文献的语义,帮助学者发现相关研究。该工具通过搜索和分析全球范围内的科学论文,提供独特的语义理解和相关度评估,以帮助学者快速准确地找到所需的研究资源。Semantic Scholar 还提供了 API 接口和开发者工具,支持开发者构建学术应用和科研工具。

提供高性能GPU出租服务,包括B200、H200、RTX4090、H100等型号。即时部署,价格透明。

Sesterce是一家提供GPU出租服务的网站,客户可以租用各种型号的高性能GPU来进行计算任务。该平台提供即时部署和透明的定价策略,使用户可以灵活选择适合自己需求的GPU资源。

全球最快 AI 超级计算机网络

Condor Galaxy 是一个由九台云计算、AI 超级计算机组成的全球网络,由 Cerebras Systems 和 G42 战略合作伙伴关系部署。它位于加利福尼亚州圣克拉拉,第一台 AI 超级计算机 CG-1 将 64 台 Cerebras CS-2 系统连接在一起,形成一个易于使用的 AI 超级计算机,AI 训练能力达到 4 exaFLOPs。整个 Condor Galaxy 网络将提供 36 exaFLOPs 的 AI 训练能力,是世界上最快的 AI 超级计算机网络。Condor Galaxy 的建立标志着在技术领域迎来了一个重要时刻,将释放出各行业的 AI 创新,包括医疗保健、气候研究、能源等。Condor Galaxy 网络是推动 AI 民主化的重要一步,通过简单易用的方式让用户获得最先进的 AI 计算能力,为全球数百个 AI 项目提供动力。

© 2026 AIbase 备案号:闽ICP备08105208号-14