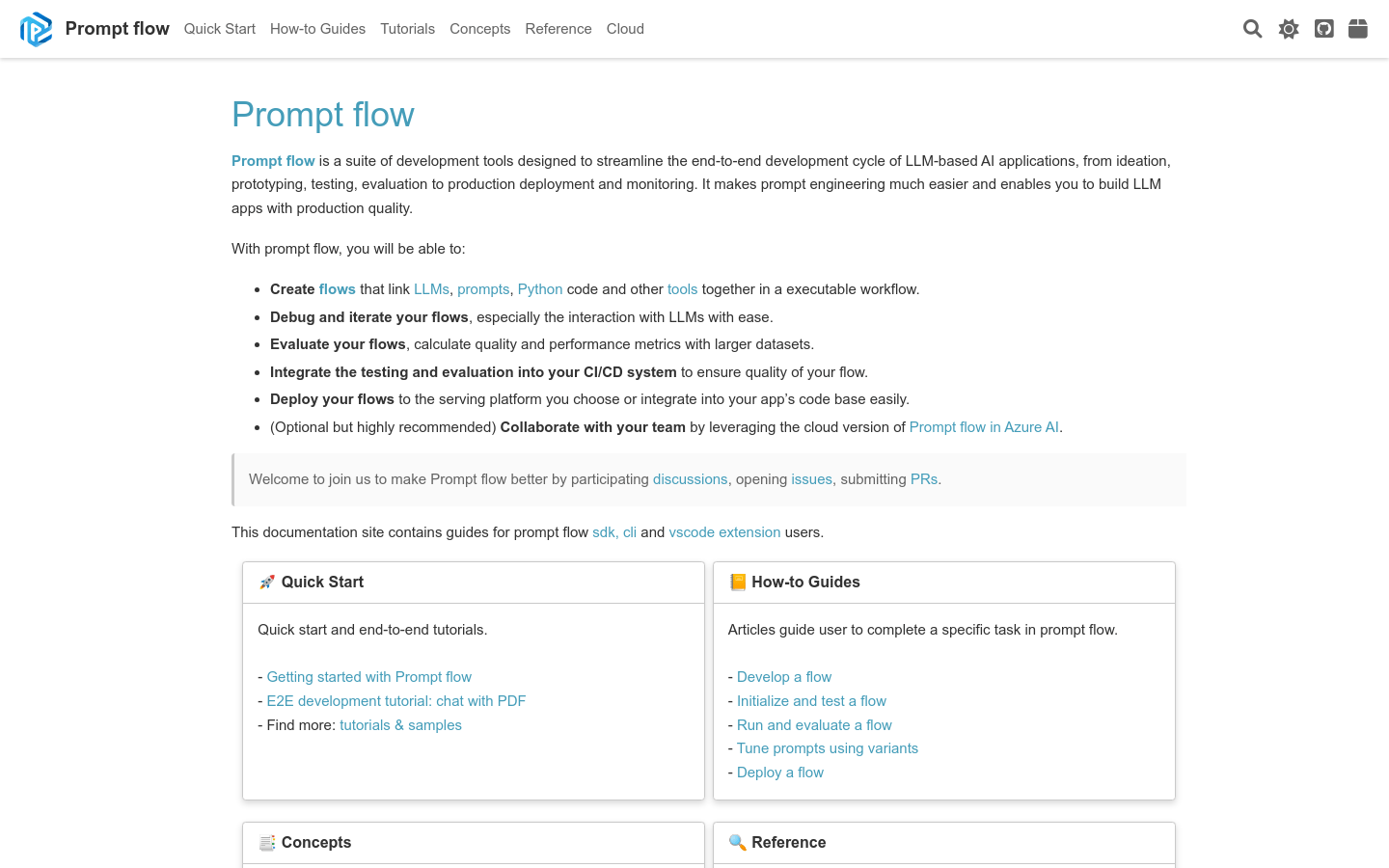

Prompt flow是一套开发工具,旨在简化基于LLM的AI应用的端到端开发流程,从构思、原型设计、测试、评估到生产部署和监控。它使得Prompt工程变得更加容易,并使您能够构建具有生产质量的LLM应用。 使用Prompt flow,您将能够: - 创建将LLM、提示、Python代码和其他工具链接在一起的可执行工作流。 - 轻松调试和迭代您的工作流,特别是与LLM的交互。 - 使用更大的数据集评估您的工作流,计算质量和性能指标。 - 将测试和评估集成到您的CI/CD系统中,以确保工作流的质量。 - 将您的工作流部署到您选择的服务平台,或轻松集成到您的应用程序代码库中。 - (可选但强烈推荐)通过在Azure AI中使用Prompt flow的云版本与团队合作。 欢迎加入我们,通过参与讨论、提出问题、提交PR来改进Prompt flow。 本文档站点包含Prompt flow SDK、CLI和VSCode扩展用户的指南。

需求人群:

"适用于基于LLM的AI应用的端到端开发流程"

使用场景示例:

使用Prompt flow创建一个聊天机器人

使用Prompt flow构建一个文本生成模型

使用Prompt flow开发一个自动摘要工具

产品特色:

创建将LLM、提示、Python代码和其他工具链接在一起的可执行工作流

轻松调试和迭代工作流,特别是与LLM的交互

使用更大的数据集评估工作流,计算质量和性能指标

将测试和评估集成到CI/CD系统中,以确保工作流的质量

将工作流部署到选择的服务平台,或轻松集成到应用程序代码库中

浏览量:45

最新流量情况

月访问量

1128.02k

平均访问时长

00:01:36

每次访问页数

2.35

跳出率

56.06%

流量来源

直接访问

43.38%

自然搜索

39.95%

邮件

0.06%

外链引荐

13.47%

社交媒体

2.52%

展示广告

0

截止目前所有流量趋势图

地理流量分布情况

中国

8.38%

德国

4.35%

印度

12.12%

美国

21.15%

端到端开发工具套件,简化基于LLM的AI应用的开发流程

Prompt flow是一套开发工具,旨在简化基于LLM的AI应用的端到端开发流程,从构思、原型设计、测试、评估到生产部署和监控。它使得Prompt工程变得更加容易,并使您能够构建具有生产质量的LLM应用。 使用Prompt flow,您将能够: - 创建将LLM、提示、Python代码和其他工具链接在一起的可执行工作流。 - 轻松调试和迭代您的工作流,特别是与LLM的交互。 - 使用更大的数据集评估您的工作流,计算质量和性能指标。 - 将测试和评估集成到您的CI/CD系统中,以确保工作流的质量。 - 将您的工作流部署到您选择的服务平台,或轻松集成到您的应用程序代码库中。 - (可选但强烈推荐)通过在Azure AI中使用Prompt flow的云版本与团队合作。 欢迎加入我们,通过参与讨论、提出问题、提交PR来改进Prompt flow。 本文档站点包含Prompt flow SDK、CLI和VSCode扩展用户的指南。

易用、灵活、高效的开源大模型应用开发框架。

Agently是一个开源的大模型应用开发框架,旨在帮助开发者快速构建基于大语言模型的AI agent原生应用。它通过提供一系列工具和接口,简化了与大型语言模型的交互过程,使得开发者可以更专注于业务逻辑的实现。Agently框架支持多种模型,易于安装和配置,具有高度的灵活性和扩展性。

AI 开发工具

GPT Pilot 是一款 AI 开发工具,能够在开发者监督下从头开始编写可扩展的应用程序。您指定要构建的应用程序类型,然后 GPT Pilot 会提出澄清问题、创建产品和技术要求、设置环境,并一步一步地编写应用程序,就像在现实生活中一样。在每个任务完成时,它会要求您进行审核,或在遇到问题时提供帮助。这样,GPT Pilot 就像一个开发者一样,而您则是一个主导开发的高级开发人员,审核代码并在需要时提供帮助。

AI 驱动的自动化端到端测试

Carbonate 是一款集成到测试框架中的 AI 驱动的自动化端到端测试工具。它将简单的语言驱动指令转化为端到端测试,并可以自动适应 UI 的变化。用户可以直接在首选的测试工具中使用简单的英语编写测试,并在首次运行时,Carbonate 会自动将测试转化为固定的测试脚本。当 HTML 发生更改时,Carbonate 会生成新的测试脚本,让测试变得更加稳定可靠。

轻量级端到端文本到语音模型

OptiSpeech是一个高效、轻量级且快速的文本到语音模型,专为设备端文本到语音转换设计。它利用了先进的深度学习技术,能够将文本转换为自然听起来的语音,适合需要在移动设备或嵌入式系统中实现语音合成的应用。OptiSpeech的开发得到了Pneuma Solutions提供的GPU资源支持,显著加速了开发进程。

实时端到端目标检测模型

YOLOv10是新一代的目标检测模型,它在保持实时性能的同时,实现了高精度的目标检测。该模型通过优化后处理和模型架构,减少了计算冗余,提高了效率和性能。YOLOv10在不同模型规模上都达到了最先进的性能和效率,例如,YOLOv10-S在相似的AP下比RT-DETR-R18快1.8倍,同时参数数量和FLOPs减少了2.8倍。

Maestro是一个简单的端到端测试工具,适用于移动应用和Web应用。

Maestro是一款端到端测试工具,为移动应用和Web应用提供简单易用的UI测试功能。其主要优点在于提供跨平台测试支持、AI辅助功能、以及友好的使用体验。Maestro的定位是为各类团队提供高效的测试解决方案。

实时端到端自动驾驶的截断扩散模型

DiffusionDrive是一个用于实时端到端自动驾驶的截断扩散模型,它通过减少扩散去噪步骤来加快计算速度,同时保持高准确性和多样性。该模型直接从人类示范中学习,无需复杂的预处理或后处理步骤,即可实现实时的自动驾驶决策。DiffusionDrive在NAVSIM基准测试中取得了88.1 PDMS的突破性成绩,并且能够在45 FPS的速度下运行。

AI辅助应用开发工具

FlutterFlow AI Gen是一款AI辅助应用开发工具,提供设计、构建和发布多语言、响应式的Flutter应用的能力。它包括AI Page Gen、AI Schema Gen、AI Theme Gen和AI Code Gen等功能,能够快速生成代码、样式、数据库结构,并提供自定义和导出功能。FlutterFlow的AI助手能够在应用开发的每个步骤中提供帮助,使应用开发变得更加简单。

端到端中英语音对话模型

GLM-4-Voice是由清华大学团队开发的端到端语音模型,能够直接理解和生成中英文语音,进行实时语音对话。它通过先进的语音识别和合成技术,实现了语音到文本再到语音的无缝转换,具备低延迟和高智商的对话能力。该模型在语音模态下的智商和合成表现力上进行了优化,适用于需要实时语音交互的场景。

全端到端的类人语音对话模型

SpeechGPT2是由复旦大学计算机科学学院开发的端到端语音对话语言模型,能够感知并表达情感,并根据上下文和人类指令以多种风格提供合适的语音响应。该模型采用超低比特率语音编解码器(750bps),模拟语义和声学信息,并通过多输入多输出语言模型(MIMO-LM)进行初始化。目前,SpeechGPT2还是一个基于轮次的对话系统,正在开发全双工实时版本,并已取得一些有希望的进展。尽管受限于计算和数据资源,SpeechGPT2在语音理解的噪声鲁棒性和语音生成的音质稳定性方面仍有不足,计划未来开源技术报告、代码和模型权重。

Pie的AI代理像真人一样测试应用,30分钟达80%端到端测试覆盖率

Pie是一款自主QA测试工具,其核心技术是使用自主AI代理来模拟真实用户对应用进行探索性测试。重要性在于能够快速、高效且全面地对应用进行测试,降低测试成本和提高测试效率。主要优点包括:无需代码、脚本和维护,可在30分钟内实现80%的端到端测试覆盖率;能够与现有软件工具链无缝集成;提供单一的就绪性分数,帮助企业明确是否发布产品;对技术栈的兼容性强,支持各种复杂的技术框架;具有高安全性,通过SOC 2 Type 2认证,不访问源代码。产品背景方面,它旨在解决传统QA测试中成本高、效率低、维护复杂等问题。价格信息未提及。其定位是为企业提供高效、安全、全面的应用测试解决方案,适用于各种规模和行业的企业。

自动化测试工具,无需编程即可生成端到端测试。

Octomind QA Agent 是一款基于人工智能的自动化测试工具,它能够自动分析网页应用并生成测试用例,执行测试并维护测试代码。这款工具的主要优点是它不需要用户具备编程知识,可以大幅降低测试的门槛,提高测试效率。它适用于希望提高软件质量、减少测试成本和时间的开发者和团队。Octomind QA Agent 提供了免费试用版本,用户可以在不提供信用卡信息的情况下尝试其功能。

开源的端到端自动驾驶多模态模型

OpenEMMA是一个开源项目,复现了Waymo的EMMA模型,提供了一个端到端框架用于自动驾驶车辆的运动规划。该模型利用预训练的视觉语言模型(VLMs)如GPT-4和LLaVA,整合文本和前视摄像头输入,实现对未来自身路径点的精确预测,并提供决策理由。OpenEMMA的目标是为研究人员和开发者提供易于获取的工具,以推进自动驾驶研究和应用。

自动化端到端测试平台

Reflect是一个自动化端到端测试平台,使测试易于创建和维护。通过Reflect,您可以创建可靠的端到端测试,无需编写一行代码。它具有AI辅助功能,能够更快速地创建测试套件,减少维护测试的工作量。同时,Reflect支持视觉测试,可以帮助您捕获其他工具无法检测到的视觉回归问题。Reflect还提供了与CI/CD解决方案的集成,让您能够在每次部署时自动执行端到端测试。Reflect的定价详细信息请访问官方网站。

AI助力软件开发工具

Codewise是一款AI助力软件开发工具,提供丰富的功能和优势。它可以自动优化代码、加速开发过程,并提供智能建议和错误检测。Codewise还支持多种编程语言和框架,适用于各种项目。定价灵活合理,适合个人开发者和团队使用。Codewise定位于提升软件开发效率和质量,让开发者更专注于创造和创新。

企业级AI驱动开发工具

CodeComplete AI是一款企业级的AI驱动开发工具,支持自托管部署,保护IP和数据安全;可直接在代码库上进行模型微调,融入自身的库和编码模式;训练数据仅来自许可证允许的代码仓库,降低法律风险;提供一整套编码工具,改善开发人员的整个工作流程。

端到端音频驱动的人体动画框架

CyberHost是一个端到端音频驱动的人体动画框架,通过区域码本注意力机制,实现了手部完整性、身份一致性和自然运动的生成。该模型利用双U-Net架构作为基础结构,并通过运动帧策略进行时间延续,为音频驱动的人体动画建立了基线。CyberHost通过一系列以人为先导的训练策略,包括身体运动图、手部清晰度评分、姿势对齐的参考特征和局部增强监督,提高了合成结果的质量。CyberHost是首个能够在人体范围内实现零样本视频生成的音频驱动人体扩散模型。

AI辅助SQL开发工具

Sqlephant是一款AI辅助SQL开发工具,具有快速生成模式推断、SQL请求修复、SQL注入修复、多语言SQL包装生成、CRUD生成、Web应用生成等功能。产品定位于提高SQL开发效率,保障代码安全。

低延迟、高质量的端到端语音交互模型

LLaMA-Omni是一个基于Llama-3.1-8B-Instruct构建的低延迟、高质量的端到端语音交互模型,旨在实现GPT-4o级别的语音能力。该模型支持低延迟的语音交互,能够同时生成文本和语音响应。它在不到3天的时间内使用仅4个GPU完成训练,展示了其高效的训练能力。

将数据和AI算法快速转化为生产就绪的Web应用

Taipy是一个开源的Python库,用于简化端到端应用开发,提供假设分析、智能管道执行、内置调度和部署工具。它允许数据科学家和机器学习工程师构建全栈应用,无需学习新的语言或全栈框架,专注于数据和AI算法,同时简化开发和部署的复杂性。

基于真实用户行为的端到端测试自动化

Checksum.ai可以将用户会话转化为完整的测试自动化流程,帮助您在不降低质量的情况下快速发布产品。它提供功能全面的端到端测试,帮助您发现和修复潜在的问题,并确保产品的稳定性和可靠性。定价根据用户需要定制。Checksum.ai定位于提供高效的测试解决方案,帮助团队快速迭代和交付产品。

快速的移动端文本到图像生成工具

MobileDiffusion是一个轻量级的潜在扩散模型,专为移动设备设计,可以在0.5秒内根据文本提示生成512x512高质量图像。相较于其他文本到图像模型,它更小巧(仅520M参数),非常适合在手机上部署使用。它的主要功能包括:1)基于文本生成图像;2)快速生成,0.5秒内完成;3)小巧的参数量,仅520M;4)生成高质量图像。主要使用场景包括内容创作、艺术创作、游戏和App开发等领域。示例使用包括:输入'盛开的玫瑰花'生成玫瑰花图片,输入'金色 retrievier 撒欢跑'生成小狗图片,输入'火星风景,外太空'生成火星图。相较于其他大模型,它更适合在移动设备上部署使用。

AI驱动的编程伴侣,将需求转化为生产就绪代码,实现端到端开发自动化。

Lagrange 是一款由 OrangeCat 开发的 AI 编程工具,能够将开发需求快速转化为可投入生产的代码。它通过先进的 AI 技术理解上下文并即时生成最优解决方案,极大地提高了开发效率。该产品支持从需求到代码生成的全流程自动化,可在短时间内生成高质量代码,适用于希望提升开发效率的开发人员和团队。目前,Lagrange 提供 Mac 和 Windows 版本的下载,用户可通过其官网获取更多信息。

即时项目规划和高速开发

pre.dev能帮助您规划、构建、交付和维护软件项目。通过与我们的产品专家讨论您的想法,我们可以迅速为您建立软件架构,并通过我们的专家工程团队快速实现项目。pre.dev支持各种应用类型,包括Web应用、移动应用等,并利用现代API、响应式前端设计和无缝数据集成。

Meta 开发的子十亿参数语言模型,适用于设备端应用。

Meta 开发的自回归语言模型,采用优化架构,适合资源受限设备。优点多,如集成多种技术,支持零样本推理等,价格免费,面向自然语言处理研究人员和开发者。

© 2026 AIbase 备案号:闽ICP备08105208号-14