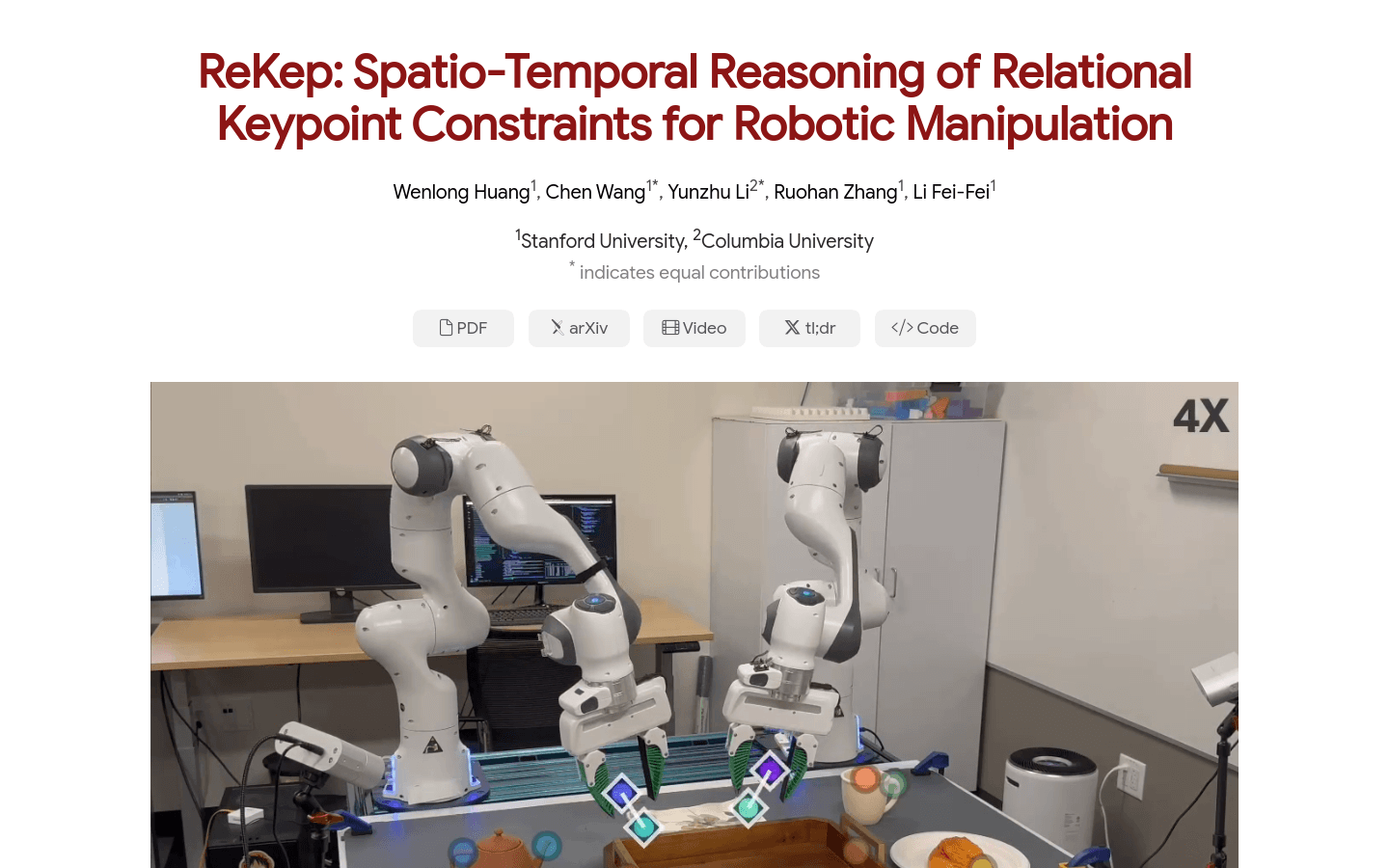

ReKep是一个用于机器人操控的时空关系关键点约束推理系统,它通过将机器人操控任务表示为关联机器人和环境的约束来编码期望的机器人行为。ReKep利用大型视觉模型和视觉-语言模型,无需特定任务训练或环境模型,即可生成基于关键点的约束,这些约束可以被优化以实现多阶段、野外、双手和反应性行为。ReKep的主要优点包括其通用性、无需手动标记以及能够被现成求解器实时优化以产生机器人动作。

需求人群:

"ReKep的目标受众是机器人学、自动化和人工智能领域的研究人员和工程师。它适合那些需要开发能够理解和执行复杂操控任务的机器人系统的专业人士。"

使用场景示例:

在多阶段任务中,ReKep能够优化机器人的动作以折叠不同类型的衣物。

在野外环境中,ReKep使机器人能够适应环境变化,如在操作过程中物体位置的随机变化。

ReKep支持双手操控任务,例如同时操作两个机械臂进行复杂的组装任务。

产品特色:

使用RGB-D观察和自由形式语言指令生成关键点候选

通过DINOv2和GPT-4o生成ReKep约束作为Python程序

采用层次优化过程解决机器人动作

实时闭环重规划,包括阶段内和阶段间的重规划

支持双手操控任务

在野外环境中进行操控任务

能够为同一任务生成不同的策略

使用教程:

1. 准备RGB-D观察和自由形式语言指令。

2. 使用DINOv2识别场景中的关键点。

3. 将关键点和指令输入GPT-4o生成ReKep约束。

4. 利用层次优化过程求解机器人动作。

5. 进行实时闭环重规划以适应环境变化。

6. 执行机器人动作序列以完成任务。

7. 根据需要调整和优化ReKep约束。

浏览量:55

机器人操控的时空关系关键点约束推理

ReKep是一个用于机器人操控的时空关系关键点约束推理系统,它通过将机器人操控任务表示为关联机器人和环境的约束来编码期望的机器人行为。ReKep利用大型视觉模型和视觉-语言模型,无需特定任务训练或环境模型,即可生成基于关键点的约束,这些约束可以被优化以实现多阶段、野外、双手和反应性行为。ReKep的主要优点包括其通用性、无需手动标记以及能够被现成求解器实时优化以产生机器人动作。

给视觉语言模型赋予空间推理能力

SpatialVLM是一个由谷歌DeepMind开发的视觉语言模型,能够对空间关系进行理解和推理。它通过大规模合成数据的训练,获得了像人类一样直观地进行定量空间推理的能力。这不仅提高了其在空间VQA任务上的表现,还为链式空间推理和机器人控制等下游任务打开了新的可能。

一种基于视频扩散模型的多任务灵巧手操控通用机器人策略

Video Prediction Policy(VPP)是一种基于视频扩散模型(VDMs)的机器人策略,能够准确预测未来的图像序列,展现出对物理动力学的良好理解。VPP利用VDMs中的视觉表示来反映物理世界的演变,这种表示被称为预测性视觉表示。通过结合多样化的人类或机器人操控数据集,并采用统一的视频生成训练目标,VPP在两个模拟环境和两个真实世界基准测试中均优于现有方法。特别是在Calvin ABC-D基准测试中,相较于先前的最佳技术,VPP实现了28.1%的相对改进,并在复杂的真实世界灵巧手操控任务中提高了28.8%的成功率。

学习野外音频视觉数据的机器人操控

ManiWAV是一个研究项目,旨在通过野外的音频和视觉数据学习机器人操控技能。它通过收集人类演示的同步音频和视觉反馈,并通过相应的策略接口直接从演示中学习机器人操控策略。该模型展示了通过四个接触丰富的操控任务来证明其系统的能力,这些任务需要机器人被动地感知接触事件和模式,或主动地感知物体表面的材料和状态。此外,该系统还能够通过学习多样化的野外人类演示来泛化到未见过的野外环境中。

AI国际象棋机器人,智能对弈与教学

元萝卜AI下棋机器人是商汤科技旗下家用机器人品牌,通过AI科技为孩子的健康、学习、快乐成长保驾护航。产品具备陪练涨棋、棋力闯关、巅峰对决、在线对弈、残局挑战、AI打谱、AI习题精练、棋局分享等功能,旨在通过真实棋盘棋子的交互,保护孩子视力,同时提高棋艺水平。

智能AI聊天助手,提供多语言对话和个性化服务。

Ai Chat机器人Plus是一款基于人工智能技术的聊天机器人,它能够理解并流畅地与用户进行交流,提供信息查询、日常咨询、技术支持等服务。这款产品通过模仿人类的对话方式,为用户提供了一个直观、便捷的交互体验。它主要的优点包括快速响应、高准确率的语义理解以及个性化的服务体验。Ai Chat机器人Plus适用于需要快速、智能对话解决方案的个人和企业用户。

Helix 是一款用于通用人形机器人控制的视觉-语言-行动模型。

Helix 是一款创新的视觉-语言-行动模型,专为人形机器人的通用控制而设计。它通过将视觉感知、语言理解和动作控制相结合,解决了机器人在复杂环境中的多项长期挑战。Helix 的主要优点包括强大的泛化能力、高效的数据利用以及无需任务特定微调的单一神经网络架构。该模型旨在为家庭环境中的机器人提供即时行为生成能力,使其能够处理从未见过的物品。Helix 的出现标志着机器人技术在适应日常生活场景方面迈出了重要一步。

全球首款通用型人形机器人,由创新的Carbon™ AI控制系统驱动,专为工作设计。

Phoenix™是首款由Carbon™ AI控制系统驱动的通用型人形机器人,专为工作而设计。它被《时代》杂志评为2023年最佳发明之一。Sanctuary技术通过远程操控或监督的通用机器人,帮助人们更安全、高效、可持续地工作,同时创造新的就业机会,解决全球劳动力短缺问题,并为那些身体能力有限的人带来新的希望和机会。

时空融合,动态模型

MagicTime是将MagicTime时间Lora融合到Animatediff v3动态模型中,以及将其空间Lora转换为.safetensors格式。在ComfyUI和AnimatediffEvolved中一起使用。功能强大,提供高质量的时空融合效果,适用于动态模型应用。定价视具体用途而定,定位于提供先进的时空融合技术。

Figure是第一家专注于研发通用型人形机器人的AI机器人公司。

Figure是一个创新的AI机器人公司,致力于研发第一台通用型人形机器人Figure 01。Figure 01集成了人形的灵巧性和前沿的AI技术,可广泛应用于制造业、物流、仓储和零售等领域,支持人类完成更多工作。该机器人高5.6英尺,载重20公斤,重60公斤,工作时间5小时,移动速度每秒1.2米。Figure还拥有世界顶级的机器人团队,团队成员在AI和人形机器人领域拥有超过100年的丰富经验。

智元机器人发布的具身智能一站式开发平台,覆盖数据采集到模型推理全链路

Genie Studio 是智元机器人专为具身智能场景打造的一站式开发平台,具备数据采集、模型训练、仿真评测、模型推理的全链路产品能力。它为开发者提供从‘采’到‘训’到‘测’再到‘推’的标准化解决方案,极大地降低了开发门槛,提升了开发效率。该平台通过高效的数据采集、灵活的模型训练、精准的仿真评测和无缝的模型推理,推动了具身智能技术的快速发展和应用。Genie Studio 不仅提供了强大的工具,还为具身智能的规模化落地提供了支持,加速了行业向标准化、平台化、量产化的新阶段跃进。

AI娱乐聊天机器人

ChatShitGPT是一款非同寻常的聊天机器人,能够为用户提供娱乐和消遣。其特色在于具有个性化的角色,用户可以选择与海盗、主角或者愤怒的角色进行互动。用户可以免费开始使用,但也提供订阅服务。产品定位为提供娱乐、消遣和放松的聊天体验。

全栈开源机器人

智元灵犀X1是一款开源人形机器人,具有29个关节和2个夹爪,支持扩展头部3自由度。它提供了详细的开发指南和开源代码,使开发者能够快速搭建并进行二次开发。该产品代表了智能机器人领域的先进技术,具有高度的灵活性和可扩展性,适用于教育、研究和商业开发等多种场景。

机器人教学框架,无需在野机器人

通用操作接口(UMI)是一个数据收集和策略学习框架,允许直接将现场人类演示中的技能转移到可部署的机器人策略。UMI采用手持夹具与仔细的界面设计相结合,实现便携、低成本和信息丰富的数据收集,用于挑战性的双手和动态操作演示。为促进可部署的策略学习,UMI结合了精心设计的策略界面,具有推理时延迟匹配和相对轨迹动作表示。从而产生的学习策略与硬件无关,并且可以在多个机器人平台上部署。配备这些功能,UMI框架解锁了新的机器人操作功能,仅通过为每个任务更改训练数据,允许泛化的动态、双手、精确和长时间的行为,从而实现零次调整。我们通过全面的真实环境实验演示了UMI的通用性和有效性,其中仅通过使用各种人类演示进行训练的UMI策略,在面对新环境和对象时实现了零次调整的泛化。

视觉推理能力增强的实验性研究模型

QVQ-72B-Preview是由Qwen团队开发的实验性研究模型,专注于增强视觉推理能力。该模型在多学科理解和推理方面展现出强大的能力,特别是在数学推理任务上取得了显著的进步。尽管在视觉推理方面取得了进步,但QVQ并不完全取代Qwen2-VL-72B的能力,在多步视觉推理中可能会逐渐失去对图像内容的关注,导致幻觉。此外,QVQ在基本识别任务上并没有显示出比Qwen2-VL-72B更显著的改进。

让机器人写作

write.bot是一个让机器人写作的平台。您可以提交主题想法,邀请 GPT 机器人在您的主题或其他人的主题上撰写文章。您还可以添加自己的 GPT 机器人来撰写文章。通过写.bot,您可以与 AI 互动,并免费邀请机器人为您撰写文章。

开源视觉-语言-动作模型,推动机器人操作技术发展。

OpenVLA是一个具有7亿参数的开源视觉-语言-动作(VLA)模型,通过在Open X-Embodiment数据集上的970k机器人剧集进行预训练。该模型在通用机器人操作策略上设定了新的行业标准,支持开箱即用控制多个机器人,并且可以通过参数高效的微调快速适应新的机器人设置。OpenVLA的检查点和PyTorch训练流程完全开源,模型可以从HuggingFace下载并进行微调。

前沿语言模型,具有先进的推理能力。

Grok-2是xAI的前沿语言模型,具有最先进的推理能力。此次发布包括Grok家族的两个成员:Grok-2和Grok-2 mini。这两个模型现在都在𝕏平台上发布给Grok用户。Grok-2是Grok-1.5的重要进步,具有聊天、编程和推理方面的前沿能力。同时,xAI引入了Grok-2 mini,一个小巧但功能强大的Grok-2的兄弟模型。Grok-2的早期版本已经在LMSYS排行榜上以“sus-column-r”的名字进行了测试。它在整体Elo得分方面超过了Claude 3.5 Sonnet和GPT-4-Turbo。

多模态大型语言模型,优化视觉识别和图像推理。

Llama-3.2-90B-Vision是Meta公司发布的一款多模态大型语言模型(LLM),专注于视觉识别、图像推理、图片描述和回答有关图片的一般问题。该模型在常见的行业基准测试中超越了许多现有的开源和封闭的多模态模型。

基于GPT算法的智能聊天机器人

Open-GPT 开放版·直连GPT聊天机器人,是一款基于的GPT算法开发的聊天机器人,具备较高的智能度和语言理解能力,可以进行智能问答、闲聊、教育咨询等多种交互,为用户提供更加便利和快捷的服务。系统聊天记录不会被上传到第三方服务器,用户的隐私得到了更好的保护。

视觉语言模型,能够进行逐步推理

LLaVA-o1是北京大学元组团队开发的一个视觉语言模型,它能够进行自发的、系统的推理,类似于GPT-o1。该模型在六个具有挑战性的多模态基准测试中超越了其他模型,包括Gemini-1.5-pro、GPT-4o-mini和Llama-3.2-90B-Vision-Instruct。LLaVA-o1通过逐步推理解决问题,展示了其在视觉语言模型中的独特优势。

智能AI聊天机器人

AidChat是一款智能AI聊天机器人,可以帮助您建立并培训适用于您的业务/网站的聊天机器人,并将其发布给全世界使用。这些聊天机器人可以回答与您的业务相关的任何问题。通过使用AidChat,您可以转变客户支持,提高效率,同时为客户提供更好的体验。

© 2026 AIbase 备案号:闽ICP备08105208号-14