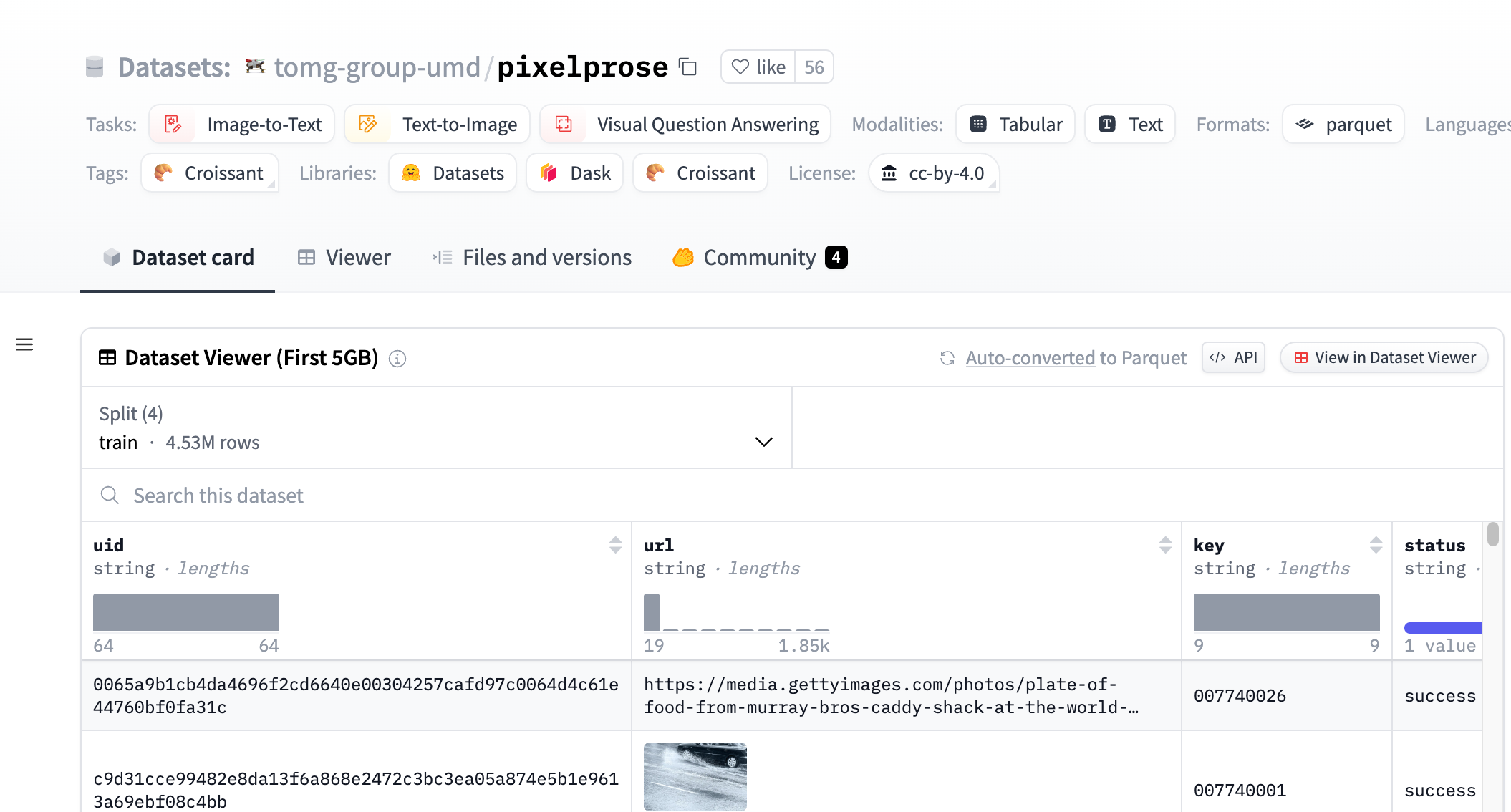

PixelProse是一个由tomg-group-umd创建的大规模数据集,它利用先进的视觉-语言模型Gemini 1.0 Pro Vision生成了超过1600万个详细的图像描述。这个数据集对于开发和改进图像到文本的转换技术具有重要意义,可以用于图像描述生成、视觉问答等任务。

需求人群:

"目标受众为机器学习和人工智能领域的研究人员和开发者,特别是那些专注于图像识别、图像描述生成和视觉问答系统的专家。该数据集的规模和多样性使其成为训练和测试这些系统的理想资源。"

使用场景示例:

研究人员使用PixelProse数据集训练一个图像描述生成模型,以自动为社交媒体上的图片生成描述。

开发者利用该数据集开发了一个视觉问答应用,能够回答用户关于图像内容的问题。

教育机构使用PixelProse作为教学资源,帮助学生了解图像识别和自然语言处理的基本原理。

产品特色:

提供超过16M的图像-文本配对。

支持多种任务,如图像到文本和文本到图像。

包含多种模态,包括表格和文本。

数据格式为parquet,易于机器学习模型处理。

包含详细的图像描述,适用于训练复杂的视觉-语言模型。

数据集分为CommonPool、CC12M和RedCaps三个部分。

提供图像的EXIF信息和SHA256哈希值,确保数据完整性。

使用教程:

第一步:访问Hugging Face网站并搜索PixelProse数据集。

第二步:选择合适的下载方式,例如通过Git LFS、Huggingface API或直接链接下载parquet文件。

第三步:使用parquet文件中的URL下载相应的图像。

第四步:根据研究或开发需要,加载数据集并进行预处理。

第五步:使用数据集训练或测试视觉-语言模型。

第六步:评估模型性能,并根据需要调整模型参数。

第七步:将训练好的模型应用于实际问题或进一步的研究中。

浏览量:76

最新流量情况

月访问量

25633.38k

平均访问时长

00:04:53

每次访问页数

5.77

跳出率

44.05%

流量来源

直接访问

49.07%

自然搜索

35.64%

邮件

0.03%

外链引荐

12.38%

社交媒体

2.75%

展示广告

0

截止目前所有流量趋势图

地理流量分布情况

中国

14.36%

印度

8.76%

韩国

3.61%

俄罗斯

5.25%

美国

16.65%

大规模图像描述数据集,提供超过16M的合成图像描述。

PixelProse是一个由tomg-group-umd创建的大规模数据集,它利用先进的视觉-语言模型Gemini 1.0 Pro Vision生成了超过1600万个详细的图像描述。这个数据集对于开发和改进图像到文本的转换技术具有重要意义,可以用于图像描述生成、视觉问答等任务。

8亿参数的多语言视觉语言模型,支持OCR、图像描述、视觉推理等功能

CohereForAI的Aya Vision 8B是一个8亿参数的多语言视觉语言模型,专为多种视觉语言任务优化,支持OCR、图像描述、视觉推理、总结、问答等功能。该模型基于C4AI Command R7B语言模型,结合SigLIP2视觉编码器,支持23种语言,具有16K上下文长度。其主要优点包括多语言支持、强大的视觉理解能力以及广泛的适用场景。该模型以开源权重形式发布,旨在推动全球研究社区的发展。根据CC-BY-NC许可协议,用户需遵守C4AI的可接受使用政策。

强大的开源视觉语言模型

CogVLM是一个强大的开源视觉语言模型。CogVLM-17B拥有100亿个视觉参数和70亿个语言参数。CogVLM-17B在10个经典的跨模态基准测试中取得了最先进的性能,包括NoCaps、Flicker30k字幕、RefCOCO、RefCOCO+、RefCOCOg、Visual7W、GQA、ScienceQA、VizWiz VQA和TDIUC,并在VQAv2、OKVQA、TextVQA、COCO字幕等方面排名第二,超过或与PaLI-X 55B相匹配。CogVLM还可以与您就图像进行对话。

Aya Vision 32B 是一个支持多语言的视觉语言模型,适用于OCR、图像描述、视觉推理等多种用途。

Aya Vision 32B 是由 Cohere For AI 开发的先进视觉语言模型,拥有 320 亿参数,支持 23 种语言,包括英语、中文、阿拉伯语等。该模型结合了最新的多语言语言模型 Aya Expanse 32B 和 SigLIP2 视觉编码器,通过多模态适配器实现视觉与语言理解的结合。它在视觉语言领域表现出色,能够处理复杂的图像与文本任务,如 OCR、图像描述、视觉推理等。该模型的发布旨在推动多模态研究的普及,其开源权重为全球研究人员提供了强大的工具。该模型遵循 CC-BY-NC 许可证,并需遵守 Cohere For AI 的合理使用政策。

高性能语言模型基准测试数据集

DCLM-baseline是一个用于语言模型基准测试的预训练数据集,包含4T个token和3B个文档。它通过精心策划的数据清洗、过滤和去重步骤,从Common Crawl数据集中提取,旨在展示数据策划在训练高效语言模型中的重要性。该数据集仅供研究使用,不适用于生产环境或特定领域的模型训练,如代码和数学。

生成计算机视觉的合成数据集

Datagen是一个可通过平台或API访问的合成图像数据集,可根据需要生成逼真的全身人像和人与物体在不同环境中互动的场景。用户可以通过代码对单个参数进行完全控制,实现人类中心数据集的设计和生成。

表情包视觉标注数据集

emo-visual-data 是一个公开的表情包视觉标注数据集,它通过使用 glm-4v 和 step-free-api 项目完成的视觉标注,收集了5329个表情包。这个数据集可以用于训练和测试多模态大模型,对于理解图像内容和文本描述之间的关系具有重要意义。

一款AI视觉语言模型,提供图像分析和描述服务。

InternVL是一个AI视觉语言模型,专注于图像分析和描述。它通过深度学习技术,能够理解和解释图像内容,为用户提供准确的图像描述和分析结果。InternVL的主要优点包括高准确性、快速响应和易于集成。该技术背景基于最新的人工智能研究,致力于提高图像识别的效率和准确性。目前,InternVL提供免费试用,具体价格和定位需要根据用户需求定制。

PaliGemma 2是一个强大的视觉-语言模型,支持多种视觉语言任务。

PaliGemma 2是一个由Google开发的视觉-语言模型,继承了Gemma 2模型的能力,能够处理图像和文本输入并生成文本输出。该模型在多种视觉语言任务上表现出色,如图像描述、视觉问答等。其主要优点包括强大的多语言支持、高效的训练架构和广泛的适用性。该模型适用于需要处理视觉和文本数据的各种应用场景,如社交媒体内容生成、智能客服等。

模型和数据集的集合

Distil-Whisper是一个提供模型和数据集的平台,用户可以在该平台上访问各种预训练模型和数据集,并进行相关的应用和研究。该平台提供了丰富的模型和数据集资源,帮助用户快速开展自然语言处理和机器学习相关工作。

一种用于生成超详细图像描述的模型,用于训练视觉语言模型。

ImageInWords (IIW) 是一个由人类参与的循环注释框架,用于策划超详细的图像描述,并生成一个新的数据集。该数据集通过评估自动化和人类并行(SxS)指标来实现最先进的结果。IIW 数据集在生成描述时,比以往的数据集和GPT-4V输出在多个维度上有了显著提升,包括可读性、全面性、特异性、幻觉和人类相似度。此外,使用IIW数据微调的模型在文本到图像生成和视觉语言推理方面表现出色,能够生成更接近原始图像的描述。

先进的视觉基础模型,支持多种视觉和视觉-语言任务

Florence-2-large是由微软开发的先进视觉基础模型,采用基于提示的方法处理广泛的视觉和视觉-语言任务。该模型能够解释简单的文本提示来执行如图像描述、目标检测和分割等任务。它利用包含54亿注释的5.4亿图像的FLD-5B数据集,精通多任务学习。其序列到序列的架构使其在零样本和微调设置中均表现出色,证明是一个有竞争力的视觉基础模型。

增强视觉语言理解的高级大型语言模型

MiniGPT-4是一个基于先进的大型语言模型的视觉语言理解模型,具有生成详细图像描述、从手写草稿生成网站等功能。它还能根据给定的图像写故事和诗歌、提供解决问题的方法、根据食物照片教用户烹饪等。MiniGPT-4通过对原始图像文本对进行预训练,并使用对话模板的对齐数据进行微调,以提高生成结果的连贯性和准确性。MiniGPT-4的定价和定位信息请参考官方网站。

PaliGemma 2是一款强大的视觉-语言模型,支持多种语言的图像和文本处理任务。

PaliGemma 2是由Google开发的视觉-语言模型,它结合了SigLIP视觉模型和Gemma 2语言模型的能力,能够处理图像和文本输入,并生成相应的文本输出。该模型在多种视觉-语言任务上表现出色,如图像描述、视觉问答等。其主要优点包括强大的多语言支持、高效的训练架构以及在多种任务上的优异性能。PaliGemma 2的开发背景是为了解决视觉和语言之间的复杂交互问题,帮助研究人员和开发者在相关领域取得突破。

AI模型数据集平台

始智AI是一家提供AI模型和数据集的平台,致力于为科研单位、企事业单位和个人提供高质量的AI模型和数据集。始智AI的优势在于提供多种类型的AI模型和数据集,包括图像、视频、自然语言处理等,用户可以根据自己的需求选择合适的模型和数据集。始智AI的定价合理,用户可以根据自己的需求选择不同的套餐,满足不同的需求。始智AI的定位是成为AI模型和数据集领域的领先平台。

AI模型库与数据集平台

I2VGen-XL是一款AI模型库与数据集平台,提供丰富的AI模型和数据集,帮助用户快速构建AI应用。平台支持多种AI任务,包括图像识别、自然语言处理、语音识别等。用户可以通过平台上传、下载和分享模型和数据集,也可以使用平台提供的API接口进行调用。平台提供免费和付费两种服务,用户可以根据需求选择适合自己的服务。

多模态大型语言模型,提升视觉与语言的交互能力。

InternVL2_5-26B-MPO是一个多模态大型语言模型(MLLM),它在InternVL2.5的基础上,通过混合偏好优化(Mixed Preference Optimization, MPO)进一步提升了模型性能。该模型能够处理包括图像、文本在内的多模态数据,广泛应用于图像描述、视觉问答等场景。它的重要性在于能够理解和生成与图像内容紧密相关的文本,推动了多模态人工智能的边界。产品背景信息包括其在多模态任务中的卓越性能,以及在OpenCompass Learderboard中的评估结果。该模型为研究者和开发者提供了强大的工具,以探索和实现多模态人工智能的潜力。

大规模实景数据集,用于深度学习三维视觉研究

DL3DV-10K是一个包含超过10000个高质量视频的大规模实景数据集,每个视频都经过人工标注场景关键点和复杂程度,并提供相机姿态、NeRF估计深度、点云和3D网格等。该数据集可用于通用NeRF研究、场景一致性跟踪、视觉语言模型等计算机视觉研究。

TOFU数据集为大型语言模型的虚构遗忘任务提供基准。

TOFU数据集包含根据不存在的200位作者虚构生成的问答对,用于评估大型语言模型在真实任务上的遗忘性能。该任务的目标是遗忘在各种遗忘集比例上经过微调的模型。该数据集采用问答格式,非常适合用于流行的聊天模型,如Llama2、Mistral或Qwen。但是,它也适用于任何其他大型语言模型。对应的代码库是针对Llama2聊天和Phi-1.5模型编写的,但可以轻松地适配到其他模型。

多模态大型语言模型,提升视觉和语言的综合理解能力

InternVL2_5-1B-MPO是一个多模态大型语言模型(MLLM),它基于InternVL2.5和混合偏好优化(MPO)构建,展示了优越的整体性能。该模型集成了新增量预训练的InternViT与各种预训练的大型语言模型(LLMs),包括InternLM 2.5和Qwen 2.5,使用随机初始化的MLP投影器。InternVL2.5-MPO在模型架构上保留了与InternVL 2.5及其前身相同的“ViT-MLP-LLM”范式,并引入了对多图像和视频数据的支持。该模型在多模态任务中表现出色,能够处理包括图像描述、视觉问答等多种视觉语言任务。

一个用于训练高性能奖励模型的开源数据集。

HelpSteer2是由NVIDIA发布的一个开源数据集,旨在支持训练能够对齐模型以使其更加有帮助、事实正确和连贯,同时在响应的复杂性和冗余度方面具有可调节性。该数据集与Scale AI合作创建,当与Llama 3 70B基础模型一起使用时,在RewardBench上达到了88.8%的表现,是截至2024年6月12日最佳的奖励模型之一。

多语言预训练数据集

FineWeb2是由Hugging Face提供的一个大规模多语言预训练数据集,覆盖超过1000种语言。该数据集经过精心设计,用于支持自然语言处理(NLP)模型的预训练和微调,特别是在多种语言上。它以其高质量、大规模和多样性而闻名,能够帮助模型学习跨语言的通用特征,提升在特定语言任务上的表现。FineWeb2在多个语言的预训练数据集中表现出色,甚至在某些情况下,比一些专门为单一语言设计的数据库表现更好。

多模态视觉语言模型

MouSi是一种多模态视觉语言模型,旨在解决当前大型视觉语言模型(VLMs)面临的挑战。它采用集成专家技术,将个体视觉编码器的能力进行协同,包括图像文本匹配、OCR、图像分割等。该模型引入融合网络来统一处理来自不同视觉专家的输出,并在图像编码器和预训练LLMs之间弥合差距。此外,MouSi还探索了不同的位置编码方案,以有效解决位置编码浪费和长度限制的问题。实验结果表明,具有多个专家的VLMs表现出比孤立的视觉编码器更出色的性能,并随着整合更多专家而获得显著的性能提升。

编码器自由的视觉-语言模型,高效且数据驱动。

EVE是一个编码器自由的视觉-语言模型,由大连理工大学、北京人工智能研究院和北京大学的研究人员共同开发。它在不同图像宽高比下展现出卓越的能力,性能超越了Fuyu-8B,并且接近模块化编码器基础的LVLMs。EVE在数据效率、训练效率方面表现突出,使用33M公开数据进行预训练,并利用665K LLaVA SFT数据为EVE-7B模型训练,以及额外的1.2M SFT数据为EVE-7B (HD)模型训练。EVE的开发采用了高效、透明、实用的策略,为跨模态的纯解码器架构开辟了新途径。

连接不同语言模型和生成视觉模型进行文本到图像生成

LaVi-Bridge是一种针对文本到图像扩散模型设计的桥接模型,能够连接各种预训练的语言模型和生成视觉模型。它通过利用LoRA和适配器,提供了一种灵活的插拔式方法,无需修改原始语言和视觉模型的权重。该模型与各种语言模型和生成视觉模型兼容,可容纳不同的结构。在这一框架内,我们证明了通过整合更高级的模块(如更先进的语言模型或生成视觉模型)可以明显提高文本对齐或图像质量等能力。该模型经过大量评估,证实了其有效性。

一款强大的小型视觉语言模型,无处不在

moondream是一个使用SigLIP、Phi-1.5和LLaVA训练数据集构建的16亿参数模型。由于使用了LLaVA数据集,权重受CC-BY-SA许可证保护。您可以在Huggingface Spaces上尝试使用它。该模型在VQAv2、GQA、VizWiz和TextVQA基准测试中表现如下:LLaVA-1.5(13.3B参数):80.0、63.3、53.6、61.3;LLaVA-1.5(7.3B参数):78.5、62.0、50.0、58.2;MC-LLaVA-3B(3B参数):64.2、49.6、24.9、38.6;LLaVA-Phi(3B参数):71.4、-、35.9、48.6;moondream1(1.6B参数):74.3、56.3、30.3、39.8。

© 2026 AIbase 备案号:闽ICP备08105208号-14