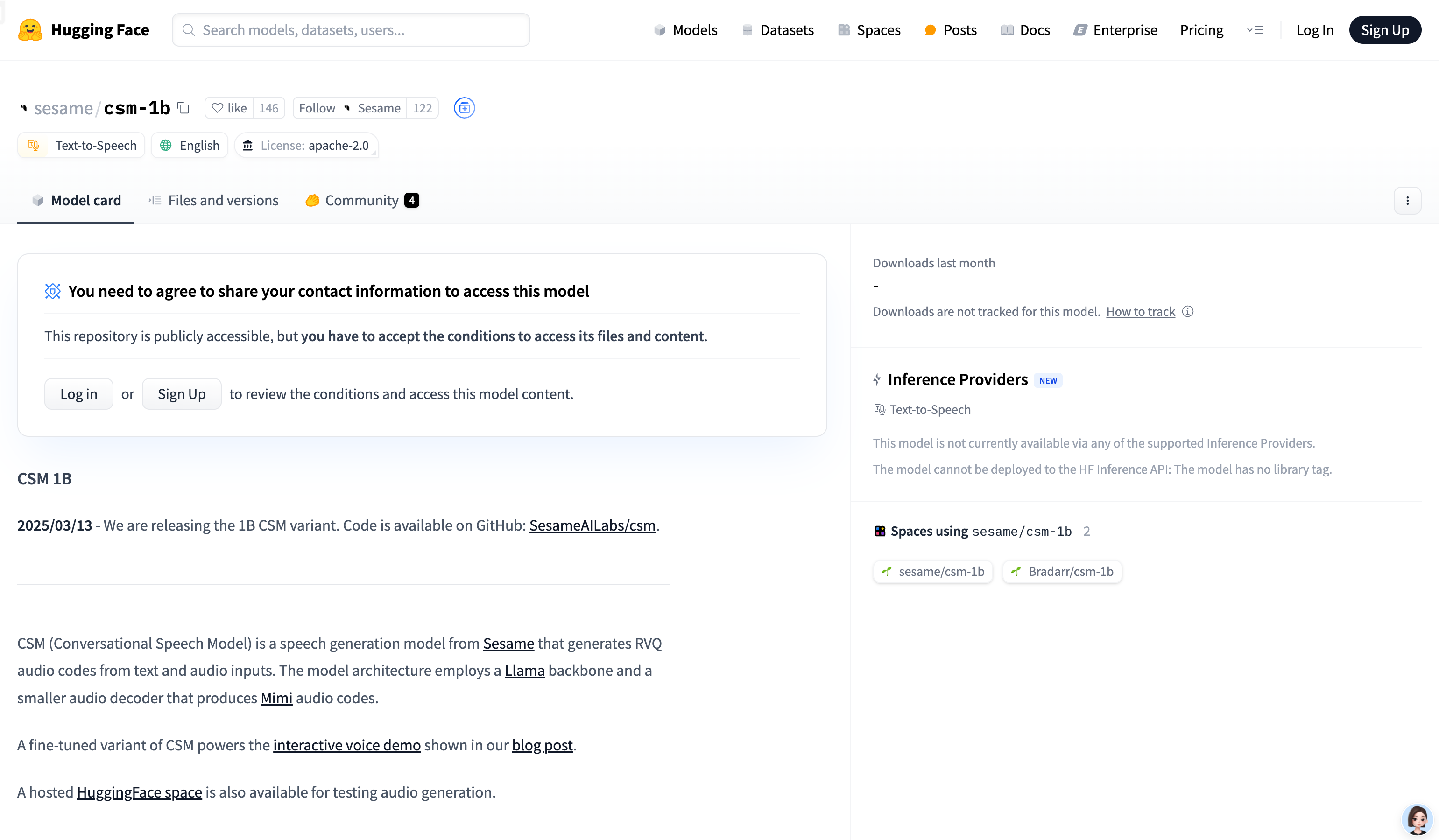

CSM 1B 是一个基于 Llama 架构的语音生成模型,能够从文本和音频输入中生成 RVQ 音频代码。该模型主要应用于语音合成领域,具有高质量的语音生成能力。其优势在于能够处理多说话人的对话场景,并通过上下文信息生成自然流畅的语音。该模型开源,旨在为研究和教育目的提供支持,但明确禁止用于冒充、欺诈或非法活动。

需求人群:

"该模型适合需要高质量语音合成的研究人员、开发者以及教育工作者。它能够为语音交互应用、语音合成研究和教育场景提供技术支持。"

使用场景示例:

在语音交互应用中,为虚拟助手生成自然语音

用于语音合成研究,探索高质量语音生成技术

在教育场景中,为语言学习生成语音示例

产品特色:

支持从文本生成高质量语音

可处理多说话人的对话场景

通过上下文信息生成更自然的语音

开源模型,便于研究和教育使用

支持多种语言(但非英语效果可能不佳)

使用教程:

1. 克隆模型仓库:`git clone git@github.com:SesameAILabs/csm.git`

2. 设置虚拟环境并安装依赖:`python3.10 -m venv .venv` 和 `pip install -r requirements.txt`

3. 下载模型文件:`hf_hub_download(repo_id="sesame/csm-1b", filename="ckpt.pt")`

4. 加载模型并生成语音:调用 `load_csm_1b` 和 `generate` 方法生成音频

5. 保存生成的音频:使用 `torchaudio.save` 保存音频文件

浏览量:230

最新流量情况

月访问量

25633.38k

平均访问时长

00:04:53

每次访问页数

5.77

跳出率

44.05%

流量来源

直接访问

49.07%

自然搜索

35.64%

邮件

0.03%

外链引荐

12.38%

社交媒体

2.75%

展示广告

0

截止目前所有流量趋势图

地理流量分布情况

中国

14.36%

印度

8.76%

韩国

3.61%

俄罗斯

5.25%

美国

16.65%

CSM 1B 是一个由 Sesame 开发的文本到语音生成模型,可生成高质量的音频。

CSM 1B 是一个基于 Llama 架构的语音生成模型,能够从文本和音频输入中生成 RVQ 音频代码。该模型主要应用于语音合成领域,具有高质量的语音生成能力。其优势在于能够处理多说话人的对话场景,并通过上下文信息生成自然流畅的语音。该模型开源,旨在为研究和教育目的提供支持,但明确禁止用于冒充、欺诈或非法活动。

将文本转换为自然流畅的语音输出

文本转语音技术是一种将文本信息转换为语音的技术,广泛应用于辅助阅读、语音助手、有声读物制作等领域。它通过模拟人类语音,提高了信息获取的便捷性,尤其对视力障碍者或在无法使用眼睛阅读的情况下非常有帮助。

使用自得语音技术,创造属于你的角色

自得语音技术可通过简单的步骤创造出属于你的角色。类似GPT,可生成与真人无异的语音片段,在情感、音色和语速等方面与真人一致。自得语音支持快速定制角色,只需要上传一段语音即可立即生成属于你的语音角色。无需下载软件,可在浏览器上完成语音生成。同时提供API接口,方便开发者集成到自己的产品中。商用用户可享受7x24小时的技术支持。

提供语音识别、语音合成等语音AI能力

依图语音开放平台为开发者提供语音识别、语音合成等语音AI能力,包括精准语音转文本、文本转语音合成、声纹识别、语音增强降噪等服务,支持不同场景下的语音交互应用开发。平台提供高效、灵活的语音AI能力接入方式,可轻松将语音技术应用于各类产品与业务场景。

高性能的文本到语音合成模型

OuteTTS-0.2-500M是基于Qwen-2.5-0.5B构建的文本到语音合成模型,它在更大的数据集上进行了训练,实现了在准确性、自然度、词汇量、声音克隆能力以及多语言支持方面的显著提升。该模型特别感谢Hugging Face提供的GPU资助,支持了模型的训练。

多语言可控文本到语音合成工具包

ToucanTTS是由德国斯图加特大学自然语言处理研究所开发的多语言且可控的文本到语音合成工具包。它使用纯Python和PyTorch构建,以保持简单、易于上手,同时尽可能强大。该工具包支持教学、训练和使用最前沿的语音合成模型,具有高度的灵活性和可定制性,适用于教育和研究领域。

轻量级端到端文本到语音模型

OptiSpeech是一个高效、轻量级且快速的文本到语音模型,专为设备端文本到语音转换设计。它利用了先进的深度学习技术,能够将文本转换为自然听起来的语音,适合需要在移动设备或嵌入式系统中实现语音合成的应用。OptiSpeech的开发得到了Pneuma Solutions提供的GPU资源支持,显著加速了开发进程。

人级别文本转语音合成模型

StyleTTS 2 是一款文本转语音(TTS)模型,使用大型语音语言模型(SLMs)进行风格扩散和对抗训练,实现了人级别的 TTS 合成。它通过扩散模型将风格建模为潜在随机变量,以生成最适合文本的风格,而无需参考语音。此外,我们使用大型预训练的 SLMs(如 WavLM)作为判别器,并结合我们的创新可微持续时间建模进行端到端训练,从而提高了语音的自然度。StyleTTS 2 在单说话人 LJSpeech 数据集上超越了人类录音,并在多说话人 VCTK 数据集上与之匹配,得到了母语为英语的评审人员的认可。此外,当在 LibriTTS 数据集上进行训练时,我们的模型优于先前公开可用的零样本扩展模型。通过展示风格扩散和对抗训练与大型 SLMs 的潜力,这项工作在单个和多说话人数据集上实现了一个人级别的 TTS 合成。

让应用通过语音与文本的转换实现智能交互。

Azure 认知服务语音是微软推出的一款语音识别与合成服务,支持超过100种语言和方言的语音转文本和文本转语音功能。它通过创建可处理特定术语、背景噪音和重音的自定义语音模型,提高听录的准确度。此外,该服务还支持实时语音转文本、语音翻译、文本转语音等功能,适用于多种商业场景,如字幕生成、通话后听录分析、视频翻译等。

一款通过纯语言模型实现的文本到语音合成模型

OuteTTS-0.1-350M是一款基于纯语言模型的文本到语音合成技术,它不需要外部适配器或复杂架构,通过精心设计的提示和音频标记实现高质量的语音合成。该模型基于LLaMa架构,使用350M参数,展示了直接使用语言模型进行语音合成的潜力。它通过三个步骤处理音频:使用WavTokenizer进行音频标记化、CTC强制对齐创建精确的单词到音频标记映射、以及遵循特定格式的结构化提示创建。OuteTTS的主要优点包括纯语言建模方法、声音克隆能力、与llama.cpp和GGUF格式的兼容性。

基于深度学习的高质量文本到语音合成模型

F5-TTS是由SWivid团队开发的一个文本到语音合成(TTS)模型,它利用深度学习技术将文本转换为自然流畅、忠实于原文的语音输出。该模型在生成语音时,不仅追求高自然度,还注重语音的清晰度和准确性,适用于需要高质量语音合成的各种应用场景,如语音助手、有声读物制作、自动新闻播报等。F5-TTS模型在Hugging Face平台上发布,用户可以方便地下载和部署,支持多种语言和声音类型,具有很高的灵活性和可扩展性。

一个高效的语音合成模型,支持中英文及语音克隆。

MegaTTS 3 是由字节跳动开发的一款基于 PyTorch 的高效语音合成模型,具有超高质量的语音克隆能力。其轻量级架构只包含 0.45B 参数,支持中英文及代码切换,能够根据输入文本生成自然流畅的语音,广泛应用于学术研究和技术开发。

Llasa-3B 是一个基于 LLaMA 的文本到语音合成模型,支持中英文语音生成。

Llasa-3B 是一个强大的文本到语音(TTS)模型,基于 LLaMA 架构开发,专注于中英文语音合成。该模型通过结合 XCodec2 的语音编码技术,能够将文本高效地转换为自然流畅的语音。其主要优点包括高质量的语音输出、支持多语言合成以及灵活的语音提示功能。该模型适用于需要语音合成的多种场景,如有声读物制作、语音助手开发等。其开源性质也使得开发者可以自由探索和扩展其功能。

开源的语音识别和说话人分割模型推理代码

Reverb 是一个开源的语音识别和说话人分割模型推理代码,使用 WeNet 框架进行语音识别 (ASR) 和 Pyannote 框架进行说话人分割。它提供了详细的模型描述,并允许用户从 Hugging Face 下载模型。Reverb 旨在为开发者和研究人员提供高质量的语音识别和说话人分割工具,以支持各种语音处理任务。

开源AI语音处理工具包,支持语音增强、分离和目标说话人提取。

ClearerVoice-Studio是一个开源的AI驱动语音处理工具包,专为研究人员、开发者和最终用户设计。它提供了语音增强、语音分离、目标说话人提取等功能,并提供了最新的预训练模型以及训练和推理脚本,全部可通过此仓库访问。该工具包以其预训练模型、易用性、全面功能和社区驱动的特点而受到青睐。

生成高质量中文方言语音的大规模文本到语音模型。

Bailing-TTS是由Giant Network的AI Lab开发的大型文本到语音(TTS)模型系列,专注于生成高质量的中文方言语音。该模型采用持续的半监督学习和特定的Transformer架构,通过多阶段训练过程,有效对齐文本和语音标记,实现中文方言的高质量语音合成。Bailing-TTS在实验中展现出接近人类自然表达的语音合成效果,对于方言语音合成领域具有重要意义。

强大的零样本语音转换和文本到语音WebUI

GPT-SoVITS-WebUI是一个强大的零样本语音转换和文本到语音WebUI。它具有零样本TTS、少样本TTS、跨语言支持和WebUI工具等功能。该产品支持英语、日语和中文,提供了集成工具,包括语音伴奏分离、自动训练集分割、中文ASR和文本标注,帮助初学者创建训练数据集和GPT/SoVITS模型。用户可以通过输入5秒的声音样本,即可体验即时的文本到语音转换,还可以通过仅使用1分钟的训练数据对模型进行微调,以提高语音相似度和逼真度。产品支持环境准备、Python和PyTorch版本、快速安装、手动安装、预训练模型、数据集格式、待办事项和致谢。

基于MaskGCT模型的文本到语音演示

MaskGCT TTS Demo 是一个基于MaskGCT模型的文本到语音(TTS)演示,由Hugging Face平台上的amphion提供。该模型利用深度学习技术,将文本转换为自然流畅的语音,适用于多种语言和场景。MaskGCT模型因其高效的语音合成能力和对多种语言的支持而受到关注。它不仅可以提高语音识别和合成的准确性,还能在不同的应用场景中提供个性化的语音服务。目前,该产品在Hugging Face平台上提供免费试用,具体价格和定位信息需进一步了解。

语音转文字,支持实时语音识别、录音文件识别等

腾讯云语音识别(ASR)为开发者提供语音转文字服务的最佳体验。语音识别服务具备识别准确率高、接入便捷、性能稳定等特点。腾讯云语音识别服务开放实时语音识别、一句话识别和录音文件识别三种服务形式,满足不同类型开发者需求。技术先进,性价比高,多语种支持,适用于客服、会议、法庭等多场景。

一个实验性的文本到语音模型

OuteTTS是一个使用纯语言建模方法生成语音的实验性文本到语音模型。它的重要性在于能够通过先进的语言模型技术,将文本转换为自然听起来的语音,这对于语音合成、语音助手和自动配音等领域具有重要意义。该模型由OuteAI开发,提供了Hugging Face模型和GGUF模型的支持,并且可以通过接口进行语音克隆等高级功能。

基于OpenAI Whisper的自动语音识别与说话人分割

whisper-diarization是一个结合了Whisper自动语音识别(ASR)能力、声音活动检测(VAD)和说话人嵌入技术的开源项目。它通过提取音频中的声音部分来提高说话人嵌入的准确性,然后使用Whisper生成转录文本,并通过WhisperX校正时间戳和对齐,以减少由于时间偏移导致的分割错误。接着,使用MarbleNet进行VAD和分割以排除静音,TitaNet用于提取说话人嵌入以识别每个段落的说话人,最后将结果与WhisperX生成的时间戳关联,基于时间戳检测每个单词的说话人,并使用标点模型重新对齐以补偿小的时间偏移。

一个拥有8200万参数的前沿文本到语音(TTS)模型。

Kokoro-82M是一个由hexgrad创建并托管在Hugging Face上的文本到语音(TTS)模型。它具有8200万参数,使用Apache 2.0许可证开源。该模型在2024年12月25日发布了v0.19版本,并提供了10种独特的语音包。Kokoro-82M在TTS Spaces Arena中排名第一,显示出其在参数规模和数据使用上的高效性。它支持美国英语和英国英语,可用于生成高质量的语音输出。

语音合成工具,提供高质量的语音生成服务

Fish Speech是一款专注于语音合成的产品,它通过使用先进的深度学习技术,能够将文本转换为自然流畅的语音。该产品支持多种语言,包括中文、英文等,适用于需要文本到语音转换的场景,如语音助手、有声读物制作等。Fish Speech以其高质量的语音输出、易用性和灵活性为主要优点,背景信息显示,该产品不断更新,增加了数据集大小,并改进了量化器的参数,以提供更好的服务。

最逼真的文本转语音和语音转文本工具

Voiser是一款拥有550多种不同语音选项的文本转语音工具。它可以将文字转换为逼真的机器语音,并提供人类声音的最接近的机器语音。此外,Voiser还可以将语音文件转换为文字,提供快速且准确的语音转文本服务。Voiser是最佳的文本朗读和语音转换解决方案。

将文本转换为逼真语音的在线工具

该产品是一个先进的在线文字转语音工具,使用人工智能技术将文本转换为自然逼真的语音。它支持多种语言和语音风格,适用于广告、视频旁白、有声书制作等场景,增强了内容的可访问性和吸引力。产品背景信息显示,它为数字营销人员、内容创作者、有声书作者和教育工作者提供了极大的便利。

高质量、多功能的语音合成模型系列

Seed-TTS是由字节跳动推出的一系列大规模自回归文本到语音(TTS)模型,能够生成与人类语音难以区分的语音。它在语音上下文学习、说话人相似度和自然度方面表现出色,通过微调可进一步提升主观评分。Seed-TTS还提供了对情感等语音属性的优越控制能力,并能生成高度表达性和多样性的语音。此外,提出了一种自蒸馏方法用于语音分解,以及一种增强模型鲁棒性、说话人相似度和控制性的强化学习方法。还展示了Seed-TTS模型的非自回归(NAR)变体Seed-TTSDiT,它采用完全基于扩散的架构,不依赖于预先估计的音素持续时间,通过端到端处理进行语音生成。

开源文本转语音系统

Whisper Speech是一款完全开源的文本转语音模型,由Collabora和Lion在Juwels超级计算机上训练。它支持多种语言和多种形式的输入,包括Node.js、Python、Elixir、HTTP、Cog和Docker。该模型的优势在于高效的语音合成和灵活的部署方式。定价方面,Whisper Speech完全免费。它定位于为开发者和研究人员提供一个强大的、可定制的文本转语音解决方案。

300+语音,78种语言,文本转语音

Speechki ChatGPT插件是一款支持78种语言和方言,提供300多种逼真声音选择的ChatGPT认可的文本转语音插件。将您的文本转换为高质量的音频内容,体验文本转语音的简便使用方式。立即体验Speechki,发现内容创作的未来!

世界上最快的文本到语音模型

Lightning是由smallest.ai开发的最新文本到语音模型,以其超快速度和小巧的体积在多模态AI中突破了性能和尺寸的界限。该模型支持英语和印地语等多种口音,并计划迅速扩展更多语言。Lightning的非自回归架构使其能够同时合成整个音频剪辑,与传统的自回归模型相比,后者需要逐步生成音频。Lightning的主要优点包括生成速度快、模型体积小、支持多语言和快速适应新数据。产品背景信息显示,Lightning的推出旨在帮助语音机器人公司大幅降低延迟和成本,通过简化其架构。价格方面,Lightning的定价从每分钟0.04美元起,对于每月使用超过100,000分钟的企业客户,提供定制定价方案。

© 2026 AIbase 备案号:闽ICP备08105208号-14