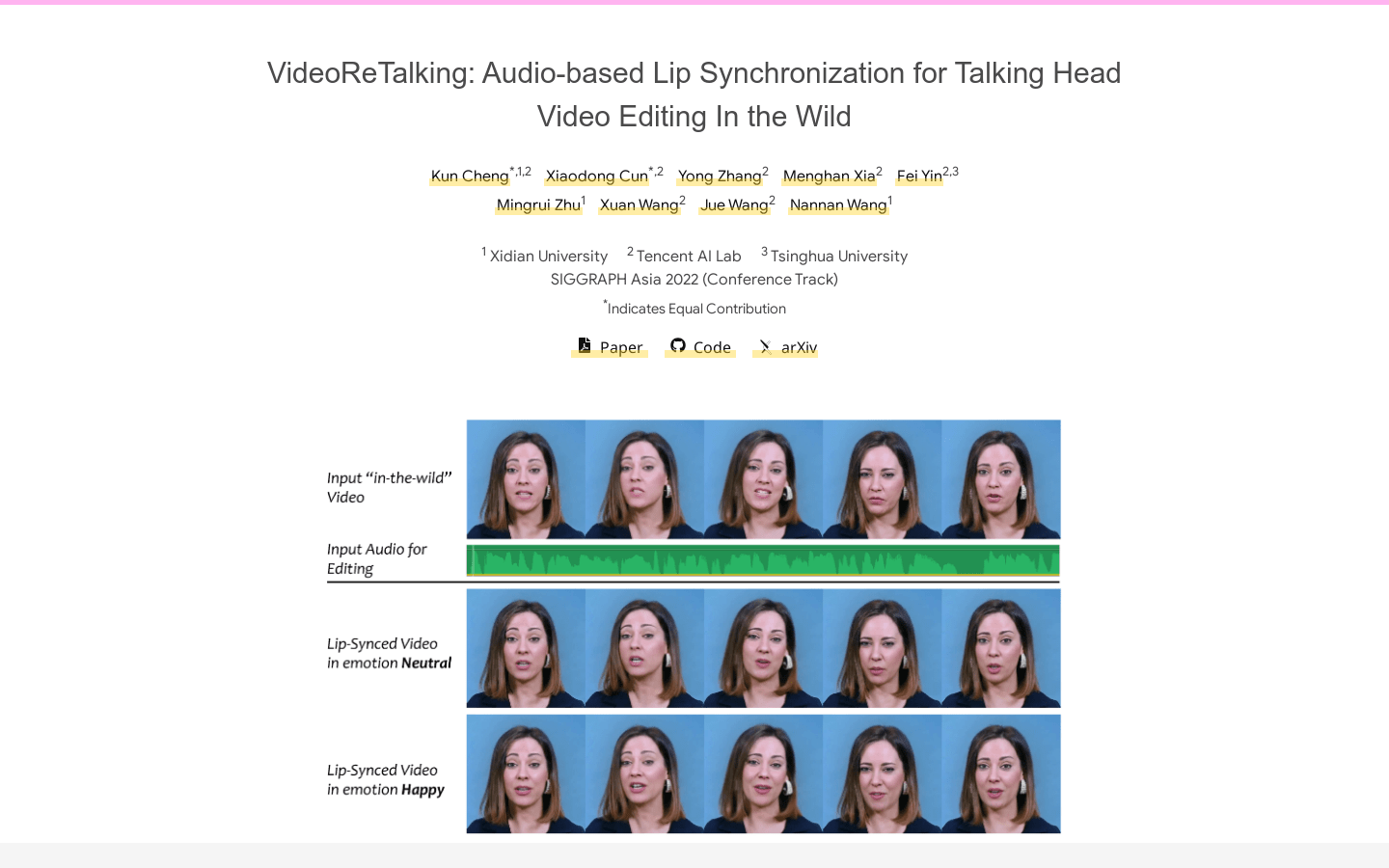

VideoReTalking是一个新的系统,可以根据输入的音频编辑真实世界的说话头部视频的面部,产生高质量的唇形同步输出视频,即使情感不同。该系统将此目标分解为三个连续的任务:(1)使用表情编辑网络生成带有规范表情的面部视频;(2)音频驱动的唇形同步;(3)用于提高照片逼真度的面部增强。给定一个说话头部视频,我们首先使用表情编辑网络根据相同的表情模板修改每个帧的表情,从而得到具有规范表情的视频。然后将该视频与给定的音频一起输入到唇形同步网络中,生成唇形同步视频。最后,我们通过一个身份感知的面部增强网络和后处理来提高合成面部的照片逼真度。我们对所有三个步骤使用基于学习的方法,所有模块都可以在顺序管道中处理,无需任何用户干预。

需求人群:

"适用于需要音频驱动的唇形同步的视频编辑场景,可以用于电影、电视剧、广告等领域。"

使用场景示例:

电影制作人使用VideoReTalking来编辑电影中的角色对白,实现高质量唇形同步。

广告公司使用VideoReTalking来制作广告,使演员的口型与音频完美匹配。

电视剧制作人使用VideoReTalking来编辑电视剧中的角色对白,实现高质量唇形同步。

产品特色:

音频驱动的唇形同步

面部增强

表情编辑

高质量唇形同步视频生成

无需用户干预

浏览量:1199

最新流量情况

月访问量

370

平均访问时长

00:00:00

每次访问页数

1.02

跳出率

43.16%

流量来源

直接访问

41.83%

自然搜索

33.58%

邮件

0.19%

外链引荐

12.66%

社交媒体

9.64%

展示广告

0

截止目前所有流量趋势图

地理流量分布情况

美国

100.00%

音频驱动的视频编辑,实现高质量唇形同步

VideoReTalking是一个新的系统,可以根据输入的音频编辑真实世界的说话头部视频的面部,产生高质量的唇形同步输出视频,即使情感不同。该系统将此目标分解为三个连续的任务:(1)使用表情编辑网络生成带有规范表情的面部视频;(2)音频驱动的唇形同步;(3)用于提高照片逼真度的面部增强。给定一个说话头部视频,我们首先使用表情编辑网络根据相同的表情模板修改每个帧的表情,从而得到具有规范表情的视频。然后将该视频与给定的音频一起输入到唇形同步网络中,生成唇形同步视频。最后,我们通过一个身份感知的面部增强网络和后处理来提高合成面部的照片逼真度。我们对所有三个步骤使用基于学习的方法,所有模块都可以在顺序管道中处理,无需任何用户干预。

将音频流转换为面部表情,实现实时唇形同步和面部表演。

Audio-to-Face 是 NVIDIA NIM 提供的一项技术,能够将音频流实时转换为面部表情,用于唇形同步和面部表演。这项技术主要应用于数字人领域,通过先进的机器学习算法,实现高度逼真的面部动作生成。它不仅能够提升数字人物的自然度和真实感,还能够在游戏、电影制作、虚拟现实等领域提供强大的支持。

高精度视频唇形同步技术

Wav2Lip 是一个开源项目,旨在通过深度学习技术实现视频中人物的唇形与任意目标语音高度同步。该项目提供了完整的训练代码、推理代码和预训练模型,支持任何身份、声音和语言,包括CGI面孔和合成声音。Wav2Lip 背后的技术基于论文 'A Lip Sync Expert Is All You Need for Speech to Lip Generation In the Wild',该论文在ACM Multimedia 2020上发表。项目还提供了一个交互式演示和Google Colab笔记本,方便用户快速开始使用。此外,项目还提供了一些新的、可靠的评估基准和指标,以及如何在论文中计算这些指标的说明。

音频驱动的唇形同步生成器,可将图片转为无限长度生动视频,免费试用。

Infinite Talk AI是一款由Meigen团队打造的音频驱动视频工具,利用先进技术将简单音频转化为动态逼真的虚拟形象视频。其定位是为创作者、教育工作者和企业提供专业的视频生成解决方案。产品重要性在于突破传统视频制作限制,实现无限时长、高稳定性及精准唇形同步的视频生成。优点包括无限时长、超逼真效果、多语言支持、高稳定性、精准唇形同步等。价格方面提供免费试用机会,具体付费模式可参考官网定价页面。

使用我们的免费AI唇形同步工具,创建栩栩如生的唇形同步视频,无需注册!快速、准确、易于使用,立即将音频与视频同步!

LipSync是一个基于AI技术的免费在线唇形同步视频工具,用户可以利用该工具轻松制作唇形同步视频。其主要优点包括快速、准确,无需注册即可使用。

AI头像、唇形同步、语音克隆、文字生成视频

a2e.ai是一款AI工具,提供AI头像、唇形同步、语音克隆、文字生成视频等功能。该产品具有高清晰度、高一致性、高效生成速度等优点,适用于各种场景,提供完整的头像AI工具集。

AI视频唇形同步工具,为创作者而生

sync. 是一款利用人工智能技术的视频唇形同步工具,它能够将任何视频中的嘴唇动作与任何音频同步,实现自然、准确且即时的唇形匹配。该工具不仅为内容创作者、播客和YouTube频道主提供了重新利用旧内容的可能,还通过其开发工具,帮助开发者在他们的应用程序中集成sync.功能,从而加速产品的全球影响力。此外,sync.支持多种语言,可以轻松地将内容翻译成任何语言,具有生命般的即时唇形同步效果。

AI视频翻译、配音和唇形同步工具

Vozo Video Translator是一款利用人工智能技术提供视频翻译、配音和唇形同步服务的产品。它通过精确的AI翻译技术,结合背景知识,提供定制化、符合语境的翻译,适应用户的风格和语调偏好,确保翻译结果自然流畅。Vozo Video Translator的主要优点包括准确的语境翻译、AI驱动的校对和润色、真实的语音克隆和情感保留、以及多语种的唇形同步技术。产品背景信息显示,Vozo Video Translator支持多种语言的翻译,适用于全球市场,价格方面,新用户可以获得30积分的免费试用,之后可以根据需要升级计划。

使用AI技术重写、配音、克隆声音并实现唇形同步。

Talking Avatar是一款利用人工智能技术,允许用户通过编辑文本来更新旁白,无需重新录制,即可改变声音,包括口音、语调和情感。它支持一键多人唇形同步,确保视频观看体验自然而沉浸。此外,它还支持一句话声音克隆技术,用户只需提供一句话的音频样本,即可克隆任何声音,并用于生成任何语音。这款产品对于视频创作者、广告代理商、市场营销人员和教育工作者等都是一个强大的工具,可以轻松地将经典视频片段转化为新的热门内容,或者为不同平台优化视频内容。

与AI聊天,用Seedance 2.0创作视频,支持唇形同步和AI配音。

Seedance 2.0是一款基于AI技术的视频生成工具,通过与AI交互即可生成视频。其主要优点是操作简单,能快速生成具有专业水准的视频。产品背景依托Medeo平台,为用户提供创新的视频创作体验。价格信息未提及。定位是为有视频创作需求的用户提供便捷高效的创作工具。

专业AI视频生成器,具备音视频同步、多语言唇形同步和电影级镜头控制

Seedance 1.5 Pro是一款先进的AI视频生成平台,专为专业内容创作者设计。其采用双分支扩散变压器架构,结合跨模态联合模块,实现了原生音视频同步、精准的多语言唇形同步和电影级镜头控制。该平台的推理速度比上一代模型快10倍以上,通过高质量数据集的监督微调以及基于多维奖励模型的强化学习进行优化,确保输出符合专业内容创作标准。价格信息未提及。

行业领先的面部操作平台

FaceFusion是一个行业领先的面部操作平台,专注于面部交换、唇形同步和深度操作技术。它利用先进的人工智能技术,为用户提供高度逼真的面部操作体验。FaceFusion在图像处理和视频制作领域具有广泛的应用,尤其是在娱乐和媒体行业。

免费AI视频翻译器,在线翻译60多种语言,唇形同步,几分钟完成

AI视频翻译器是新一代的视频翻译技术产品,其定位主要是为全球用户提供高效、免费且高质量的视频翻译服务。该产品背景基于先进的AI技术,经过数百万小时的视频数据训练。其重要性在于打破语言障碍,助力内容触达全球观众。主要优点包括快速高效,比传统方法快100倍;免费使用,无需支付配音服务费;拥有完美唇同步技术,翻译音频与唇形精准匹配;支持30多种语言,覆盖全球范围。

视频到音频生成模型,增强同步性

MaskVAT是一种视频到音频(V2A)生成模型,它利用视频的视觉特征来生成与场景匹配的逼真声音。该模型特别强调声音的起始点与视觉动作的同步性,以避免不自然的同步问题。MaskVAT结合了全频带高质量通用音频编解码器和序列到序列的遮蔽生成模型,能够在保证高音频质量、语义匹配和时间同步性的同时,达到与非编解码器生成音频模型相媲美的竞争力。

统一音视频同步的面部表演者生成

ReSyncer是一个创新的框架,致力于通过先进的风格注入Transformer技术,实现音频与视频的高效同步。它不仅能够生成高保真的唇形同步视频,还支持快速个性化微调、视频驱动的唇形同步、说话风格的转换,甚至面部交换等特性。这些功能对于创建虚拟主持人和表演者至关重要,能够显著提升视频内容的自然度和真实感。

实时语音驱动的逼真AI克隆人

Pickle是一个创新的在线服务,它允许用户创建一个逼真的AI克隆人,这个克隆人可以实时唇形同步用户的语音,并在视频会议中代替用户出现。这项技术的重要性在于,它提供了一种新的远程工作和在线交流的方式,尤其对于那些不方便露面、需要移动性或需要休息的用户来说,Pickle可以让他们保持在会议中的存在感。产品背景信息显示,Pickle由Pickle, Inc.开发,位于美国加利福尼亚州旧金山。关于价格和定位,页面上没有提供具体信息,可能需要进一步联系客服了解。

视觉配音中个性化人物形象的呈现

PersonaTalk是一个基于注意力机制的两阶段框架,用于实现高保真度和个性化的视觉配音。该技术通过风格感知的音频编码模块和双注意力面部渲染器,能够在合成准确的唇形同步的同时,保持和突出说话者的“个性”。它不仅能够捕捉说话者独特的说话风格,还能保留面部细节,这对于音频驱动的视觉配音来说是一个相当大的挑战。PersonaTalk的主要优点包括视觉质量高、唇形同步准确以及个性保持,它作为一个通用框架,能够达到与特定人物方法相媲美的性能。

基于流匹配的音频驱动说话人像视频生成方法

FLOAT是一种音频驱动的人像视频生成方法,它基于流匹配生成模型,将生成建模从基于像素的潜在空间转移到学习到的运动潜在空间,实现了时间上一致的运动设计。该技术引入了基于变换器的向量场预测器,并具有简单而有效的逐帧条件机制。此外,FLOAT支持语音驱动的情感增强,能够自然地融入富有表现力的运动。广泛的实验表明,FLOAT在视觉质量、运动保真度和效率方面均优于现有的音频驱动说话人像方法。

音频驱动的表情丰富的视频生成模型

MEMO是一个先进的开放权重模型,用于音频驱动的说话视频生成。该模型通过记忆引导的时间模块和情感感知的音频模块,增强了长期身份一致性和运动平滑性,同时通过检测音频中的情感来细化面部表情,生成身份一致且富有表情的说话视频。MEMO的主要优点包括更真实的视频生成、更好的音频-唇形同步、身份一致性和表情情感对齐。该技术背景信息显示,MEMO在多种图像和音频类型中生成更真实的说话视频,超越了现有的最先进方法。

提供视频翻译、换 脸、语音克隆等 AI 技术,快速制作本地化营销视频

BoomCut是一个一站式AI视频本地化平台,专为全球市场营销设计。它提供视频翻译、面部交换、声音克隆等功能,快速创建本地化营销视频。这个平台支持10种本地语言,覆盖15亿人口,极大提高了营销效率。BoomCut通过AI技术,如字幕擦除、视频翻译,帮助企业打破语言障碍,扩大视频覆盖范围,降低海外本地化成本。产品背景信息显示,BoomCut深受合作客户信任,从个体卖家到行业领导者都有使用。价格方面,BoomCut提供免费试用,让用户可以先体验产品效果。

AI名人语音生成器,创建逼真的配音和视频。

KlipLab是一个利用人工智能技术的平台,允许用户使用名人、公众人物和虚构角色的声音来创建配音和唇形同步视频。用户只需选择一个声音,输入文本,KlipLab就能生成一个唇形同步的视频。这个技术的重要性在于它能够为视频内容创作者提供一种快速、高效的方式来制作高质量的视频内容,同时增加视频的吸引力和互动性。KlipLab提供了多种声音选择,并且支持高清视频输出,适合社交媒体和内容创作者使用。

AI唇同步视频生成器,可将长音频转化为逼真的口型同步视频。

LipsyncX是一款AI唇同步视频生成器,专为长格式播客、有声读物和脚本设计。其重要性在于能够帮助用户快速高效地将各种类型的音频或文本转化为具有自然唇同步效果的视频。主要优点包括快速渲染、工作室级别的质量、支持多种语言、提供多种模型选择以及无缝的视频翻译功能。产品背景是为了满足创作者和团队对于高效视频制作的需求。价格方面,提供免费的2美元起始余额,之后按0.11美元/秒的价格按需付费。产品定位是为创作者和团队提供便捷、高效的视频制作解决方案。

基于扩散模型的音频驱动人像和动物图像动画技术

JoyVASA是一种基于扩散模型的音频驱动人像动画技术,它通过分离动态面部表情和静态3D面部表示来生成面部动态和头部运动。这项技术不仅能够提高视频质量和唇形同步的准确性,还能扩展到动物面部动画,支持多语言,并在训练和推理效率上有所提升。JoyVASA的主要优点包括更长视频生成能力、独立于角色身份的运动序列生成以及高质量的动画渲染。

将静态肖像和输入音频转化为生动的动画对话视频

AniTalker是一个创新的框架,它能够从单一的肖像生成逼真的对话面部动画。它通过两个自监督学习策略增强了动作表现力,同时通过度量学习开发了一个身份编码器,有效减少了对标记数据的需求。AniTalker不仅能够创建详细且逼真的面部动作,还强调了其在现实世界应用中制作动态头像的潜力。

个性化语音驱动的3D面部动画

Imitator是一种新颖的个性化语音驱动的3D面部动画方法。通过给定音频序列和个性化风格嵌入作为输入,我们生成具有准确唇部闭合的个人特定运动序列,用于双唇辅音('m','b','p')。可以通过短参考视频(例如5秒)计算主体的风格嵌入。

© 2026 AIbase 备案号:闽ICP备08105208号-14