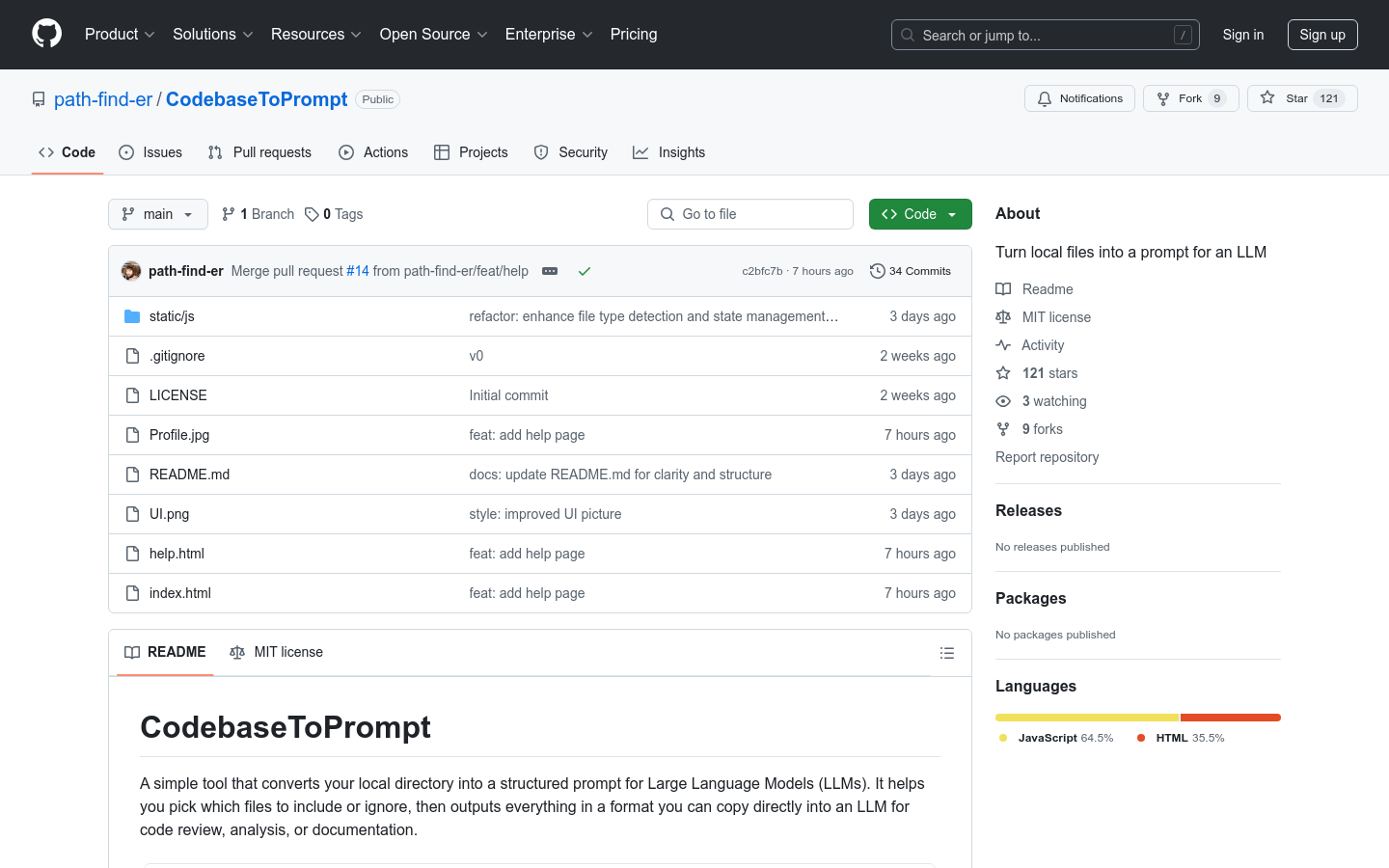

CodebaseToPrompt 是一个简单工具,能够将本地目录转换为大型语言模型(LLM)的结构化提示。它帮助用户选择需要包含或忽略的文件,然后以可以直接复制到 LLM 中的格式输出,适用于代码审查、分析或文档生成。该工具的主要优点在于其交互性强、操作简便,并且能够在浏览器中直接使用,无需上传任何文件,确保了数据的安全性和隐私性。产品背景信息显示,它是由 path-find-er 团队开发,旨在提高开发者在使用 LLM 进行代码相关任务时的效率。

需求人群:

"目标受众为需要使用大型语言模型进行代码审查、分析或文档生成的开发者和编程爱好者。该工具适合那些希望快速将代码文件转换为 LLM 可用格式的用户,能够提高他们的工作效率并简化操作流程。"

使用场景示例:

开发者在进行代码审查时,使用 CodebaseToPrompt 快速生成包含关键代码片段的提示,以便与 LLM 进行交互。

编程爱好者在学习新的编程语言或框架时,利用该工具将示例代码转换为 LLM 可用的格式,以获取更详细的解释和指导。

项目负责人在准备项目文档时,通过 CodebaseToPrompt 选择重要的代码文件,生成结构化的提示,以便更好地向团队成员或客户展示项目细节。

产品特色:

交互式文件树:在简单界面中浏览和展开本地文件夹

文件过滤:自动忽略系统或二进制文件(如 .DS_Store、node_modules、图片、视频)

本地存储:记住用户的选择,方便下次继续使用

LLM-Ready 输出:生成易于粘贴到聊天机器人和其他 AI 工具中的格式

令牌计数估算:提供所选内容可能使用的令牌数量的粗略计算

支持多种浏览器:包括 Chrome、Edge、Firefox 和 Safari

自定义配置:允许用户根据需要修改 JavaScript 代码中的忽略列表

使用教程:

克隆该仓库,然后在现代浏览器中打开 index.html 文件(推荐使用 Chrome 或 Firefox)。

点击“选择目录”以选择要分析的文件夹。

展开或折叠目录,勾选或取消勾选文件以决定哪些文件被包含。

通过点击“复制到剪贴板”查看或复制生成的提示格式。

将复制的内容粘贴到 LLM 中进行代码审查、分析或其他相关任务。

浏览量:66

最新流量情况

月访问量

4.92m

平均访问时长

00:06:33

每次访问页数

6.11

跳出率

36.20%

流量来源

直接访问

51.61%

自然搜索

33.46%

邮件

0.04%

外链引荐

12.58%

社交媒体

2.19%

展示广告

0

截止目前所有流量趋势图

地理流量分布情况

中国

13.25%

德国

3.63%

印度

9.32%

俄罗斯

4.28%

美国

19.34%

将本地文件转换为大型语言模型的结构化提示工具

CodebaseToPrompt 是一个简单工具,能够将本地目录转换为大型语言模型(LLM)的结构化提示。它帮助用户选择需要包含或忽略的文件,然后以可以直接复制到 LLM 中的格式输出,适用于代码审查、分析或文档生成。该工具的主要优点在于其交互性强、操作简便,并且能够在浏览器中直接使用,无需上传任何文件,确保了数据的安全性和隐私性。产品背景信息显示,它是由 path-find-er 团队开发,旨在提高开发者在使用 LLM 进行代码相关任务时的效率。

一个轻量级且强大的多智能体工作流框架

OpenAI Agents SDK是一个用于构建多智能体工作流的框架。它允许开发者通过配置指令、工具、安全机制和智能体之间的交接来创建复杂的自动化流程。该框架支持与任何符合OpenAI Chat Completions API格式的模型集成,具有高度的灵活性和可扩展性。它主要用于编程场景中,帮助开发者快速构建和优化智能体驱动的应用程序。

基于LLM的代理框架,用于在代码库中执行大规模代码迁移。

Aviator Agents 是一款专注于代码迁移的编程工具。它通过集成LLM技术,能够直接与GitHub连接,支持多种模型,如Open-AI o1、Claude Sonnet 3.5、Llama 3.1和DeepSeek R1。该工具可以自动执行代码迁移任务,包括搜索代码依赖、优化代码、生成PR等,极大提高了代码迁移的效率和准确性。它主要面向开发团队,帮助他们高效完成代码迁移工作,节省时间和精力。

OmniParser V2 是一种将任何 LLM 转化为计算机使用代理的技术。

OmniParser V2 是微软研究团队开发的一种先进的人工智能模型,旨在将大型语言模型(LLM)转化为能够理解和操作图形用户界面(GUI)的智能代理。该技术通过将界面截图从像素空间转换为可解释的结构化元素,使 LLM 能够更准确地识别可交互图标,并在屏幕上执行预定动作。OmniParser V2 在检测小图标和快速推理方面取得了显著进步,其结合 GPT-4o 在 ScreenSpot Pro 基准测试中达到了 39.6% 的平均准确率,远超原始模型的 0.8%。此外,OmniParser V2 还提供了 OmniTool 工具,支持与多种 LLM 结合使用,进一步推动了 GUI 自动化的发展。

高质量的数据集、工具和概念,用于大型语言模型的微调。

mlabonne/llm-datasets 是一个专注于大型语言模型(LLM)微调的高质量数据集和工具的集合。该产品为研究人员和开发者提供了一系列经过精心筛选和优化的数据集,帮助他们更好地训练和优化自己的语言模型。其主要优点在于数据集的多样性和高质量,能够覆盖多种使用场景,从而提高模型的泛化能力和准确性。此外,该产品还提供了一些工具和概念,帮助用户更好地理解和使用这些数据集。其背景信息包括由 mlabonne 创建和维护,旨在推动 LLM 领域的发展。

FlashInfer是一个用于大型语言模型服务的高性能GPU内核库。

FlashInfer是一个专为大型语言模型(LLM)服务而设计的高性能GPU内核库。它通过提供高效的稀疏/密集注意力机制、负载平衡调度、内存效率优化等功能,显著提升了LLM在推理和部署时的性能。FlashInfer支持PyTorch、TVM和C++ API,易于集成到现有项目中。其主要优点包括高效的内核实现、灵活的自定义能力和广泛的兼容性。FlashInfer的开发背景是为了满足日益增长的LLM应用需求,提供更高效、更可靠的推理支持。

利用LLM读取源代码并提供问题解答

askrepo是一个基于LLM(大型语言模型)的源代码阅读工具,它能够读取Git管理的文本文件内容,发送至Google Gemini API,并根据指定的提示提供问题的答案。该产品代表了自然语言处理和机器学习技术在代码分析领域的应用,其主要优点包括能够理解和解释代码的功能,帮助开发者快速理解新项目或复杂代码库。产品背景信息显示,askrepo适用于需要深入理解代码的场景,尤其是在代码审查和维护阶段。该产品是开源的,可以免费使用。

强大的多模态LLM,商业解决方案

Reka Core是一个GPT-4级别的多模态大型语言模型(LLM),具备图像、视频和音频的强大上下文理解能力。它是目前市场上仅有的两个商用综合多模态解决方案之一。Core在多模态理解、推理能力、编码和Agent工作流程、多语言支持以及部署灵活性方面表现出色。

将LLM接入Comfy UI的插件

Tara是一款插件,可以将大型语言模型(LLM)接入到Comfy UI中,支持简单的API设置,并集成LLaVa模型。其中包含TaraPrompter节点用于生成精确结果、TaraApiKeyLoader节点管理API密钥、TaraApiKeySaver节点安全保存密钥、TaraDaisyChainNode节点串联输出实现复杂工作流。

发现和运行本地LLM

LM Studio是一个易于使用的桌面应用程序,用于在本地实验和运行本地和开源的Large Language Models (LLMs)。LM Studio跨平台桌面应用程序允许您从Hugging Face下载和运行任何ggml兼容的模型,并提供了一个简单而强大的模型配置和推理界面。该应用程序在有GPU的情况下利用您的GPU。

开源UI可视化工具,轻松构建定制化的LLM流程

Flowise是一个开源的UI可视化工具,使用LangchainJS编写,用于构建定制化的LLM流程。它支持快速构建LLM应用程序,并提供可扩展的组件集成。Flowise可以用于构建LLM链、问答检索链、语言翻译链等多种应用场景。它是一个免费的开源项目,适用于商业和个人使用。

全球最强的编程和推理模型,提升开发效率。

Claude 4 是 Anthropic 最新推出的 AI 模型系列,具备强大的编程和推理能力,能够高效处理复杂任务。其卓越的性能使其在编程基准测试中名列前茅,成为开发者的重要工具。Claude 4 通过多项新功能的引入,提升了信息处理的效率和准确性,适合需要高效编码和逻辑推理的用户。

DeepSeek R1-0528 是一款开源大模型,性能媲美 OpenAI o3 模型。

DeepSeek R1-0528 是知名开源大模型平台 DeepSeek 发布的最新版本,具有高性能的自然语言处理和编程能力。它的发布引起了广泛关注,因其在编程任务中表现出色,能够准确回答复杂问题。该模型支持多种应用场景,是开发者和 AI 研究者的重要工具。预计后续将发布更详细的模型信息和使用指南,增强其功能和应用广度。

高效编码的AI代理VS Code扩展

Kilo Code是一个开源的AI代理VS Code扩展,可生成代码、自动化任务并提供建议。其主要优点包括自动生成代码、智能任务自动化、建议功能以及开源免费使用。产品定位为提高编码效率,减少重复性任务,适用于开发人员、编程爱好者等。

提供实时编程辅助的AI解决方案,帮助应对Leetcode风格的面试。

Ghost Engineer是一个提供实时编程帮助的AI工具,能在面试过程中隐藏在屏幕顶部,实时解决算法和系统设计问题。其优点包括无需切换窗口标签、无眼动或反光干扰、支持多种编程语言等。

BuildQL是一个AI驱动的软件学习开发和托管平台,让任何人都能轻松构建、部署和分享软件。

BuildQL是一个AI驱动的软件学习开发和托管平台,可以帮助用户学习构建他们想要构建的任何想法。其AI功能能够提供上下文理解、工作流程和确切解决方案,让用户轻松构建和分享他们的想法。

Seed-Coder 是一个开源的 8B 代码大型语言模型系列。

Seed-Coder 是字节跳动 Seed 团队推出的开源代码大型语言模型系列,包含基础、指令和推理模型,旨在通过最小的人力投入,自主管理代码训练数据,从而显著提升编程能力。该模型在同类开源模型中表现优越,适合于各种编码任务,定位于推动开源 LLM 生态的发展,适用于研究和工业界。

使用AI技术提供的Monorepo工具包,帮助快速构建应用程序。

MonoKit是一个AI驱动的monorepo工具包,提供了Next.js Turborepo起始套件,深度整合MCP服务器,以及适用于LLM的模板。它有助于加快应用程序的构建速度,并提供优化的代码结构,帮助AI代理更好地理解项目上下文,从而提供更准确的代码建议。

mutatio是一个AI提示工程平台,帮助AI工程师系统测试,衡量和优化提示。

mutatio是一个现代LLM提示实验平台,可帮助用户Craft,refine和optimize他们的AI提示。它允许用户创建和测试各种提示变异,以提高AI的输出质量。

Gemini 2.5 Pro 是一款功能强大的AI编程插件。

Gemini 2.5 Pro是一款基于最先进的AI技术的编程插件,能够提高编程效率,帮助用户快速生成高质量的代码。其背景信息包括由Google开发,定位于提升编程体验和加速开发流程。

提升编码体验的AI平台

Better AI Code是一个学习和练习编码的平台,利用最佳工具和技术帮助用户学习和练习编码。它提供高效的学习环境和丰富的编程资源,为编程爱好者和学习者提供优质的编程体验。

AI 助力快速检测、分析和修复应用程序漏洞。

CybeDefend是一个利用人工智能快速检测、分析和修复应用程序漏洞的安全解决方案。其主要优点在于AI辅助的智能漏洞检测、自动修复功能以及全面的安全分析和管理。定位于提供简单、高效的应用程序安全保障。

GPT-4.1 是一款在编程、指令跟随和长文本理解方面有显著提升的模型。

GPT-4.1 是一系列新模型,提供了显著的性能提升,特别是在编码、指令跟随和处理长文本上下文方面。它的上下文窗口扩大到 100 万标记,并且在真实世界的应用中表现出色,适合开发者创建更高效的应用程序。此模型的价格相对较低,且具有快速响应能力,使其在开发和执行复杂任务时更加高效。

mcp-use 是与 MCP 工具交互的最简单方式,支持自定义代理。

mcp-use 是一个开源的 MCP 客户端库,旨在帮助开发者将任何大型语言模型(LLM)连接到 MCP 工具,构建具有工具访问能力的自定义代理,而无需使用闭源或应用程序客户端。该产品提供了简单易用的 API 和强大的功能,可以应用于多个领域。

一个开放源代码的 14B 参数编程模型,具备高效的代码推理能力。

DeepCoder-14B-Preview 是一个基于强化学习的代码推理大型语言模型,能够处理长上下文,具有 60.6% 的通过率,适用于编程任务和自动化代码生成。该模型的优势在于其训练方法的创新,提供了比其他模型更优的性能,且完全开源,支持广泛的社区应用和研究。

一个智能助手,通过自然语言简化 AI 算法的调试和部署。

ComfyUI-Copilot 是一个基于 Comfy-UI 框架的智能助手,旨在通过自然语言交互简化和增强 AI 算法的调试和部署过程。该产品的设计目标是降低开发门槛,让即使是初学者也能轻松使用。其智能推荐功能和实时支持能够显著提高开发效率,解决开发过程中遇到的问题。同时,ComfyUI-Copilot 支持多种模型,并提供详细的节点查询和工作流建议,为用户提供全面的开发辅助。此项目仍在早期阶段,用户可通过 GitHub 获取最新代码和功能更新。

通过与LLM对话构建持久知识,存于本地Markdown文件

Basic Memory是一款知识管理系统,借助与LLM的自然对话构建持久知识,并保存于本地Markdown文件。它解决了多数LLM互动短暂、知识难留存的问题。其优点包括本地优先、双向读写、结构简单、可形成知识图谱、兼容现有编辑器、基础设施轻量。定位为帮助用户打造个人知识库,采用AGPL - 3.0许可证,无明确价格信息。

Gemini 2.5 是谷歌最智能的 AI 模型,具备推理能力。

Gemini 2.5 是谷歌推出的最先进的 AI 模型,具备高效的推理能力和编码性能,能够处理复杂问题,并在多项基准测试中表现出色。该模型引入了新的思维能力,结合增强的基础模型和后期训练,支持更复杂的任务,旨在为开发者和企业提供强大的支持。Gemini 2.5 Pro 可在 Google AI Studio 和 Gemini 应用中使用,适合需要高级推理和编码能力的用户。

© 2025 AIbase 备案号:闽ICP备08105208号-14