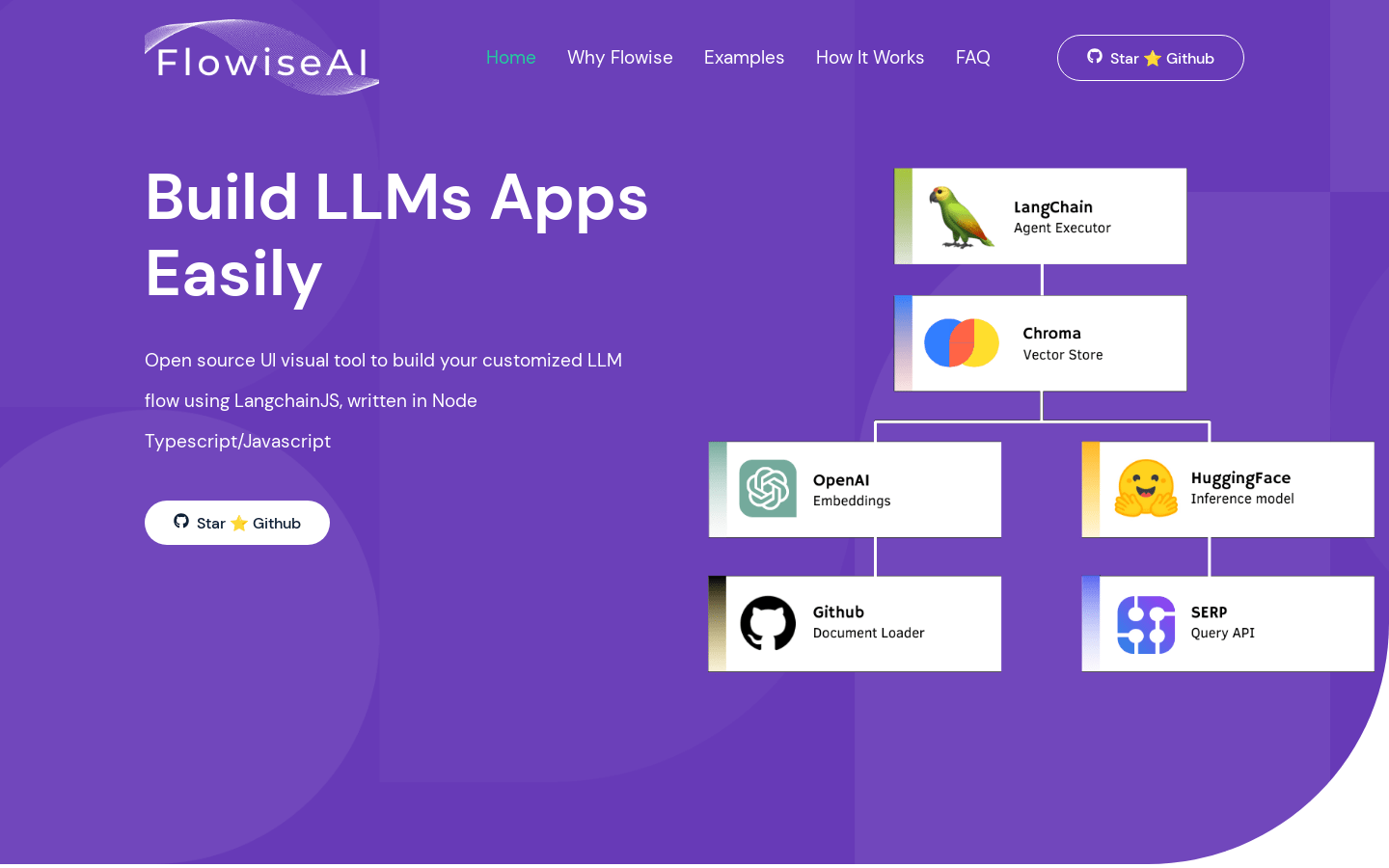

Flowise是一个开源的UI可视化工具,使用LangchainJS编写,用于构建定制化的LLM流程。它支持快速构建LLM应用程序,并提供可扩展的组件集成。Flowise可以用于构建LLM链、问答检索链、语言翻译链等多种应用场景。它是一个免费的开源项目,适用于商业和个人使用。

需求人群:

"Flowise适用于构建各种LLM应用场景,包括LLM链、问答检索链、语言翻译链等。"

使用场景示例:

使用Flowise构建一个LLM链的基本示例

使用Flowise构建一个问答检索链的示例

使用Flowise进行语言翻译的示例

产品特色:

快速构建LLM应用程序

支持定制化的LLM流程

提供可扩展的组件集成

浏览量:551

最新流量情况

月访问量

389.54k

平均访问时长

00:02:26

每次访问页数

3.89

跳出率

43.23%

流量来源

直接访问

38.99%

自然搜索

47.85%

邮件

0.09%

外链引荐

10.23%

社交媒体

2.06%

展示广告

0

截止目前所有流量趋势图

地理流量分布情况

巴西

7.94%

德国

4.49%

印度

9.09%

美国

18.48%

越南

4.48%

开源UI可视化工具,轻松构建定制化的LLM流程

Flowise是一个开源的UI可视化工具,使用LangchainJS编写,用于构建定制化的LLM流程。它支持快速构建LLM应用程序,并提供可扩展的组件集成。Flowise可以用于构建LLM链、问答检索链、语言翻译链等多种应用场景。它是一个免费的开源项目,适用于商业和个人使用。

可视化和透明的开源ChatGPT替代品

Show-Me是一个开源应用程序,旨在提供传统大型语言模型(如ChatGPT)交互的可视化和透明替代方案。它通过将复杂问题分解成一系列推理子任务,使用户能够理解语言模型的逐步思考过程。该应用程序使用LangChain与语言模型交互,并通过动态图形界面可视化推理过程。

用于提示工程的开源可视化编程环境

ChainForge是一款开源的可视化编程环境,专注于提示工程。它可以让你评估提示和文本生成模型的稳健性,超越了简单的案例证据。我们认为,提示多个大型语言模型、比较它们的响应并测试关于它们的假设,应该不仅容易,而且有趣。ChainForge提供了一套工具,以最小的努力评估和可视化提示(和模型)的质量。换句话说,它旨在让大型语言模型的评估变得简单。ChainForge开箱即用地支持测试提示注入攻击的稳健性、测试响应格式的一致性、发送大量参数化提示并导出到Excel文件、验证同一模型不同设置的响应质量、测量不同系统消息对ChatGPT输出的影响等。

可视化协作平台

Slatebox是一个可视化协作平台,提供AI辅助功能。用户可以通过自然语言输入来创建可编辑的可视化图表,包括思维导图、SWOT分析、Pro Con等。平台还支持实时协作和与第三方应用的集成。

AI辅助的UI设计工具,支持暗色系UI设计。

FLUX_UI设计是一个利用AI技术辅助用户生成具有艺术感的UI设计模型。它特别适用于B端的深色UI设计,支持发光效果,能够生成具有专业感和技术感的电商管理界面。该模型通过数据可视化和商业洞察,为商家提供全面的运营决策支持。

使用想象力描述UI,并实时查看渲染效果。

构建UI组件通常是一项乏味的工作。OpenUI旨在使这一过程变得有趣、快捷和灵活。这也是我们在W&B用于测试和原型化下一代工具的工具,用于在LLM的基础上构建强大的应用程序。您可以使用想象力描述UI,然后实时查看渲染效果。您可以要求进行更改,并将HTML转换为React、Svelte、Web组件等。就像是V0的开源和不太精致的版本。

CSV数据可视化

Chat2CSV是一个基于自然语言处理的数据可视化工具,将CSV数据转化为各种图表,以直观的方式呈现数据洞察力。通过简单的对话,您可以快速创建各种图表,无需编码或复杂的脚本。我们的平台支持多种图表类型,保护您的数据安全和隐私。试用免费版开始体验吧!

数据聊天,智能分析,可视化

DataChat是一款全能的分析平台,为每个人提供AI驱动的洞察力和令人惊叹的可视化效果。无论您是数据科学家还是普通用户,DataChat都能满足您的需求。通过简单的英语请求,您可以生成复杂的分析流程,轻松完成数据分析。与同事进行轻松协作,共同审查关键决策。将结果嵌入或共享到DataChat内部或任何其他地方。单击即可重新运行一致的分析,获得最新数据的结果。通过DataChat,让数据分析变得简单。

智能化数据可视化平台

Tablize是一个使用自然语言指令即可简单快速实现数据可视化和仪表板创建的平台。它利用AI技术,只需几个单词就可以将复杂的数据集成转化为直观的仪表板,无需编程技能,大大降低数据分析门槛,使数据洞察力普惠化。该产品重新定义了仪表板的创建方式,取代了传统冗长复杂的方法,为用户提供更高效、更友好的新体验。

可视化编辑提示词工具

OPS 提示词工作室是一款可视化编辑工具,支持一键翻译 AIGC 提示词,提供 Midjourney 提示词库,让用户轻松管理和使用提示词,助力提升生产力。该工具还提供简洁清晰的界面,方便用户快速复制、导出和翻译提示词。

无代码可视化编程平台

Bubble是一款无代码可视化编程平台,帮助用户以极快的速度构建、设计和发布应用程序。无需编码,从初次创业者到经验丰富的工程师,都能使用Bubble快速搭建应用程序。Bubble提供响应式设计、版本控制、AI功能等多种功能,适用于各种应用场景。Bubble还提供丰富的模板、插件和集成,以满足用户的不同需求。定价灵活,适合个人开发者、团队和企业使用。

3D可视化的GPT-style LLM

LLM Visualization项目显示了一个GPT-style网络的3D模型。也就是OpenAI的GPT-2、GPT-3(可能还有GPT-4)中使用的网络拓扑。第一个显示工作权重的网络是一个小型网络,对由字母A、B和C组成的小列表进行排序。这是Andrej Karpathy的minGPT实现中的演示示例模型。渲染器还支持可视化任意大小的网络,并且与较小的gpt2大小一起工作,尽管权重没有被下载(它有数百MB)。CPU Simulation项目运行2D原理数字电路,具有完整的编辑器。意图是添加一些演练,展示诸如:如何构建一个简单的RISC-V CPU;构成部分下至门级:指令解码、ALU、加法等;更高级的CPU思想,如各种级别的流水线、缓存等。

React可视化开发工具

MightyMeld是一款React可视化开发工具。它可以通过拖放、点击和提示的方式快速构建UI界面,同时生成看起来由你自己编写的代码。主要功能包括:实时同步本地代码,直观的Tailwind样式编辑器,拖放组件库,强大的AI辅助功能等。适用于各类React开发者,可以大幅提升开发效率。

自动化代码可视化工具

Zevo AI是一款代码可视化工具,加速代码理解、部署和观测。它可以帮助你优化代码交付、重构和开发流程,适用于传统和现有应用。Zevo AI使用动态代码分析和上下文理解,自动生成代码映射,帮助你搜索和理解代码库。它还提供实时代码可视化、代码审查、开发者引导等功能。

将LLM接入Comfy UI的插件

Tara是一款插件,可以将大型语言模型(LLM)接入到Comfy UI中,支持简单的API设置,并集成LLaVa模型。其中包含TaraPrompter节点用于生成精确结果、TaraApiKeyLoader节点管理API密钥、TaraApiKeySaver节点安全保存密钥、TaraDaisyChainNode节点串联输出实现复杂工作流。

可视化无代码开发平台

Softr是一个可视化无代码开发平台,帮助用户快速搭建响应式网站和应用。它具有丰富的功能和优势,包括易于使用的拖放编辑器、自定义样式和布局、数据集成、在线支付集成、SEO优化等。Softr提供灵活的定价计划,适用于个人用户、创业者和企业客户。它的定位是帮助用户快速搭建专业的网站和应用,无需编码。

可视化网站构建工具

Softr是一个可视化网站构建工具,可以帮助用户快速搭建自己的网站。它具有简单易用的界面和丰富的模板库,用户可以根据自己的需求选择合适的模板,并通过拖拽式编辑器进行定制。Softr还提供了丰富的功能,包括表单、数据库集成、用户认证等,同时支持响应式设计,适配各种屏幕大小。用户可以使用Softr创建个人博客、电子商务网站、企业官网等各种类型的网站。定价灵活多样,适合不同规模的用户使用。

日志和可视化计算机视觉数据

Rerun是一个用于记录计算机视觉和机器人数据的SDK,配有可视化工具,用于随时间查看和调试数据。它可以帮助您以最少的代码调试和理解系统的内部状态和数据。Rerun提供灵活、快速和可移植的功能,适用于实时应用和数据探索。

将数据转化为可视化图形的AI奇迹

D&AViz是一个强大的数据可视化工具,可以将原始数据转化为易于理解的可视化图形。通过上传Excel/CSV文件,查询工具,您可以观察到图形的产生,将复杂数据解码为可操作的见解,从而做出明智的决策。D&AViz结合了实时分析、切换视图和自定义输出格式等功能,使数据分析更简化、更有洞察力。

数据可视化和分析工具

Visprex是一个专注于数据可视化和分析的在线工具,它允许用户在浏览器中加载CSV文件,并进行本地处理,确保数据安全。该产品支持多种数据集,提供直方图、散点图和相关性矩阵等多种分析视图,帮助用户深入理解数据。Visprex以其易用性、强大的数据处理能力和直观的可视化效果,成为数据分析师和研究人员的重要工具。产品背景信息显示,Visprex旨在为用户提供一个安全、便捷的数据分析平台,无需复杂的编程知识即可进行深入的数据探索。

AI驱动的数据分析和可视化平台

SheetBot AI是一个利用人工智能技术,为用户提供数据分析、可视化和数据转换的一体化平台。它通过简化数据操作流程,允许用户用自然语言提问,快速获取AI驱动的洞察,并即时生成可视化结果。该产品通过自动化重复性的数据工作,节省用户时间,提高工作效率。它支持上传多种数据文件格式,包括但不限于电子表格,并提供高RAM环境以处理大型数据集。此外,SheetBot AI还强调数据安全性,确保用户数据在传输和处理过程中的加密和隔离。

© 2026 AIbase 备案号:闽ICP备08105208号-14