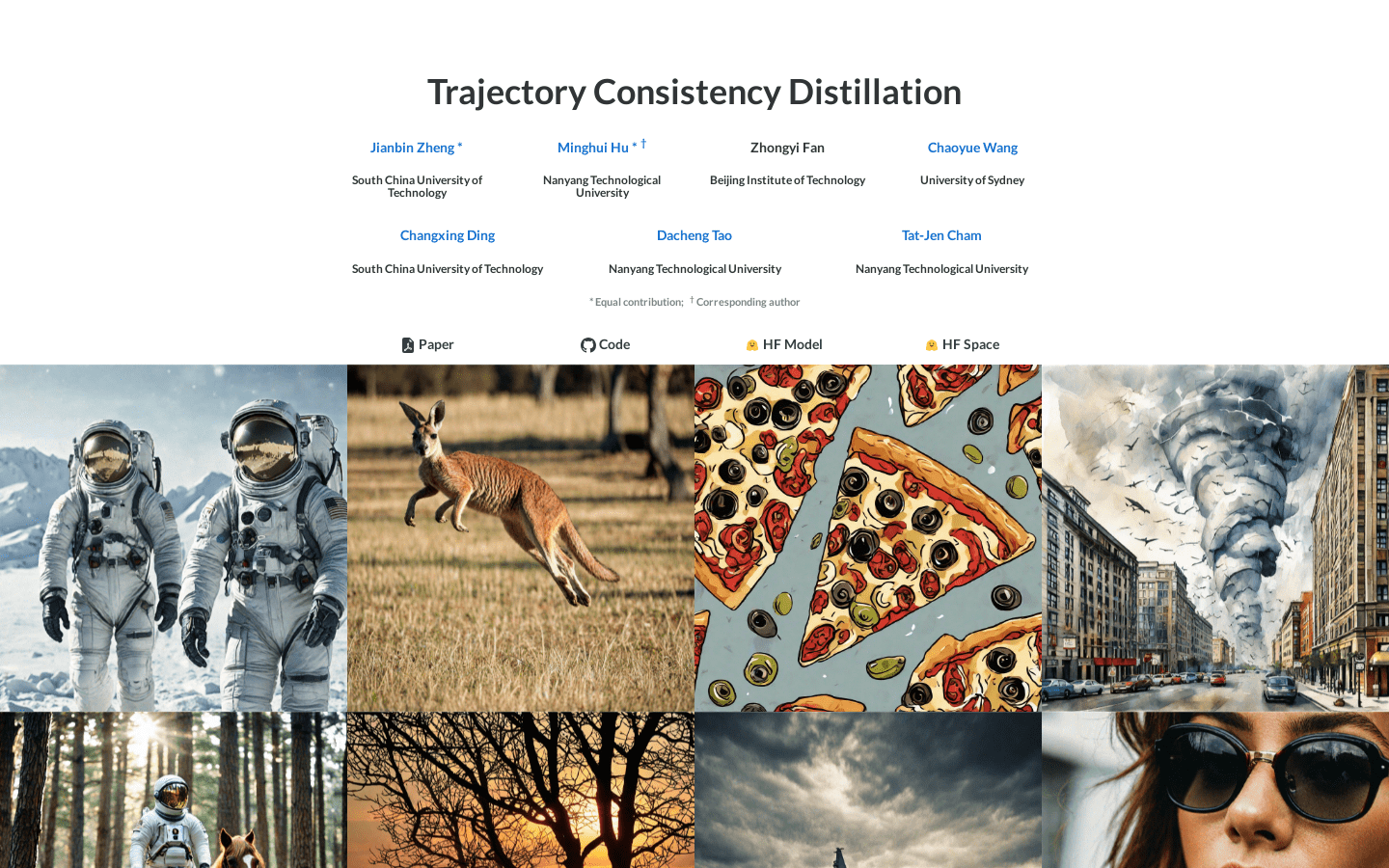

TCD是一种用于文本到图像合成的一致性蒸馏技术,它通过轨迹一致性函数(TCF)和策略性随机采样(SSS)来减少合成过程中的错误。TCD在低NFE(噪声自由能量)时显著提高图像质量,并在高NFE时保持比教师模型更详细的结果。TCD不需要额外的判别器或LPIPS监督,即可在低NFE和高NFE时均保持优越的生成质量。

需求人群:

"图像合成、艺术创作、视觉效果制作"

使用场景示例:

艺术家使用TCD技术将文本描述转化为高质量的艺术作品。

游戏开发者利用TCD生成游戏角色和环境的详细图像。

研究人员通过TCD在不同NFE下测试和比较不同图像合成模型的性能。

产品特色:

轨迹一致性函数(TCF)

策略性随机采样(SSS)

在不同NFE下保持图像质量

适应各种SDXL基础模型和社区插件

浏览量:157

提高文本到图像合成质量的一致性蒸馏技术

TCD是一种用于文本到图像合成的一致性蒸馏技术,它通过轨迹一致性函数(TCF)和策略性随机采样(SSS)来减少合成过程中的错误。TCD在低NFE(噪声自由能量)时显著提高图像质量,并在高NFE时保持比教师模型更详细的结果。TCD不需要额外的判别器或LPIPS监督,即可在低NFE和高NFE时均保持优越的生成质量。

训练无监督一致性文本到图像生成

ConsiStory是一个无需训练就能实现在预训练的文本到图像模型中生成一致性主体的方法。它不需要微调或个性化,因此比先前最优方法快20倍。我们通过引入以主体为驱动的共享注意力模块和基于对应关系的特征注入来增强模型,以促进图像之间的主体一致性。另外,我们开发了在保持主体一致性的同时鼓励布局多样性的策略。ConsiStory可以自然地扩展到多主体场景,甚至可以实现对常见对象的无需训练的个性化。

提高文本到图像模型中空间一致性的解决方案

SPRIGHT是一个专注于空间关系的大规模视觉语言数据集和模型。它通过重新描述600万张图像构建了SPRIGHT数据集,显著增加了描述中的空间短语。该模型在444张包含大量物体的图像上进行微调训练,从而优化生成具有空间关系的图像。SPRIGHT在多个基准测试中实现了空间一致性的最新水平,同时提高了图像质量评分。

利用LLM提高T2I图像生成一致性

OPT2I是一个T2I优化框架,利用大型语言模型(LLM)提高提示-图像一致性。通过迭代生成修订后的提示,优化生成过程。能显著提高一致性得分,同时保持FID并增加生成数据与真实数据召回率。

快速可控的图像生成与潜在一致性模型

PIXART LCM是一个文本到图像合成框架,将潜在一致性模型(LCM)和ControlNet集成到先进的PIXART-α模型中。PIXART LCM以其能够通过高效的训练过程生成1024px分辨率的高质量图像而闻名。在PIXART-δ中集成LCM显著加快了推理速度,使得仅需2-4步即可生成高质量图像。特别值得注意的是,PIXART-δ实现了在0.5秒内生成1024x1024像素图像的突破,比PIXART-α改进了7倍。此外,PIXART-δ经过精心设计,可在单日内在32GB V100GPU上进行高效训练。具有8位推理能力的PIXART-δ可以在8GB GPU内存约束下合成1024px图像,极大地增强了其可用性和可访问性。此外,引入类似于ControlNet的模块可以对文本到图像扩散模型进行精细控制。我们引入了一种新颖的ControlNet-Transformer架构,专门为Transformers量身定制,实现了显式可控性和高质量图像生成。作为一种最先进的开源图像生成模型,PIXART-δ为稳定扩散模型家族提供了一个有前途的选择,为文本到图像合成做出了重大贡献。

一种无需训练的单提示文本到图像生成方法,用于一致的图像生成。

1Prompt1Story是一种创新的文本到图像生成技术,能够在无需额外训练的情况下,通过单个提示生成一致的图像序列。该技术利用语言模型的上下文一致性,通过单个提示串联所有描述,生成具有身份一致性的图像。它支持多角色生成、空间控制生成以及真实图像个性化等功能,具有广泛的应用前景。该模型主要面向需要高效、一致图像生成的创作者和开发者,可用于故事创作、动画制作等领域。

稳定扩散VAE的一致性解码器

Consistency Decoder是一种用于稳定扩散VAE的改进解码器,提供更稳定的图像生成。它具有2.49GB的模型大小,支持从原始图像进行编码和使用GAN解码以及一致性解码。该产品定位于为图像生成提供更好的解码效果。

3D一致性的视频生成框架

CamCo是一个创新的图像到视频生成框架,它能够生成具有3D一致性的高质量视频。该框架通过Plücker坐标引入相机信息,并提出了一种符合几何一致性的双线约束注意力模块。此外,CamCo在通过运动结构算法估计相机姿态的真实世界视频上进行了微调,以更好地合成物体运动。

为扩散模型提供一致性分辨率适配

ResAdapter是一个为扩散模型(如Stable Diffusion)设计的分辨率适配器,它能够在保持风格域一致性的同时,生成任意分辨率和宽高比的图像。与处理静态分辨率图像的多分辨率生成方法不同,ResAdapter直接生成动态分辨率的图像,提高了推理效率并减少了额外的推理时间。

一致的文本到视频编辑的光流引导注意力

FLATTEN是一种用于文本到视频编辑的光流引导注意力插件。它通过在扩散模型的U-Net中引入光流来解决文本到视频编辑中的一致性问题。FLATTEN通过强制在不同帧上的相同光流路径上的补丁在注意模块中相互关注,从而提高了编辑视频的视觉一致性。此外,FLATTEN是无需训练的,可以无缝集成到任何基于扩散的文本到视频编辑方法中,并提高其视觉一致性。实验结果表明,我们提出的方法在现有的文本到视频编辑基准上取得了最新的性能。特别是,我们的方法在保持编辑视频的视觉一致性方面表现出色。

突破性AI图像生成器,支持一键编辑、多图融合和出色角色一致性。

Nano Banana Pro Image Generator是全球首个推理图像引擎,由Gemini 3 Pro Image提供支持。它从基础版本升级为专业版本,能实现像素级完美物理效果、图像一致性和真实世界知识集成。其主要优点包括快速生成图像、角色一致性高、上下文感知编辑等。该产品定位为专业的图像生成和编辑工具,可满足创意工作流程的多种需求。关于价格,页面未明确提及。

使用扩散模型实现时间一致性的人像动画

TCAN是一种基于扩散模型的新型人像动画框架,它能够保持时间一致性并很好地泛化到未见过的领域。该框架通过特有的模块,如外观-姿态自适应层(APPA层)、时间控制网络和姿态驱动的温度图,来确保生成的视频既保持源图像的外观,又遵循驱动视频的姿态,同时保持背景的一致性。

基于预训练的文本到图像模型生成高质量、多视角一致的3D物体图像。

ViewDiff 是一种利用预训练的文本到图像模型作为先验知识,从真实世界数据中学习生成多视角一致的图像的方法。它在U-Net网络中加入了3D体积渲染和跨帧注意力层,能够在单个去噪过程中生成3D一致的图像。与现有方法相比,ViewDiff生成的结果具有更好的视觉质量和3D一致性。

Nano Banana Pro AI,快速生成4K图像,角色一致、文本准确,支持专业编辑。

Nano Banana Pro AI是一款革命性的AI图像生成与编辑器,由Gemini 3 Pro提供支持。其主要优点在于解决了当前AI图像生成领域的关键问题,如角色一致性差、生成速度慢和文本识别不准确等。它能够在数秒内生成完美的4K图像,具有极高的角色一致性和文本准确性,生成速度比竞争对手快6倍。产品定位为专业级图像创作工具,适用于广告公司、社交媒体运营者、内容创作者等需要高效、高质量图像生成的用户。目前提供免费试用,具体付费价格未提及。

StoryDiffusion 能够通过生成一致的图像和视频来创造魔法故事。

StoryDiffusion 是一个开源的图像和视频生成模型,它通过一致自注意力机制和运动预测器,能够生成连贯的长序列图像和视频。这个模型的主要优点在于它能够生成具有角色一致性的图像,并且可以扩展到视频生成,为用户提供了一个创造长视频的新方法。该模型对AI驱动的图像和视频生成领域有积极的影响,并且鼓励用户负责任地使用该工具。

Nano Banana Pro是前沿AI图像生成引擎,4K画质、角色一致,推理生成强大。

Nano Banana Pro是BananaPro Studio推出的前沿AI图像生成引擎,它结合了先进的推理能力和卓越的视觉质量。该模型定位于为创作者提供高质量、高效率的图像生成解决方案。其优势在于能够输出增强的4K图像质量,具有工作室级别的输出效果;在无限变化中保持完美的角色一致性;具备先进的推理能力,能理解复杂提示并精准输出;还支持多模态提示,可结合文本、图像和风格参考。价格方面,可免费试用,无需信用卡。

Nana Banana 2是下一代文本到图像和编辑引擎,提供快速高质量视觉效果。

Nana Banana 2是一款前沿的文本到图像和图像编辑AI模型,基于先进架构构建,专为超低延迟和完美视觉连贯性进行了优化。它的优势在于具备场景感知智能、多图像融合和角色一致性等能力,能理解场景上下文、空间关系和对象语义,实现自然的图像编辑和生成。该模型由DeepMind的研究力量支持,融入了世界知识、场景逻辑和视觉推理。价格方面,部分功能免费,如创建角色、场景和产品等,具体收费情况未详细提及,定位主要面向需要高质量图像生成和编辑的创作者、营销人员等专业人士及商业场景。

AI角色一致性工具,为艺术家、设计师和内容创作者提供免费生成工具。

Ideogram Character是一个AI角色一致性工具,可以从单个参考图像中创建一致的AI角色,适用于艺术家、设计师和内容创作者。该工具利用先进的AI技术,帮助用户快速生成具有视觉连贯性的角色形象。提供免费生成,定位于为创意项目提供一致的视觉解决方案。

下一代 AI 模型,实现一致性和可控的媒体生成。

Runway Gen-4 是一款先进的 AI 模型,专注于媒体生成和世界一致性。它能够在多个场景中精准生成一致的角色、地点和物体,为创作者提供前所未有的创作自由,适合电影制作、广告及产品摄影等多种应用场景。该产品不需要进行细致的调优或额外训练,简化了创作流程,提升了视频制作的质量和效率。

深入研究大型语言模型的内部一致性和自我反馈

ICSFSurvey是一个关于大型语言模型内部一致性和自我反馈的调查研究。它提供了对LLMs自我评估和自我更新机制的统一视角,包括理论框架、系统分类、评估方法、未来研究方向等。

Veo 3.2可将图像转为4K视频,支持竖屏,确保角色和背景一致性。

Veo 3.2是一款增强型AI视频生成模型,可基于参考图像创建富有表现力的高质量视频。其重要性在于为创作者提供了新的创作可能性,无论是业余故事讲述者还是专业电影制作人都能从中受益。主要优点包括角色一致性、原生竖屏视频支持、4K上采样等,能实现专业级的视频制作效果。产品背景信息未详细提及价格方面,页面未明确说明是否付费,但有“Credits required”字样,推测可能需要付费使用。产品定位是面向广大视频创作人群,帮助他们更轻松地制作出高质量的视频。

生成具有身份一致性和表情丰富性的3D人头模型

ID-to-3D是一种创新的方法,它能够从一张随意拍摄的野外图片中生成具有身份和文本引导的3D人头模型,具有分离的表情。该方法基于组合性,使用特定任务的2D扩散模型作为优化的先验。通过扩展基础模型并添加轻量级的表情感知和身份感知架构,创建了2D先验,用于几何和纹理生成,并通过微调仅0.2%的可用训练参数。结合强大的面部身份嵌入和神经表示,该方法不仅能够准确重建面部特征,还能重建配饰和头发,并可提供适用于游戏和远程呈现的渲染就绪资产。

StreamingT2V: 一致、动态、可扩展的长视频文本生成

StreamingT2V 是一种先进的自回归技术,可以创建具有丰富动态运动的长视频,没有任何停滞。它确保视频中的时间一致性,与描述性文本紧密对齐,并保持高帧级图像质量。

多视图一致性图像生成的便捷解决方案

MV-Adapter是一种基于适配器的多视图图像生成解决方案,它能够在不改变原有网络结构或特征空间的前提下,增强预训练的文本到图像(T2I)模型及其衍生模型。通过更新更少的参数,MV-Adapter实现了高效的训练并保留了预训练模型中嵌入的先验知识,降低了过拟合风险。该技术通过创新的设计,如复制的自注意力层和并行注意力架构,使得适配器能够继承预训练模型的强大先验,以建模新的3D知识。此外,MV-Adapter还提供了统一的条件编码器,无缝整合相机参数和几何信息,支持基于文本和图像的3D生成以及纹理映射等应用。MV-Adapter在Stable Diffusion XL(SDXL)上实现了768分辨率的多视图生成,并展示了其适应性和多功能性,能够扩展到任意视图生成,开启更广泛的应用可能性。

高效的文本到音频生成模型,具有潜在一致性。

AudioLCM是一个基于PyTorch实现的文本到音频生成模型,它通过潜在一致性模型来生成高质量且高效的音频。该模型由Huadai Liu等人开发,提供了开源的实现和预训练模型。它能够将文本描述转化为接近真实的音频,具有重要的应用价值,尤其是在语音合成、音频制作等领域。

一致且可控的角色动画图像到视频合成

Animate Anyone旨在通过驱动信号从静态图像生成角色视频。我们利用扩散模型的力量,提出了一个专为角色动画量身定制的新框架。为了保持参考图像中复杂外观特征的一致性,我们设计了ReferenceNet来通过空间注意力合并详细特征。为了确保可控性和连续性,我们引入了一个高效的姿势指导器来指导角色的动作,并采用了一种有效的时间建模方法,以确保视频帧之间的平滑跨帧过渡。通过扩展训练数据,我们的方法可以为任意角色制作动画,与其他图像到视频方法相比,在角色动画方面取得了出色的结果。此外,我们在时尚视频和人类舞蹈合成的基准上评估了我们的方法,取得了最先进的结果。

DiffPortrait3D可以从野外单张人像照片中合成逼真的3D一致新视角。

DiffPortrait3D是一个条件化难度模型,即使只有野外单张人像照片,也能合成逼真的3D一致新视角。具体来说,给定单张RGB输入图像,我们目标是合成从新相机视角渲染的似是而非的面部细节,同时保留身份和面部表达。我们的零试验方法可以很好地推广到任意面部人像,具有非姿态相机视角,极端面部表情和多种艺术描绘。在其核心,我们利用在大规模图像数据集上预训练的2D难度模型的生成先验作为我们的呈现主干,同时通过解耦外观和相机姿势的定向注意控制来指导去噪。为此,我们首先从参考图像将外观上下文注入冻结的UNet的自我注意力层。然后通过一种新颖的条件控制模块来操纵呈现视图,该模块通过观看来自同一视图的交叉主体的条件图像来解释相机姿势。 此外,我们插入了一个可训练的跨视图注意力模块来增强视图一致性,后者通过在推理期间采用一种新的3D感知噪声生成过程进一步加强。我们在具有挑战性的野外和多视图基准测试中定性和定量地证明了最先进的结果。

高度写实的文本到图像模型

Deep floyd是一个开源的文本到图像模型,具有高度的写实性和语言理解能力。它由一个冻结的文本编码器和三个级联的像素扩散模块组成:一个基础模型用于根据文本提示生成 64x64 像素的图像,以及两个超分辨率模型,分别用于生成分辨率逐渐增加的图像:256x256 像素和 1024x1024 像素。模型的所有阶段都利用基于 T5 transformer 的冻结文本编码器来提取文本嵌入,然后将其输入到一个增强了交叉注意力和注意力池化的 UNet 架构中。这个高效的模型在性能上超过了当前的最先进模型,在 COCO 数据集上实现了零样本 FID 得分为 6.66。我们的工作强调了级联扩散模型的第一阶段中更大的 UNet 架构的潜力,并展示了文本到图像合成的一个有前途的未来。

© 2026 AIbase 备案号:闽ICP备08105208号-14