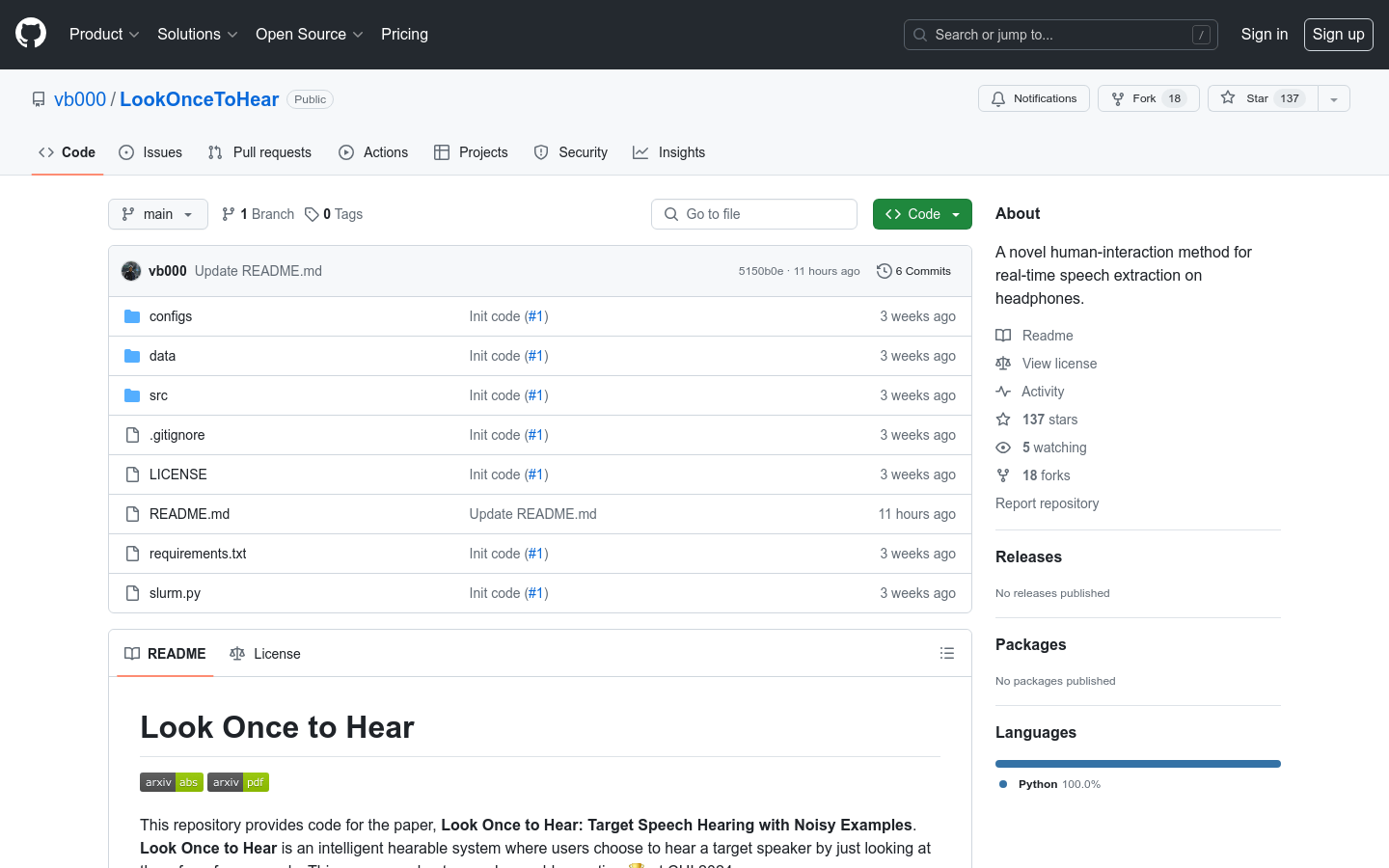

LookOnceToHear 是一种创新的智能耳机交互系统,允许用户通过简单的视觉识别来选择想要听到的目标说话者。这项技术在 CHI 2024 上获得了最佳论文荣誉提名。它通过合成音频混合、头相关传输函数(HRTFs)和双耳房间脉冲响应(BRIRs)来实现实时语音提取,为用户提供了一种新颖的交互方式。

需求人群:

"该产品适合需要在嘈杂环境中进行语音识别和提取的研究人员和开发者。例如,它可以帮助听力障碍者在嘈杂环境中更好地理解对话,或者在多声源环境中进行语音分析和处理。"

使用场景示例:

在会议中,通过 LookOnceToHear 选择听取特定发言人的声音

在嘈杂的公共场所,帮助听力障碍者集中听取对话

在音频分析研究中,用于区分和提取多个声源

产品特色:

用户通过看向目标说话者几秒钟来选择想要听到的声音

使用 Scaper 工具包合成生成音频混合

提供自包含的数据集和训练用的 .jams 规范文件

支持实时语音提取和目标语音听力模型的评估

提供了模型的检查点,方便用户进行训练和评估

适用于嘈杂环境下的语音识别和提取

使用教程:

下载并解压提供的 .zip 文件到 data/ 目录

运行命令以开始训练过程

使用 Scaper 的 generate_from_jams 函数在 .jams 规范文件上生成音频混合

下载并加载目标语音听力模型的检查点进行评估

根据需要调整模型参数以优化性能

在实际应用中,用户只需看向目标说话者即可开始语音提取

浏览量:200

最新流量情况

月访问量

4.93m

平均访问时长

00:06:29

每次访问页数

6.10

跳出率

36.08%

流量来源

直接访问

54.82%

自然搜索

31.76%

邮件

0.04%

外链引荐

11.31%

社交媒体

1.86%

展示广告

0

截止目前所有流量趋势图

地理流量分布情况

中国

12.56%

德国

3.93%

印度

9.82%

俄罗斯

5.43%

美国

18.51%

实时语音提取智能耳机交互系统

LookOnceToHear 是一种创新的智能耳机交互系统,允许用户通过简单的视觉识别来选择想要听到的目标说话者。这项技术在 CHI 2024 上获得了最佳论文荣誉提名。它通过合成音频混合、头相关传输函数(HRTFs)和双耳房间脉冲响应(BRIRs)来实现实时语音提取,为用户提供了一种新颖的交互方式。

语音转文字,支持实时语音识别、录音文件识别等

腾讯云语音识别(ASR)为开发者提供语音转文字服务的最佳体验。语音识别服务具备识别准确率高、接入便捷、性能稳定等特点。腾讯云语音识别服务开放实时语音识别、一句话识别和录音文件识别三种服务形式,满足不同类型开发者需求。技术先进,性价比高,多语种支持,适用于客服、会议、法庭等多场景。

多语种语音理解模型,提供高精度语音识别与情感识别。

SenseVoice是一个包含自动语音识别(ASR)、语音语言识别(LID)、语音情感识别(SER)和音频事件检测(AED)等多语音理解能力的语音基础模型。它专注于高精度多语种语音识别、语音情感识别和音频事件检测,支持超过50种语言,识别性能超越Whisper模型。模型采用非自回归端到端框架,推理延迟极低,是实时语音处理的理想选择。

首款AI智能体耳机,无需手机即可语音唤醒AI助手。

Ola Friend是字节跳动豆包推出的首款AI智能体耳机,它通过接入豆包大模型,与豆包APP深度结合,实现了无需打开手机即可通过语音唤醒AI助手的功能。这款耳机在信息查询、旅游出行、英语学习及情感交流等场景为用户提供帮助,旨在成为用户随时陪伴的朋友。产品采用了OWS(Open Wearable Stereo)专利技术,实现了无感佩戴、不入耳、音响级声效和超长续航等特点。

实时语音翻译APP

speakSync是一个基于人工智能的实时语音翻译APP。它能够实现多种语言之间的即时翻译,支持语音转文本和文本转语音,采用了OpenAI的Whisper和GPT模型,实现了流畅准确的翻译效果。该APP专为旅行者、商务人士和语言学习者设计,简化了翻译流程,创建无障碍的跨语言交流环境。

提供语音识别、语音合成等语音AI能力

依图语音开放平台为开发者提供语音识别、语音合成等语音AI能力,包括精准语音转文本、文本转语音合成、声纹识别、语音增强降噪等服务,支持不同场景下的语音交互应用开发。平台提供高效、灵活的语音AI能力接入方式,可轻松将语音技术应用于各类产品与业务场景。

实时浏览器端语音识别应用

Moonshine Web是一个基于React和Vite构建的简单应用,它运行了Moonshine Base,这是一个针对快速准确自动语音识别(ASR)优化的强大语音识别模型,适用于资源受限的设备。该应用在浏览器端本地运行,使用Transformers.js和WebGPU加速(或WASM作为备选)。它的重要性在于能够为用户提供一个无需服务器即可在本地进行语音识别的解决方案,这对于需要快速处理语音数据的应用场景尤为重要。

让应用通过语音与文本的转换实现智能交互。

Azure 认知服务语音是微软推出的一款语音识别与合成服务,支持超过100种语言和方言的语音转文本和文本转语音功能。它通过创建可处理特定术语、背景噪音和重音的自定义语音模型,提高听录的准确度。此外,该服务还支持实时语音转文本、语音翻译、文本转语音等功能,适用于多种商业场景,如字幕生成、通话后听录分析、视频翻译等。

实时零唇语音转换的流式上下文感知语言建模

StreamVoice是一种基于语言模型的零唇语音转换模型,可实现实时转换,无需完整的源语音。它采用全因果上下文感知语言模型,结合时间独立的声学预测器,能够在每个时间步骤交替处理语义和声学特征,从而消除对完整源语音的依赖。为了增强在流式处理中可能出现的上下文不完整而导致的性能下降,StreamVoice通过两种策略增强了语言模型的上下文感知性:1)教师引导的上下文预见,在训练过程中利用教师模型总结当前和未来的语义上下文,引导模型对缺失上下文进行预测;2)语义屏蔽策略,促进从先前受损的语义和声学输入进行声学预测,增强上下文学习能力。值得注意的是,StreamVoice是第一个基于语言模型的流式零唇语音转换模型,无需任何未来预测。实验结果表明,StreamVoice具有流式转换能力,同时保持与非流式语音转换系统相媲美的零唇性能。

声波 - 语音识别和翻译

SpeechPulse是一款语音识别和翻译软件。它使用OpenAI的Whisper语音到文本模型,实现实时的语音识别,支持多种语言。用户可以使用麦克风输入文字,也可以通过转录音视频文件进行语音识别和翻译。SpeechPulse可以在各种场景下使用,例如办公文档编辑、网页浏览、文件转录、视频字幕生成等。它具有极高的准确性和低延迟,并且完全离线使用。SpeechPulse提供免费版和付费版,付费版支持更多功能和更好的准确性。

智能语音旗舰应用,无障碍语言记录与交流。

汉王语音王App是汉王科技基于自研多模态天地大模型,自主研发的智能语音旗舰应用。它集AI语音记录、智能翻译与同声传译于一体,支持AI精准转写、拍录同步、话稿整理、智能总结及不间断实时翻译等功能。依托全栈AI技术,汉王语音王致力于帮助用户跨越语言障碍,提高办公、学习、会议、旅游等场景的效率和便捷性。

boff.ai是一款AI助手,帮助用户提供智能的语音识别和自然语言处理服务。

boff.ai是一款基于人工智能的语音识别和自然语言处理技术的网站。它的主要优点是快速准确地识别用户的语音输入并能够理解其意图,从而提供相应的回答和建议。boff.ai的定位是提供智能的语音助手服务,帮助用户更高效地处理信息和完成任务。

智能眼镜,集成AI、实时翻译和音乐识别功能

Ray-Ban Meta Glasses是Meta公司推出的一款智能眼镜,它通过集成最新的软件更新,提供了包括实时AI、实时翻译和Shazam音乐识别在内的多种功能。这款眼镜允许用户完全无需动手,就能体验世界、分享个人视角和捕捉重要时刻。产品背景信息显示,Ray-Ban Meta Glasses通过定期的软件更新不断增强功能,使其变得更加智能和有用。

Sesame AI 是一款先进的语音合成平台,能够生成自然对话式语音并具备情感智能。

Sesame AI 代表了下一代语音合成技术,通过结合先进的人工智能技术和自然语言处理,能够生成极其逼真的语音,具备真实的情感表达和自然的对话流程。该平台在生成类似人类的语音模式方面表现出色,同时能够保持一致的性格特征,非常适合内容创作者、开发者和企业,用于为其应用程序增添自然语音功能。目前尚不清楚其具体价格和市场定位,但其强大的功能和广泛的应用场景使其在市场上具有较高的竞争力。

实时语音翻译,跨语言沟通的桥梁。

StreamSpeech是一款基于多任务学习的实时语音到语音翻译模型。它通过统一框架同时学习翻译和同步策略,有效识别流式语音输入中的翻译时机,实现高质量的实时通信体验。该模型在CVSS基准测试中取得了领先的性能,并能提供低延迟的中间结果,如ASR或翻译结果。

快速准确的边缘设备自动语音识别模型

Moonshine 是一系列为资源受限设备优化的语音转文本模型,非常适合实时、设备上的应用程序,如现场转录和语音命令识别。在 HuggingFace 维护的 OpenASR 排行榜中使用的测试数据集上,Moonshine 的词错误率(WER)优于同样大小的 OpenAI Whisper 模型。此外,Moonshine 的计算需求随着输入音频的长度而变化,这意味着较短的输入音频处理得更快,与 Whisper 模型不同,后者将所有内容都作为 30 秒的块来处理。Moonshine 处理 10 秒音频片段的速度是 Whisper 的 5 倍,同时保持相同或更好的 WER。

实时语音交互的人工智能对话系统。

Listening-while-Speaking Language Model (LSLM)是一款旨在提升人机交互自然度的人工智能对话模型。它通过全双工建模(FDM)技术,实现了在说话时同时监听的能力,增强了实时交互性,尤其是在生成内容不满意时能够被打断和实时响应。LSLM采用了基于token的解码器仅TTS进行语音生成,以及流式自监督学习(SSL)编码器进行实时音频输入,通过三种融合策略(早期融合、中期融合和晚期融合)探索最佳交互平衡。

在线语音合成与语音识别服务

TTSLabs是一款在线语音合成与语音识别服务,提供高质量、自然流畅的语音合成和准确可靠的语音识别功能。通过简单的API调用,用户可以将文字转化为真实的语音,并且可以将语音转化为文本。TTSLabs提供多种语音风格和多国语言的支持,具有快速响应、高效稳定的特点。价格灵活透明,适用于个人开发者和企业用户。

实时AI语音转文字/文字转语音解决方案

Speech Intellect是第一个实时工作的语音转文字/文字转语音解决方案,完全使用了全新的AI专注的数学理论——Sense Theory。它考虑了客户发音的每个单词的意义。我们的解决方案基于自主研发的Sense-to-Sense算法,可以实现文本以带有语调和特定调性的声音重新产生。该解决方案可以轻松集成到各种业务场景中,如视频游戏中以人形声音复制脚本文本、呼叫中心与客户的交流、网站上的虚拟对话、智能家居中的舒适对话等等。我们的算法使用的是Sense,与市场上其他解决方案的算法不同。

本地部署的AI语音工具箱,支持语音识别、转录和转换。

Easy Voice Toolkit是一个基于开源语音项目的AI语音工具箱,提供包括语音模型训练在内的多种自动化音频工具。该工具箱能够无缝集成,形成完整的工作流程,用户可以根据需要选择性使用这些工具,或按顺序使用,逐步将原始音频文件转换为理想的语音模型。

实时对话式人工智能,一键式API接入。

Deepgram Voice Agent API 是一个统一的语音到语音API,它允许人类和机器之间进行自然听起来的对话。该API由行业领先的语音识别和语音合成模型提供支持,能够自然且实时地听、思考和说话。Deepgram致力于通过其语音代理API推动语音优先AI的未来,通过集成先进的生成AI技术,打造能够进行流畅、类似人类语音代理的业务世界。

DuRT 是一款 macOS 上的实时语音识别和翻译软件,致力于提供高效、准确的语音处理服务。

DuRT 是一款专注于 macOS 系统的语音识别和翻译工具。它通过本地 AI 模型和系统服务实现语音的实时识别与翻译,支持多种语音识别方法,提高了识别的准确度和语言支持范围。该产品以悬浮框形式展示结果,方便用户在使用过程中快速获取信息。其主要优点包括高准确度、隐私保护(不收集用户信息)以及便捷的操作体验。DuRT 定位为一款高效生产力工具,旨在帮助用户在多语言环境下更高效地进行沟通和工作。目前产品可在 Mac App Store 下载,具体价格未在页面中明确提及。

实时翻译器,捕捉来自WINDOWS扬声器和麦克风的任何音频

Hanami Live Translator是一个实时翻译器,可以捕捉来自WINDOWS扬声器和麦克风的任何音频。它使用轻量级多进程和分块处理音频,每个块处理时间约为3-5秒。该应用程序通过低级访问创建硬件回环,即使扬声器静音,也可以监听内容。它使用soundcard库捕获音频信号,SpeechRecognition库将二进制音频转换为文本,selenium库模拟deepl服务器的网络调用进行免费翻译。该应用程序需要与互联网连接才能运行,并通过Traces.log文件记录所有操作。

人工智能助手的实时文本转语音

Deepgram Aura 是一个创新的文本转语音模型,提供与真人对话相似的音质,速度和成本比其他语音 AI 解决方案更高效。它适用于构建实时的 AI 助手和代理程序,能够以自然的方式与人类交互。Aura 可独立使用,也可以与 Deepgram 的 Nova-2 语音转文本 API 配合使用,为开发人员提供一个完整的语音 AI 平台,帮助他们构建未来的高吞吐量、实时的 AI 助手。

联合语音转录和实体识别的先进模型

Whisper-NER是一个创新的模型,它允许同时进行语音转录和实体识别。该模型支持开放类型的命名实体识别(NER),能够识别多样化和不断演变的实体。Whisper-NER旨在作为自动语音识别(ASR)和NER下游任务的强大基础模型,并且可以在特定数据集上进行微调以提高性能。

© 2026 AIbase 备案号:闽ICP备08105208号-14