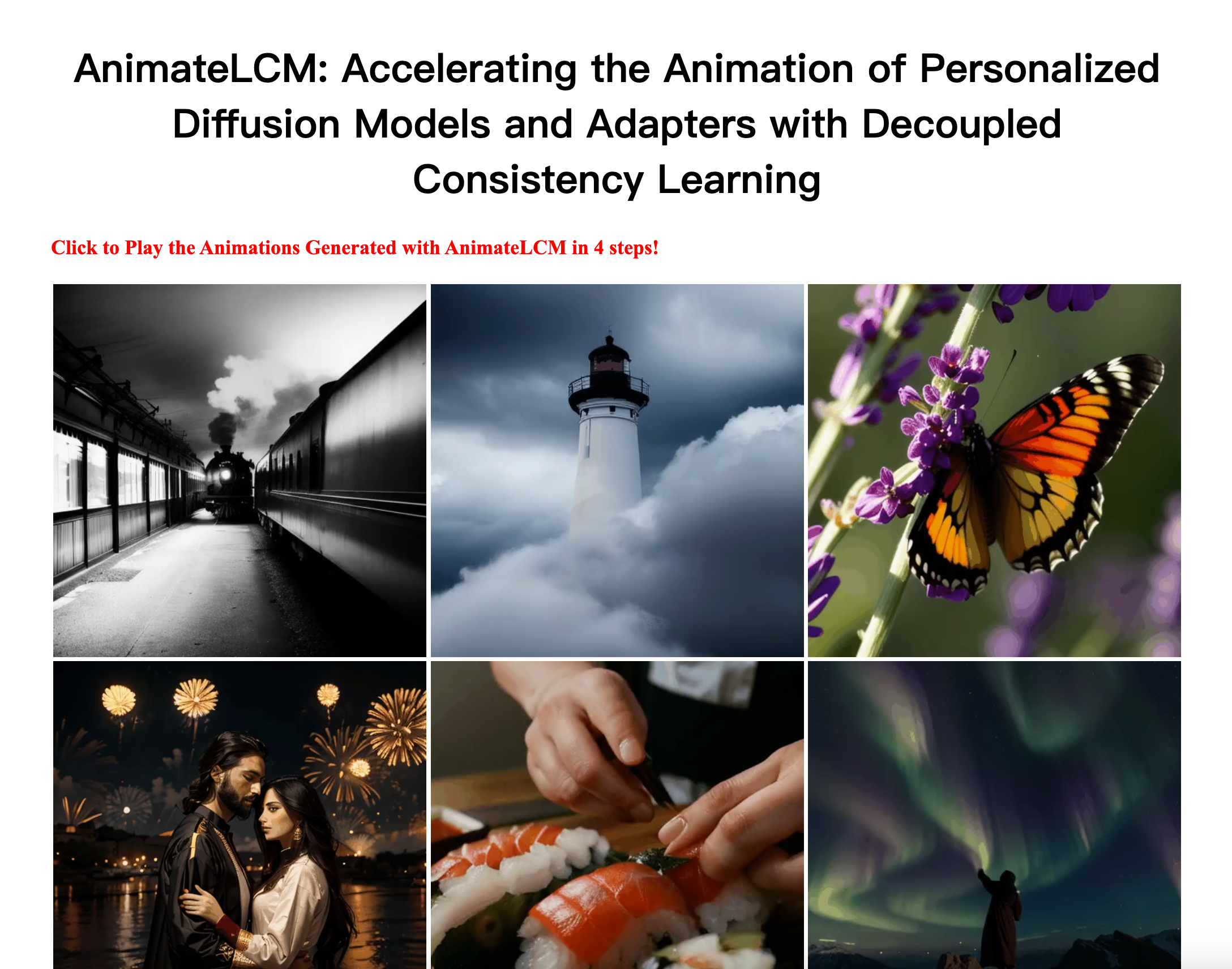

AnimateLCM是一个使用深度学习生成动画视频的模型。它可以仅使用极少的采样步骤就生成高保真的动画视频。与直接在原始视频数据集上进行一致性学习不同,AnimateLCM采用了解耦的一致性学习策略,将图像生成先验知识和运动生成先验知识的萃取进行解耦,从而提高了训练效率并增强了生成的视觉质量。此外,AnimateLCM还可以与Stable Diffusion社区的插件模块配合使用,实现各种可控生成功能。AnimateLCM已经在基于图像的视频生成和基于布局的视频生成中验证了其性能。

需求人群:

["动画视频生成","可控生成","少样本视频生成"]

使用场景示例:

使用文字描述生成动漫人物打篮球动画

根据风景图片生成第一人称游览动画

输入楼宇平面图生成逼真建筑内部走动动画

产品特色:

使用极少采样步骤生成高保真动画视频

采用解耦一致性学习策略

可与Stable Diffusion插件模块配合实现各种控制

支持基于文本、图像、布局的视频生成

浏览量:1030

最新流量情况

月访问量

1483

平均访问时长

00:00:00

每次访问页数

1.06

跳出率

40.91%

流量来源

直接访问

38.97%

自然搜索

37.66%

邮件

0.26%

外链引荐

12.94%

社交媒体

7.96%

展示广告

0

截止目前所有流量趋势图

地理流量分布情况

法国

23.98%

土耳其

10.19%

美国

65.83%

这是一个使用深度学习为文字描述生成动画视频的模型

AnimateLCM是一个使用深度学习生成动画视频的模型。它可以仅使用极少的采样步骤就生成高保真的动画视频。与直接在原始视频数据集上进行一致性学习不同,AnimateLCM采用了解耦的一致性学习策略,将图像生成先验知识和运动生成先验知识的萃取进行解耦,从而提高了训练效率并增强了生成的视觉质量。此外,AnimateLCM还可以与Stable Diffusion社区的插件模块配合使用,实现各种可控生成功能。AnimateLCM已经在基于图像的视频生成和基于布局的视频生成中验证了其性能。

创新的AI视频生成器,快速实现创意视频。

Luma AI的Dream Machine是一款AI视频生成器,它利用先进的AI技术,将用户的想法转化为高质量、逼真的视频。它支持从文字描述或图片开始生成视频,具有高度的可扩展性、快速生成能力和实时访问功能。产品界面用户友好,适合专业人士和创意爱好者使用。Luma AI的Dream Machine不断更新,以保持技术领先,为用户提供持续改进的视频生成体验。

高效的音频驱动 Avatar 视频生成与自适应身体动画。

OmniAvatar 是一种先进的音频驱动视频生成模型,能够生成高质量的虚拟形象动画。其重要性在于结合了音频和视觉内容,实现高效的身体动画,适用于各种应用场景。该技术利用深度学习算法,实现高保真的动画生成,支持多种输入形式,定位于影视、游戏和社交领域。该模型是开源的,促进了技术的共享与应用。

革命性深度学习工具,用于面部转换和视频生成。

DeepFuze是与ComfyUI无缝集成的先进深度学习工具,用于革新面部转换、lipsyncing、视频生成、声音克隆和lipsync翻译。利用先进的算法,DeepFuze使用户能够以无与伦比的真实性结合音频和视频,确保完美的面部动作同步。这一创新解决方案非常适合内容创作者、动画师、开发者以及任何希望以先进的AI驱动功能提升其视频编辑项目的人士。

Freepik AI 视频生成器,基于人工智能技术快速生成高质量视频内容。

Freepik AI 视频生成器是一款基于人工智能技术的在线工具,能够根据用户输入的初始图像或描述快速生成视频。该技术利用先进的 AI 算法,实现视频内容的自动化生成,极大地提高了视频创作的效率。产品定位为创意设计人员和视频制作者提供快速、高效的视频生成解决方案,帮助用户节省时间和精力。目前该工具处于 Beta 测试阶段,用户可以免费试用其功能。

通过文本生成高质量AI视频

Sora视频生成器是一个可以通过文本生成高质量AI视频的在线网站。用户只需要输入想要生成视频的文本描述,它就可以使用OpenAI的Sora AI模型,转换成逼真的视频。网站还提供了丰富的视频样例,详细的使用指南和定价方案等。

基于 AI 技术生成视频内容的智能服务。

清影 AI 视频生成服务是一个创新的人工智能平台,旨在通过智能算法生成高质量的视频内容。该服务适合各种行业用户,能够快速便捷地生成富有创意的视觉内容。无论是商业广告、教育课程还是娱乐视频,清影 AI 都能提供优质的解决方案。该产品依托于先进的 GLM 大模型,确保生成内容的准确性与丰富性,同时满足用户个性化需求。提供免费试用,鼓励用户探索 AI 视频创作的无限可能。

利用AI技术快速生成视频内容

AI视频生成神器是一款利用人工智能技术,将图片或文字转换成视频内容的在线工具。它通过深度学习算法,能够理解图片和文字的含义,自动生成具有吸引力的视频内容。这种技术的应用,极大地降低了视频制作的成本和门槛,使得普通用户也能轻松制作出专业级别的视频。产品背景信息显示,随着社交媒体和视频平台的兴起,用户对视频内容的需求日益增长,而传统的视频制作方式成本高、耗时长,难以满足快速变化的市场需求。AI视频生成神器的出现,正好填补了这一市场空白,为用户提供了一种快速、低成本的视频制作解决方案。目前,该产品提供免费试用,具体价格需要在网站上查询。

利用AI技术,将文字和图像转化为创意视频。

通义万相AI创意作画是一款利用人工智能技术,将用户的文字描述或图像转化为视频内容的产品。它通过先进的AI算法,能够理解用户的创意意图,自动生成具有艺术感的视频。该产品不仅能够提升内容创作的效率,还能激发用户的创造力,适用于广告、教育、娱乐等多个领域。

快速因果视频生成器,实现即时视频生成。

CausVid是一个先进的视频生成模型,它通过将预训练的双向扩散变换器适配为因果变换器,实现了即时视频帧的生成。这一技术的重要性在于它能够显著减少视频生成的延迟,使得视频生成能够以交互式帧率(9.4FPS)在单个GPU上进行流式生成。CausVid模型支持从文本到视频的生成,以及零样本图像到视频的生成,展现了视频生成技术的新高度。

视频生成AI模型,能够根据文本描述生成高质量视频

VideoCrafter2是一个视频生成AI模型,能够根据文本描述生成高质量、流畅的视频。它通过克服数据局限,实现了高质量视频生成的目标。该模型可以生成照片级质量的视频,支持精细的运动控制和概念组合。用户只需要提供文本描述,VideoCrafter2就可以自动生成剧本级别的视频作品,可用于视频创作、动画制作等领域。

视频到音频生成模型

vta-ldm是一个专注于视频到音频生成的深度学习模型,能够根据视频内容生成语义和时间上与视频输入对齐的音频内容。它代表了视频生成领域的一个新突破,特别是在文本到视频生成技术取得显著进展之后。该模型由腾讯AI实验室的Manjie Xu等人开发,具有生成与视频内容高度一致的音频的能力,对于视频制作、音频后期处理等领域具有重要的应用价值。

开源视频生成模型,支持多种生成任务。

Wan2.1-FLF2V-14B 是一个开源的大规模视频生成模型,旨在推动视频生成领域的进步。该模型在多项基准测试中表现优异,支持消费者级 GPU,能够高效生成 480P 和 720P 的视频。它在文本到视频、图像到视频等多个任务中表现出色,具有强大的视觉文本生成能力,适用于各种实际应用场景。

一站式AI视频生成器,为动画视频系列提供服务。

AnimateAI是一个集成了前沿AI技术的视频生成器,能够以10倍的速度和节省30%的成本,提供连贯角色的惊人视频系列。它允许用户通过简单的文本提示,快速将想法转化为高质量的视频,无论是动画故事、动态预告片、励志短片、温馨的儿童睡前故事、放松的lofi音乐视频还是有趣的喜剧小品,AnimateAI都能轻松实现。产品背景信息显示,AnimateAI支持多种AI模型和工具,如GPT-4、Claude、Gemini、FLUX、MidJourney等,以解锁用户的故事讲述潜力。AnimateAI的价格定位是免费试用和付费订阅,旨在帮助用户无需技术技能即可创造令人惊叹的动画视频。

AI驱动的视频生成工具,一键生成高质量营销视频

小视频宝(ClipTurbo)是一个AI驱动的视频生成工具,旨在帮助用户轻松创建高质量的营销视频。该工具利用AI技术处理文案、翻译、图标匹配和TTS语音合成,最终使用manim渲染视频,避免了纯生成式AI被平台限流的问题。小视频宝支持多种模板,用户可以根据需要选择分辨率、帧率、宽高比或屏幕方向,模板将自动适配。此外,它还支持多种语音服务,包括内置的EdgeTTS语音。目前,小视频宝仍处于早期开发阶段,仅提供给三花AI的注册用户。

真实人类舞蹈视频生成

MagicDance是一种新颖有效的方法,可以生成逼真的人类视频,实现生动的动作和面部表情转移,以及一致的2D卡通风格动画零调优生成。通过MagicDance,我们可以精确生成外观一致的结果,而原始的T2I模型(如稳定扩散和ControlNet)很难准确地保持主题身份信息。此外,我们提出的模块可以被视为原始T2I模型的扩展/插件,而不需要修改其预训练权重。

AI视频生成平台

Synthesia是一款AI视频生成平台,可以帮助用户在超过120种语言中创建专业的视频,无需麦克风、摄像头或演员。它提供了AI化身和语音合成功能,用户可以通过简单的操作创建高质量的视频内容。Synthesia适用于各种场景,包括广告制作、教育培训、视频营销等。平台提供灵活的定价方案,用户可以根据自己的需求选择适合的套餐。

AI 视频生成器,快速简单生成 AI 视频

Colossyan Creator 是一款 AI 视频生成器,能够从文本快速生成 AI 视频。它提供了丰富的功能,包括根据文本创建学习视频、将 PDF 和 PPT 转化为视频、选择多样的 AI 主持人、自动翻译为多种语言等。Colossyan Creator 可广泛应用于企业学习、培训以及企业内部沟通等场景。定价方面,请咨询官方网站了解详细信息。

Pusa 是一个新颖的视频扩散模型,支持多种视频生成任务。

Pusa 通过帧级噪声控制引入视频扩散建模的创新方法,能够实现高质量的视频生成,适用于多种视频生成任务(文本到视频、图像到视频等)。该模型以其卓越的运动保真度和高效的训练过程,提供了一个开源的解决方案,方便用户进行视频生成任务。

使用简单的提示和图像生成视频片段。

Adobe Firefly 是一款基于人工智能技术的视频生成工具。它能够根据用户提供的简单提示或图像快速生成高质量的视频片段。该技术利用先进的 AI 算法,通过对大量视频数据的学习和分析,实现自动化的视频创作。其主要优点包括操作简单、生成速度快、视频质量高。Adobe Firefly 面向创意工作者、视频制作者以及需要快速生成视频内容的用户,提供高效、便捷的视频创作解决方案。目前该产品处于 Beta 测试阶段,用户可以免费使用,未来可能会根据市场需求和产品发展进行定价和定位。

开源的文本到视频生成模型

CogVideo是由清华大学团队开发的文本到视频生成模型,它通过深度学习技术将文本描述转换为视频内容。该技术在视频内容创作、教育、娱乐等领域具有广泛的应用前景。CogVideo模型通过大规模预训练,能够生成与文本描述相匹配的视频,为视频制作提供了一种全新的自动化方式。

用于视频生成的下一帧预测模型。

FramePack 是一个创新的视频生成模型,旨在通过压缩输入帧的上下文来提高视频生成的质量和效率。其主要优点在于解决了视频生成中的漂移问题,通过双向采样方法保持视频质量,适合需要生成长视频的用户。该技术背景来源于对现有模型的深入研究和实验,以改进视频生成的稳定性和连贯性。

音频处理和生成的深度学习库

AudioCraft 是一个用于音频处理和生成的 PyTorch 库。它包含了两个最先进的人工智能生成模型:AudioGen 和 MusicGen,可以生成高质量的音频。AudioCraft 还提供了 EnCodec 音频压缩 / 分词器和 Multi Band Diffusion 解码器等功能。该库适用于音频生成的深度学习研究。

一种提升场景级视频生成能力的技术。

长上下文调优(LCT)旨在解决当前单次生成能力与现实叙事视频制作之间的差距。该技术通过数据驱动的方法直接学习场景级一致性,支持交互式多镜头开发和合成生成,适用于视频制作的各个方面。

AI视频创作工具,将老照片转化为动态视频。

京亦智能AI视频生成神器是一款利用人工智能技术,将静态的老照片转化为动态视频的产品。它结合了深度学习和图像处理技术,使得用户能够轻松地将珍贵的老照片复活,创造出具有纪念意义的视频内容。该产品的主要优点包括操作简便、效果逼真、个性化定制等。它不仅能够满足个人用户对于家庭影像资料的整理和创新需求,也能为商业用户提供一种新颖的营销和宣传方式。目前,该产品提供免费试用,具体价格和定位信息需进一步了解。

通过测试时间缩放显著提升视频生成质量。

Video-T1 是一个视频生成模型,通过测试时间缩放技术(TTS)显著提升生成视频的质量和一致性。该技术允许在推理过程中使用更多的计算资源,从而优化生成结果。相较于传统的视频生成方法,TTS 能够提供更高的生成质量和更丰富的内容表达,适用于数字创作领域。该产品的定位主要面向研究人员和开发者,价格信息未明确。

将AI生成的图像转化为炫酷动画视频!

SpicyGen是一款AI视频生成工具,用户可以上传AI生成的图像,描述动作,让AI生成独特引人注目的视频内容。该工具主要优点在于快速将静态图像转化为生动动画视频,帮助用户轻松制作个性化视频内容。SpicyGen的定位是为创意设计人员、社交媒体达人以及内容创作者提供创意无限的视频制作工具。

© 2026 AIbase 备案号:闽ICP备08105208号-14