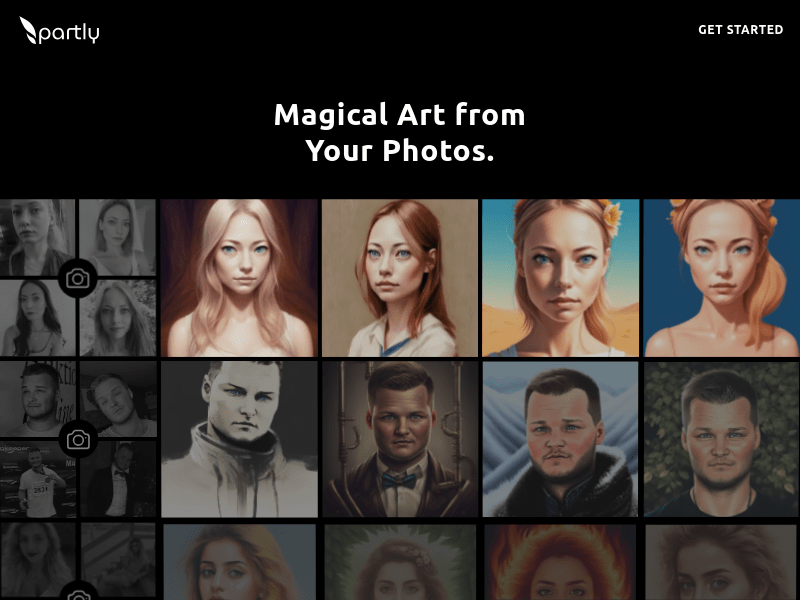

Partly AI是一款使用人工智能技术的艺术创作工具,可以将您的照片转化为令人惊叹的艺术作品。它通过AI魔法将您的照片转换成独特的艺术风格,让您的照片焕发新的生命。Partly AI的功能包括自动图像处理、艺术风格转换和智能滤镜等。它能够在几秒钟内完成图像转换,并提供多种艺术风格供您选择。Partly AI的优势在于其高质量的艺术效果和易于使用的界面。您只需上传照片,选择艺术风格,即可获得令人惊叹的艺术作品。Partly AI的定价策略灵活多样,包括按需付费和订阅付费两种选择。它适用于个人用户、摄影师、设计师等多个用户群体,为您的照片增添艺术的魅力。

需求人群:

适用于个人用户、摄影师、设计师等多个用户群体

产品特色:

自动图像处理

艺术风格转换

智能滤镜

多种艺术风格选择

浏览量:36

用人工智能创作照片与艺术品

AI艺术有限公司通过人工智能为您创建照片、图像、视频、音乐和文章。使用我们的应用程序,您可以成为使用AI的艺术家。我们的产品具有以下特点: - 利用机器学习为您创作内容 - 提供文本转图片、文本转视频、文本转音乐、文本转AI文本等功能 - 简单易用 - 完全使用人工智能技术 定价和定位:免费试用,订阅套餐可享受更多功能。 使用场景:个人创作、社交媒体、博客、艺术展览、广告等。 标签:AI艺术、AI照片生成器、艺术创作、人工智能

AI驱动的先进照片编辑和艺术创作应用

AI Photo Editor是一款由AI技术支持的高级照片编辑应用,提供无缝直观的体验,适合初学者和专业人士。它是一个一站式设计工作室,可以去除照片中不需要的物体,增强图像质量,应用惊人的滤镜,甚至将照片转换成动漫风格的肖像,所有这些都通过AI精确实现。无论你是出于娱乐目的编辑照片,还是追求专业质量的结果,这款应用都让这个过程变得简单且免费。

AI辅助艺术创作

艺术创作助手是一款利用人工智能辅助艺术家创作的工具。通过训练模型或使用预设的创意灵感,艺术家可以快速创建令人惊艳的艺术品。它可以帮助艺术家增添独特的风格和创意,提供无限的创作灵感,适用于各种艺术创作场景。

AI魔法,将您的照片转化为独特的艺术品!

Partly AI是一款使用人工智能技术的艺术创作工具,可以将您的照片转化为令人惊叹的艺术作品。它通过AI魔法将您的照片转换成独特的艺术风格,让您的照片焕发新的生命。Partly AI的功能包括自动图像处理、艺术风格转换和智能滤镜等。它能够在几秒钟内完成图像转换,并提供多种艺术风格供您选择。Partly AI的优势在于其高质量的艺术效果和易于使用的界面。您只需上传照片,选择艺术风格,即可获得令人惊叹的艺术作品。Partly AI的定价策略灵活多样,包括按需付费和订阅付费两种选择。它适用于个人用户、摄影师、设计师等多个用户群体,为您的照片增添艺术的魅力。

全民艺术创作平台

海艺 AI 是一个全民艺术创作平台,用户可以在平台上发现创意、捕捉灵感并即刻创作,提供丰富的模型和训练工具。海艺 AI 拥有强大的图像处理能力和智能创作算法,用户可以轻松地创建、分享和生成艺术作品。

人工智能入门教程网站,提供全面的机器学习与深度学习知识。

该网站由作者从 2015 年开始学习机器学习和深度学习,整理并编写的一系列实战教程。涵盖监督学习、无监督学习、深度学习等多个领域,既有理论推导,又有代码实现,旨在帮助初学者全面掌握人工智能的基础知识和实践技能。网站拥有独立域名,内容持续更新,欢迎大家关注和学习。

推动人工智能安全治理,促进技术健康发展

《人工智能安全治理框架》1.0版是由全国网络安全标准化技术委员会发布的技术指南,旨在鼓励人工智能创新发展的同时,有效防范和化解人工智能安全风险。该框架提出了包容审慎、确保安全,风险导向、敏捷治理,技管结合、协同应对,开放合作、共治共享等原则。它结合人工智能技术特性,分析风险来源和表现形式,针对模型算法安全、数据安全和系统安全等内生安全风险,以及网络域、现实域、认知域、伦理域等应用安全风险,提出了相应的技术应对和综合防治措施。

数字艺术创作和销售平台

DigArt365是一个数字艺术创作和销售平台,用户可以使用人工智能工具创建并销售图像作品。用户可以通过选择适合自己的网站来开始创作,也可以将作品免费发布或设定价格进行销售。同时,用户还可以在社交媒体上推广自己的作品,以增加销售机会。

编辑照片,创作艺术

AI图像精灵是一款能够激发创作灵感的应用程序。只需输入命令提示符,选择风格,人工智能会在几秒钟内将您的想法转化为图片!您可以选择多种熟悉的艺术风格,如立体派、达利风、合成波、蒸汽朋克等,也可以选择无风格选项。您可以将使用AI图像精灵创作的独特原创艺术品与朋友分享,或者通过#AIPainting标签在社交媒体上走红。您还可以将使用AI图像精灵创作的图片作为您的锁屏,并个性化您的手机。使用AI图像精灵测试您的创造力,释放人工智能带来的惊人力量!立即下载AI图像精灵,开始创作令人惊叹的艺术作品吧!

人工智能驱动的艺术一代

Artful是一个利用人工智能的力量将用户的想法转化为令人惊叹的视觉艺术的应用程序。轻松创作、个人风格适应、无尽的灵感、微调至完美、高分辨率导出、社区参与等功能。适合探索创意表达的未来的用户使用。

京东自主研发的人工智能开放平台

京东人工智能开放平台NeuHub,汇聚京东自主研发的人工智能核心技术,包含语音、图像、视频、NLP等技术,通过平台向外开放,助力行业智能升级。平台还提供数据标注、模型开发、训练和发布等全流程服务,以及创新应用案例,帮助企业实现智能化转型。

ImgPilot是一个由Lepton AI提供支持的AI艺术创作工具

ImgPilot允许用户将草图转换成令人惊叹的艺术作品。它利用Lepton AI的技术,通过用户选择的绘画风格,将简单的草图转化为精美的艺术作品。

无限制的游戏艺术创作工具

Layer AI是一个为游戏工作室提供专业游戏内内容、营销和实时操作艺术创作的平台。它利用人工智能技术,允许用户根据现有的艺术风格创建无限数量的专业游戏资产。Layer AI旨在提高创意与生产力的结合,通过简化创意测试和预生产流程,支持团队协作,并为游戏开发工作室提供强大的工具,以加速游戏资产的生成和优化。

OLAMI是一个人工智能开放平台

OLAMI是一个提供云端API、管理界面、多元机器感知解决方案的人工智能软件开发平台。OLAMI平台具有语音识别、自然语言理解、对话管理、语音合成等语音AI技术,以及图像识别、语义理解等视觉AI技术,可以轻松地为产品加入人工智能,提升用户体验。

用人工智能创作音乐

Text to Music是一个用人工智能创作音乐的网站。它由@markdoppler_创建。首次登录时,系统会向您的电子邮件发送登录链接。您可以输入音乐的英文描述,并选择音频的时长(1到30分钟)。然后,点击生成音频按钮即可创作音乐。您可以在公共音频和我的音频中找到您创作的音乐。

AI技术驱动的照片编辑器,快速将照片转换成艺术图像或卡通头像。

Speed AI Art Photo Editor是一款利用人工智能技术的照片编辑应用,它能够将普通照片转换成艺术风格的照片或者卡通化的头像。这款应用拥有丰富的人像细节设置,用户可以自由选择从发型到表情、身材、皮肤、光线等多种细节,快速创造出新的艺术照片或个性化卡通形象。产品背景信息显示,Speed AI拥有庞大的AI图像模型库和数千种照片素材模板,用户可以根据自己的需求输出不同版本的自己,或者创造一个全新的形象。产品的主要优点包括快速编辑、丰富的细节设置选项、艺术风格多样化以及高保真度的输出控制。

交互式人工智能生成照片辨别小游戏

Real Or AI通过高质量的人工智能生成照片,提供独特的照片辨别游戏体验。用户可以在真实照片和AI生成照片中进行选择,从中测试并提升自己的判断能力。Real Or AI不仅娱乐有趣,也让用户感受到人工智能在图像生成领域巨大的进步。

AI123是一款集成了AI艺术创作的高效应用

AI123是一款集成了AI艺术创作、AI聊天和AI键盘的高效应用,旨在为用户提供高度创造性和便利的AI体验!AI123将带领您探索迷人的AI世界,释放未来科技的无限潜能。在这里,只有无尽的想象力,没有任何限制!功能包括:AI艺术创作,AI聊天,AI键盘等。适用场景广泛,可满足用户不同的需求。

将您的视频/照片/GIF转化为艺术品

NeuralStyler Ultra是一款基于人工智能的图像处理软件,可以将您的视频、照片和GIF转化为名家风格的艺术品,支持Van Gogh、Wassily Kandinsky、Georges Seurat等多种风格。该软件支持CPU/GPU处理,单用户许可证售价为250美元,现在特价100美元。您可以选择任意绘画作品并转移风格,无需训练神经网络,支持图像、视频或GIF文件风格化,支持不同分辨率(高达4K),可控制风格强度,支持视频剪辑和保留原始颜色等功能。付费版本还可以去除水印。

数字艺术创作平台

Dallelist是一个数字艺术创作平台,提供多种艺术形态的数字创作工具,包括数字艺术、3D设计、像素艺术、动画等。用户可以在平台上进行数字创作,也可以欣赏其他用户的作品。平台还提供多种素材和教程,帮助用户提升创作技能。定价方面,平台提供免费和付费两种版本,付费版本提供更多高级功能和素材。

无限可能的AI艺术创作

JourneyDraw是一款具备强大AI引擎的专业绘图软件,采用先进的AI内容生成技术,能够快速创作各种创意作品。通过智能算法将文本转化为艺术风格的图像,重新组合和混合图像生成全新的创作作品,应用变形效果为图像增添独特的视觉吸引力,使用高级放大算法实现无损图像放大,部分图像重绘功能修复损坏区域或添加细节,智能识别和自动去除图像中的不需要元素简化编辑过程,内置提示生成器启发创造力并帮助你踏上创意之旅。支持多种AI引擎类型,包括丰富的图像生成风格,如彩色动漫、逼真艺术、水墨风格、二维作品、动画风格和AI生成应用图标。

AI艺术创作平台,让创意不受限制。

Blendbox是一个基于AI的艺术创作平台,它通过提供非破坏性编辑、层级编辑和重组等功能,增强用户的创造力。用户可以轻松地对作品的各个层进行编辑和调整,实现前所未有的创作自由度。Blendbox的背景信息显示,它是由Blockade Labs开发的,旨在推动AI技术在艺术创作领域的应用。产品定位于专业设计师和艺术创作者,价格方面提供试用,具体定价未在页面中明确。

使用人工智能将文本转换为音频

AI语音生成器是一个简单易用的产品,它使用人工智能技术将文本转换为音频。它提供了多达25种不同的声音,完美演绎英语。您只需在Telegram上输入文本,我们即可回复相应的音频,无需等待。立即试用,快速将文本转换为语音。

根据照片匹配古诗词 生成分享卡片

诗境主要功能就是根据用户上传的图片分析主体和意境,匹配诗句,最终生成漂亮的卡片。不知道你们有没有遇到过,就是拍了一幅很美的照片,想吟诗一首再发个朋友圈,奈何文化程度有限,往往想半天最后配了段大白话。这时候诗境就能派上用场,把图片喂给她,让她给你配个最符合当前画面意境的诗。

端到端的AI艺术创作云工作室

Flush AI是一个端到端的AI艺术创作云工作室,提供稳定扩散模型托管、模型微调、多模态工作流构建等功能,让用户无需关心GPU配置,即可轻松创建AI艺术作品。用户可以免费试用,并按需选择定价计划,灵活快速地进行AI创作。

利用人工智能技术为您的图像创建全新的风格和版本

Freepik Reimagine是一款基于人工智能的图像创作工具,可以利用先进的AI算法为您的现有图像创建全新的版本和风格。无需繁琐的编辑操作,只需上传图像并设置所需的变化,AI就能自动生成全新的图像变体。该工具具有强大的创作能力,可以根据用户需求改变图像的风格、构图、色彩等元素,为您带来无限的创意可能。同时,它操作简单,即使是没有专业背景的用户也能快速上手。无论您是设计师、艺术家还是创意爱好者,都可以利用Freepik Reimagine激发无穷创意,提高工作效率。该工具目前处于公测阶段,免费使用。

一个支持多种AI艺术生成平台的创意工具,让艺术创作更简单。

多平台AI艺术生成器是一个集成了多个AI艺术生成平台的在线工具,如MidJourney、DALL-E 3、Leonardo等,为用户提供了丰富的艺术创作选项。它通过简单的操作流程,允许用户选择不同的AI平台和模型,设置分辨率,输入提示语,并生成艺术作品。该产品的主要优点在于其便捷性、创意性和多样性,它不仅适用于专业设计师寻找灵感,也适合普通用户进行个性化艺术创作。目前,该产品的具体价格和定位信息未在页面上提供。

© 2026 AIbase 备案号:闽ICP备08105208号-14